暦本:

高校生のときAlto[1] のようなグラフィカルなインターフェースに感動したことがきっかけで、ユーザインターフェースに興味を持って。大学時代にはXeroxの工場まで行ってマウスを触らせてもらったりしていました。その後バーチャルリアリティの研究のために留学したんですが、それが'92~'93年ころで、当時だとまだツールのクオリティがあまり良くなくて、未来的な感じがしなかったんですね。なので、こういう仮想世界はあまり趣味じゃないのかなと。

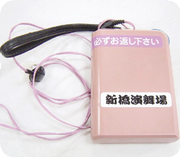

そんなとき、留学前に行った歌舞伎座のイヤホンガイド、あれがユーザインターフェース的にはすごいんじゃないかと思って。あれは同時通訳のツールに見えるけど、実はセリフのときは何も言ってなくて、芝居の合間合間で解説が流れるようになっていますよね、ちょうどエージェントインターフェースのような感じで。芝居というコンテクストは全然壊さずに、イメージを想起するような情報を入れている。つまり「コンテクスト」がインターフェースの鍵なんだなと直感しました。

こういうインターフェースを技術的なことに使えたらどんなに良いかと思って。最初はAltoとかMacとかに感動していたGUIの世界だったんですが、そういうことがGUIの次の世界なんじゃないかと。現実を拡張するような技術――Augmented Realityですね。ちょうどマークワイザーが『ユビキタスコンピューティング』という論文を発表したこともあり、こういうのが自分の進む道かなと思って、実世界指向インターフェースをやり始めたんです。

前田:

ちょうど前回の対談のテーマが、Augmented Realityで。武山氏の場合は、町おこしとして利用しようとしているのですが、場が持っているコンテクストを可視化するというところはさっきの歌舞伎座の話と近いですよね。実際私自身も、Augmented Realityに対して現実解というか何かサービスができるんじゃないかと考えていまして。

私の知人は、それをAugmented Realityと言わないで、Bendingという言葉で表現しています。もともとのコンテクストを崩さないで、代替的な拡張情報を気持ち良く出す、という。ただ、そこのイメージがまだ自分の中では咀嚼できていなくて。ちょっと比喩的に言うと、たとえば自分の好きな音楽だったら、他の人よりも耳に付く、小さな音のはずなのに、自分にとっては大きく感じるような。

暦本:

現実歪曲空間みたいな

前田:

ええ、自分にギュッとやわらかくせり出してくるような。コンテクストを可視化して重ねるだけでなく、さらに曲げるというイメージです。

そのあたりの、こういう微妙な具合が人間にとって気持ちが良いんじゃないかとか、そういったところのインターフェースのご研究はされていますか?

暦本:

そういうインターフェースとは少し毛色が違うんですが、我々が最近“ オーガニックインターフェース” と呼んでいる、オーガニックなインタラクションが次に来るんじゃないかという気がしています。

オーガニックというのは、生物からインスパイアされているという意味です。たとえば普通のマウスというのは、メタファですと石を持って描いているような石器時代の、あれが洗練されたものなんじゃないかと。だからマウスの誕生には道具的な流れがあるということで。

コンピュータも、今までは“ 道具” だったので、頤使的なツールとしてのインターフェースが重要視されてきたんですが、これからはコンピュータそのものをどう使うかという――その先にいる人間とどうコミュニケーションするかとか、あるいは中の情報でも、もっと有機的に触っていきたいとか――そういった使い方になっていくと思うので、能率よりももっと情緒的なことを含めた、オーガニックインターフェースやオーガニックインタラクションという発想が大事なのではと思っています。

前田:

実際のそのインターフェースというのは?

暦本:

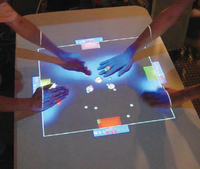

いわゆるマルチタッチって最近Macでも言われていますけれども、テーブル全体がセンサーになっていてそこでマルチタッチできるものとか。インプットだけでなく、向こうから直感でアウトプットで返してくれるものとか。普通、人間って握手すると、0.1秒くらいでも、力の入れ具合とか振り具合とかで、相手が自分をどう思っているかわかっちゃうんですね、ああいう感触というのは、マウスでクリックしてメニューが出るよりむしろ早い。こういうインターフェースは今の技術だったら十分できるんじゃないかと。

情報のテクスチャ

前田:

すごくわかりますね。情報の肌理というんでしょうか、今までの情報がゴツゴツした岩みたいなものだったとしたら、段々と滑らかな感じに変化している。

暦本:

テクスチャな感じ。iPodもあのツルツルの鏡面仕上げになっていることが重要だとか。そういう感覚が段々大事になってきていますね。先ほども言いましたが、マウス的なものの起源は、多分、石器時代とかああいう強い時代じゃないかと。それよりもっと前、道具がないときの動物というのは、直接体温を感じたり毛づくろいしたりしてましたよね。こういった、インターフェースとしてはもっとプリミティブな、生物に近いけれども、逆にそれが最先端の技術でコンピュータとして融合する、というところが重要だと思うんです。

前田:

昨日の夜も飲みながらそんな話をしていて。結局、iPodの裏面のアレをおばちゃんが新潟で作っているということは、国の資産だろう、と(笑) 。おばちゃんの手先の器用さというのは、すぐに他の国が真似できるものではなくて、面々と細かい指先の器用な民族としての積み重ねがあって。

暦本:

金沢の工芸とか、ああいう世界ですよね(笑) 。

前田:

ええ、それで国際的な競争力をつけるのなら、おばちゃんの手先の器用さを活用するようなインターフェースとか、アプリケーションとか、そこから生み出される価値を輸出しなきゃね、と。

フリービット という会社が“ Web to SiLk” というキャッチフレーズを掲げていて、なかなか良いコピーだなと思いました。滑らかで丁寧な絹の手触りのようなインターネットサービスを提供したいっていうコンセプトで付けられたみたいなんですが、シルクとは言い得て妙だなと。微妙な着心地の良さとか軽さとか、綿とは違う高級感というか付加価値を手先で感じることができる。誰が触っても、目を瞑っても明らかにわかる。そういうアプリケーション、サービスができないかと考えています。

暦本:

ニューヨーク大学のジェフ・ハン氏のマルチタッチスクリーン技術[2] などはそういった世界を一部実現しつつあるように思いますね。

人のコンテクストをとる

前田:

もとのコンテクストを邪魔しないで、強調部分を返すという感覚。歌舞伎の例がすごくわかりやすかったのですが、歌舞伎は時間軸上でシナリオが書かれていますよね。不確定な現実空間の中でそれを実現するにはどんなやり方があり得ると思いますか?

暦本:

実は歌舞伎のあれも芝居がリアルタイムなので単純にテープを流しているだけではうまくいかなくて、昔は技師の人が“ このタイミングでコレを出す” 、というのをやっていたらしいです、今はデジタルみたいですが。この“ 今出す” というのがコンテクサーで。なので、リアルワールドで“ 今出す” というのをコンピュータができるようになれば、可能だと思います。

しかし、それにはまだ課題がありまして。まず、人のコンテクストは“ この人はいま渋谷に行きたいのか?” ということを予想するのでも結構大変なので、いろいろ研究しています。たとえば、PlaceEngine[3] のようにロケーションを取れるというのは1つのベースの技術だと思うので、そのライフログ化を行ったり。その人の普段のパターンをどんどん蓄積することで、行動が結構予測できるんじゃないかと。忙しいのかそうでないのか、特殊なことをしているのか普段なのかとか、この人が普段何をやっているかという過去の記録。この過去の記録があると、同じ場所にいて同じ方向に向かって歩いている人でも、目的が違うというのがわかる。なのでコンテクストセンシングというのは、実はライフログと非常に不可分だと思います。

前田:

メールのアクセスログとは違って、あらゆるものが対象になるということですよね。それは、標準化されたりアプリケーションと連動されたりしやすいように、どういうふうに格納されていると取り出しやすいかイメージされたことあります?

暦本:

1つはログとして単純に取れるというのに価値があるんじゃないかと。たとえば写真に全部場所が付くようになるとか。もっと集合的にすると、これがその人のライフパターンを示すものになる。そして、この人がどこにこのぐらいに着くのがどのくらいの確率なのかということがわかるようになる。この情報が、個人のプライベートなスペースに格納されていて、Googleのような一般的なデータベースの検索エンジンとうまく合わさると、たとえば情報検索をするにしても、その人にとって個人化された結果を返すことができるんじゃないかな、ということを今研究しています。

標準化というのはまだわからないです。というのは、その人のことをよく知れば知るほど、その情報は外に出して良いのかということも含めて、いろいろな問題を巻き込んでしまう。今でも、GoogleIDを持っていると、自分の検索キーワードがすべてGoogleに知られている、何に興味を持っているのかがキーワードの遷移を見ているとわかってしまう。それも強力なライフログでしょうが、それをどう扱うかというのは難しい問題ですね。その領域にコンピュータは入ってきていると思いますね。

プライバシーをどう扱うか

前田:

昨年参加した情報航海大プロジェクトの絡みで、プライバシー・プリザーブド・マイニングという技術を知る機会がありました。要は個人情報の取得レベルを段階的に分けていて、自分はこれぐらいだったら個人情報を出しても良いという、ライフログに暗号をかけるだけでなく、個人が特定出来ない情報として加工して、分析/流通させるためのしくみです。まだこれは確立した技術ではないんですが。技術としておもしろいなと。

サービスを出す側としては、データがあったほうが推奨情報の精度が上がるから良いと思うんですが、もしそれができたとして、どんなメリットがあったら、自分の心の内というかさらけ出しても良いのかと考え出したとたんに、思考停止してしまうというか、やはり怖いというか。

暦本:

ええ、つい最近もAmazonのほしい物リスト騒動(注4 がありましたし。プライバシーをどう扱うかというのは、ユビキタスコンピューティングの大きな課題なんです。たとえば、実空間の距離でプライバシー情報が減衰する、あるいは時空間で減衰するような、リアルワールドの情報の減衰量が電子的に応用できないかということを考えています。アイデアはあると思うんですが。電子的なものの怖さというのは、わからないうちに公開されていることですよね。

[4] 自分にプレゼントして欲しい商品を登録・公開できる機能。名前やメールアドレスで検索をかけると、その人の欲しいものリスト(本名で登録している場合は本名も)を見ることができる。デフォルトで公開に設定されているため、ユーザが意図しない個人情報が漏れているということで騒ぎになった。

実空間のインタラクション

前田:

そうですよね。空間ってそういう問題を解決していて、たとえば壁があるからこの話は4人しか聞いてないだろう、という担保があるじゃないですか。

暦本:

これが仮にマイクだったらこの話題はよしてくれ、ということもありますしね。

前田:

この前、武山先生の学生さんのプレゼンの中で、今この会場にいる人だけでどこに飲みにいくかということを携帯で集計できたらおもしろいね、という話が出たときに、ハッと思ったんです、距離じゃないんですよね。この壁の内側にいる人だけで多数決をしようというのを、もしセンシングでやるとしたらどうできるだろう、とイメージが膨らんで。たとえば電車の中でも左隣に座っているのは友人だけど、右隣の人は赤の他人。そういうのをどうセンシングしたら良いだろう、とか、思ったんです。そういう空間を距離で見るのではなくて。

暦本:

もう少し論理的な単位で見る。それはおもしろいですね。以前参加した学会で“ スポットミー” という携帯端末が渡されて、それは学会に参加した人同士が出会えるデバイスなんです。登録するとバッヂみたいなものを渡してくれて、そこにレジストレーションしているのは自分の名前や所属。その情報を電波で近傍に発射するんですね。で、ピッと開けると近くにいる人のリストが出てくる。

これ、会場内で使ってもおもしろかったんですが、終わってからバスを待っているときも出たりする(笑) 。あ、この人もこのバス乗るんだ!とか。そのへんが実空間的なインタラクションで。

ハレとケの可視化

前田:

ライフログもこれから開拓される分野でしょうが、その先に心のログもあるんじゃないかと思います。近くにいるけど、話しかけられたくないとか。センシングの先が、空間だけじゃなくてもうちょっと心理的なものも含まれてくるんじゃないかと。そこを可視化した事例はありますか?

暦本:

その人の普段の生活をどんどん蓄積して、ある特定の日と差分を取ると、その日がどれくらい普段かというのがわかりますね。自分のライフログの中で、この日は普通、この日は特別…というようなメリハリがわかる。

前田:

ハレ(非日常)とケ(日常)の可視化みたいな。

暦本:

そうです。仮に自分が毎日写真を撮っていたとしたら、ハレの日の写真だけをまとめてみようということができるわけです。それがなぜハレなのかは、写真自体をいくら分析してもわからない。これはその先の記録を拡張する、この人がハレの日は何があるのか、とかが分析できますよね。それも1つの可能性かなと。それがあると、さっき言ったコンテクストがリアルワールドを阻害しないようなインターフェースの1つの手がかりになっていくんじゃないかと思います。

実世界指向インターフェースとは

暦本:

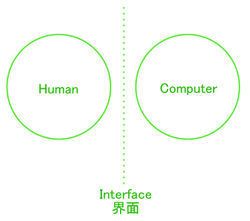

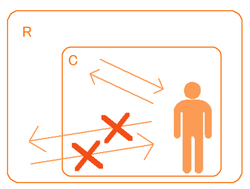

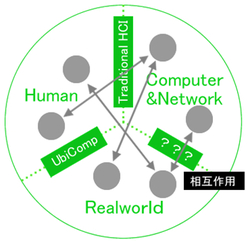

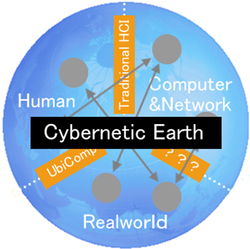

昔は、こっちに人間がいて、こっちにマシンがあって、その間のインターフェースというのが一番基本的だったんです(図1 ) 。VR(Virtual Reality)というのは、人間とコンピュータを取り囲んで、囲んだ中が仮想世界で、リアルは外。仮想世界とリアルとの間に壁ができちゃう(図2 ) 。そういう世界ですね。

図1 図2 しかし、今我々がやっていることというのは、コンピュータもあるしリアルもある。ユビキタスコンピューティングだったりとか、あるいは人間がコンピュータの力を借りながらリアルワールドとインタラクションするような世界になってきていると思うんです。これがまず1つの概念。

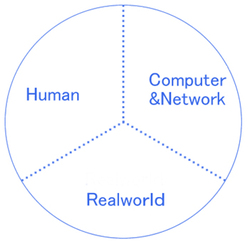

もう1つ、最近思っているのは、インターフェースというのは、結局ヒューマンとコンピュータとリアルワールドの3要素なんですよ。人間がいて、こっちがコンピュータのネットワークの世界で、そっちは現実の世界。こういう描き方でも少なくともインターフェースというのは3つぐらいある(図3 ) 。

なのでインターフェースというと、これ(図1)だけを考えて良い時代は過ぎて、この場合は少なくとも3つは考えなくちゃいけないし、これがユビキタスコンピューティングだったらエレメントがいっぱいあるし、こんなにキレイに面が分かれていないし……なので、こういう世界というのは、インターフェースとして切れているという発想は難しくて、この全体をシステムとして考える(図4 ) 。そこが、今と昔のインターフェースの違いです。

もしかしたらリアルとコンピュータというのは、環境をセンシングして、たとえばユビキタスコンピューティングなんだけれども地球環境をどう思うか、みたいなのを含めてインタラクションなのかなと思います。我々は全部こうなっているのをサイボーグ化した地球という意味で“ サイバネティックアース” と呼んでいます。

段々とインターネットのようなネットワーク世界が地球を覆ってきていますよね。でも、まだ情報的に覆っているだけで、リアルワールドとそんなに連携して覆っているわけではない。人間が手で書いた情報がまだメイン。

図3 図4 しかし、今世界中で注目されているのが、リアルワールドの情報――温度やCO2なんか――がセンシングでダイレクトにインターネットの世界に入ってくることで。これがもっと発達すると、リアルワールドのアクティビティとインターネットのアクティビティがどんどん絡み合ってきて、もう引き剥がせないような状態になる。それがサイバネティックアースだと思っていまして(図5 ) 。

そういう複合体みたいなものの上でコンピューティングってどうなのかな? というのは、コンピュータサイエンスとして結構大きなテーマなんじゃないかと思います。

図5 前田:

PS3の分散ネットワークが医療研究に使用されたり[5] もしていますよね。あれ、すごく僕は好きで。単に研究にCell/B.E.を提供するだけではなくて、もっと、こういう行為をしたらCO2がサーバに入るというのがネットワークで可視化されているような。

暦本:

ビルのエアコンディションがセンシングされていると、確実に今よりも電気消費量が減るという研究結果が出ているんです。つまり、一見高層ビル群なんだけど、ものすごくセンシングされている環境だと、実は昔よりも全然電気消費量が少ない。田舎で散らばって車で行き来するような生活よりも、高層ビルに住むほうがむしろ電気効率が良いかもしれない。そういう時代になるかもしれないし、あるいはまさにフォークソノミー的に、自宅の電力消費量をビジュアライズして「うちのほうが少ない」と喜ぶような。それが遊びになったりとかという可能性もありますよね。

そのへんが、実世界との融合と考えたときに、段々こういったサイバネテックアースのような新しい方向に進展してるんじゃないかと思うんです。

前田:

人と環境が肌感覚で、オーガニックにネットワーキングするのを想像するのは楽しいですね。本日はどうもありがとうございました。

[5] 人間のタンパク質の折りたたみ現象の解析アップデートを、PS3(標準的なPCプロセッサよりも10倍速での処理が可能なCell/B.E.を搭載)に適用することで効率化を図り、パーキンソン病/アルツハイマー病/ガンなどの原因究明を行う試み。

The Inspiration from this talk.

ときおり、映画をDVDで観ながらWikipediaや検索を楽しむことがある。史実に基づいた映画なら詳細な事実がわかればよりおもしろくなる。戦争映画なら戦勝国の側の歴史観から観るか、敗戦国の側から観るかでまったく違ってくるし、それぞれの観点から撮影した別の映画を観ても感慨深い。また、ちょっとした小道具やロケ地、撮影現場のこぼれ話や役者さんの苦労話を知ると映画の見え方も違ってくる。映画評論家や専門家、友人の評でも変わってくる。

このように1つのコンテンツを多くの視点(価値観)と付加情報で、かつみんなで楽しむための協調型拡張現実ツールがあっても良いのではないだろうか。