本連載ではこれまで、

リアルな世界の行動ログも活用しイノベーションを加速

- ──まず、

リクルートライフスタイルにおけるビッグデータ活用の目的を教えてください。 山崎氏:既存のサービスを改善するという方向性があるのはもちろんですが、

それ以上に新たなイノベーションを生み出すためにビッグデータを活用したいと考えています。そこで大きな意味を持つのが、 リクルートライフスタイルが持つデータの多様性です。リクルートライフスタイルにはWeb上のデータだけでなく、 リアルの世界のデータもあります。たとえば、 旅先でレンタカーを借りたり食事をしたりといった、 リアルな生活の中での行動ログも膨大にあり、 ビッグデータ分析に活用できる下地が整っています。そもそもリクルートライフスタイルはイノベーションしか求めていないので、 そこに対して多様なデータを組み合わせて分析できる私たちのビッグデータ分析基盤は大きな価値を提供できると思っています。 - ──ビッグデータという言葉が指す範囲は非常に広いと思います。リクルートライフスタイルでは、

ビッグデータをどのように定義しているのでしょうか。 山崎氏:ビッグデータには2種類あると考えています。まず膨大なデータをベースに、

そのサービスに何が求められているのか、 何をすべきかを分析するものです。ただ、 これはビッグデータという名前が付く前から進められている取り組みであり、 別段新しいものではありません。2つ目は多次元的なデータの分析によって価値を生み出すものであり、 これが本当のビッグデータであると考えています。単一のサービスで得られるデータだけでなく、 その他のサービスや外部から得られるデータ、 こういったものを掛け合わせ、 ユーザーを抽象化して価値を提供することを目指しています。

300名以上の企画担当者がSQLを駆使して分析基盤を活用

- ──ビッグデータをビジネスに活用するという視点は、

取り組みを始めた当初から社内で共有されていたのでしょうか。 平本氏:そうですね。Webサイトのアクセス解析ツールは以前から使っていて、

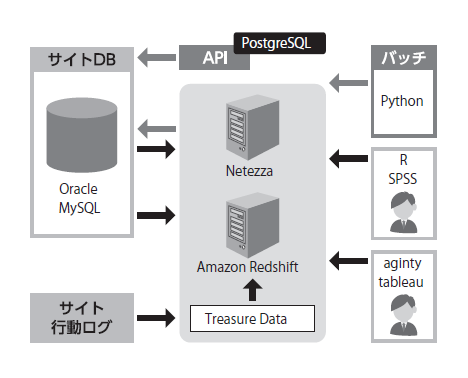

ディレクターがそれを使って傾向を分析するということは日常的に行われていました。ただ、 アクセス解析ツールは画面上で傾向が見えるだけなので、 最近はよりビジネス上のメリットに結び付けるために、 ビッグデータを使ってレコメンドのためのバッチを開発する取り組みが増えています (図1)。

- ──現在、

ビッグデータ分析基盤はどのように使われているのでしょうか。 平本氏:2~3年前に導入したNetezzaやAmazon Redshiftを300名程度のディレクターが利用し、

自分たちのプロダクトを分析しています。ビッグデータのユーザー会などで、 うちの会社は300人ぐらいが (ビッグデータ分析基盤に対して) SQLを投げているという話をすると、 すごく驚かれます (笑)。 山崎氏:何をやるにしてもROI

(投資対効果) を非常に重視する文化があるので、 データ分析がもともと根付いていたことも大きいと思います。何らかの施策を提案するとき、 起案者はROI算出の根拠となる数値を定量化・ 精緻化することに責任があります。従来は限られたデータの中でROIを算出したり、 外部からデータを買ってきたりする必要がありましたが、 社内のデータの量と種類が増えたことで精度の高い予測ができるようになった。そのような背景から広まっていったという流れです。 - ──ビッグデータ分析が社内に広まるきっかけとなる出来事はありましたか。

平本氏:Netezzaが導入されたとき、

ものすごく速いデータベースがあるという噂が広まり、 そこから口コミで使う人が増えたという感じです。何かブレークスルーがあってユーザーがドンと増えたというより、 じわじわユーザーが増えていった印象です。 山崎氏:1つターニングポイントになったと思うのは、

営業部門の人たちがBIを活用し始めたことです。おそらく最初は技術寄りの人間が紹介したのだと思いますが、 営業計画を立てるといったことに使ってみるとすごく便利で、 部門内に広がっていった。営業が活用し始めると、 企画側も使わないわけにはいかない。そういった出来事もフックの一つだったかもしれません。

ビッグデータ分析基盤を活用してもらうための工夫

- ──社内でビッグデータ分析基盤が活用されるように、

何か工夫されているものはありますか。 平本氏:リクルートライフスタイルでは数多くのWebサイトを運営しているので、

それぞれのWebサイトのどういった情報がデータベースに入っているのか、 そのテーブルのカラムが何を意味しているのかなど、 全Webサイトのテーブル定義情報を検索できるシステムを用意しています。 山崎氏:そもそも何ができるのか、

ほかの人はどのように分析しているのかなどについて、 まず可視化するところから始めました。実際に分析基盤を使って何ができるのかというのは、 具体性がないとわかりづらいことが多いので、 そのための情報やしくみを私たちのグループでサポートし、 データを活用してもらえるような環境を整えています。 - ──データを分析するための基盤を提供したことで、

社内で想定していなかったような変化はありましたか。 平本氏:当初はデータサイエンティストと呼ばれる人間がレコメンドなどを考えていたのですが、

それ以外の人たちが 「こういう風にレコメンドすればいいのではないか」 などと考え、 その実現方法を考えるようになってきました。また、 サービスのメルマガに活用しようという広がりもあります。 山崎氏:データ分析に興味がある人が一定数いて、

そういう人たちは勝手に使い始めるんですよね。サービスの会員をセグメント化して、 どのセグメントにどうアプローチすると、 どのような結果が出るのかといったことをすごく考えている人たちがいるんです。そういった人たちを中心にビッグデータの活用は根付きつつあります。

そのときどきの最新技術を活用してビッグデータインフラを構築

- ──現状、

ビッグデータ分析基盤はどのような構成になっているのでしょうか。 平本氏:まずデータソースから言うと、

Webサイトの情報とアクセス解析結果の2種類があります。前者は商材や顧客の情報、 後者はAdobe Analyticsのデータで、 これらを日次で取得しています。これらの情報をNetezzaとAmazon Redshiftに投入して分析します。最初に導入したのはNetezzaでしたが、 リソースが足りないという状況が発生し、 一方でオンプレミスのため簡単にスケールアウトできなかったことから、 Amazon Redshiftも利用することになりました。現状でほとんどのバッチはAmazon Redshiftで処理しています。またビッグデータ分析で中心となるデータのロードと加工、 エクスポートについて、 設定ファイルを書くだけで実行できるフレームワークを独自に開発しています (図2)。同様の位置付けの製品として、 Treasure DataのEmbulkがありますが、 このシステムを開発しているタイミングではまだ発売されていなかったため、 独自に開発したということです。

- ──今後どのように改修していきたいと考えていますか。

平本氏:現状のインフラはパーツの数が多く運用も大変になっているので、

ちょうど次世代のビッグデータインフラを考えているところになります。現状のインフラは2011年ごろから構築し始めていますが、 そのときどきの優れたものを段階的に採り入れてきたので要素が増えてしまったという経緯があります。これを整理して、 シンプルなインフラにしていく予定です。

注目しているのはKafkaとSpark

- ──将来のビッグデータインフラの構築のために、

注目しているテクノロジはありますか。 平本氏:Apache KafkaとApache Sparkです。特にSparkは、

バッチとリアルタイムのそれぞれの機能が用意されていること、 それと豊富なインタフェースを用意している点が魅力です。現状のインフラではSQLしか提供できていないという課題がありますが、 エンジニアがもっと簡単に使えるようにしたいと考えたとき、 よりフレンドリなインタフェースが提供できるのもSparkの利点です。 車田氏:Sparkの検証フェーズが終わり、

近々リアルタイム処理のサービスをリリースします。今後は、 Sparkのパフォーマンスを最大限に引き出すことを目指しています。 平本氏:次世代のインフラはこのKafkaとSparkを軸に考えていますが、

Amazon Web Servicesから新サービスがポンポンと出てくるので、 そっちのほうが楽だと感じればそちらに置き換えることもあるかもしれません。あまり固定的に考えるのではなく、 そのときどきで旬なものを積極的に取り込んでいきたいと考えています。 - ──オンプレミスとクラウドの選択はどのように考えていますか。

平本氏:リクルートライフスタイルで利用しているシステムは、

現状では基本的にオンプレミスですが、 ビッグデータのインフラについてはNetezza以外は全部AWS上で動作していて、 スケールアウトのしやすさなどといったメリットを考えるとクラウド一択かなと感じています。たとえばユーザーが投入するクエリのボリュームで性能が低下しているといった場合でも、 Amazon Redshiftであれば簡単にスケールアウトできるのは、 やはりメリットを感じる部分です。

その構築に携わるエンジニアが一番ビッグデータを活用できる

- ──将来的に、

ビッグデータを取り巻く状況はどのように変わってくると考えていますか。 山崎氏:2~3年先には、

おそらくビッグデータ分析のための使い勝手の良いパッケージができると考えています。それによって多くの人たちがビッグデータ分析に取り組み始めたとき、 そこに乗り遅れないために何をすべきかを考えているところです。その意味で、 この2~3年をどう過ごすのか、 そして将来の状況を見越して今何をやっておくべきかはとても重要ではないでしょうか。 平本氏:機械学習にも注目しているのですが、

出力すべきものが決まっている教師あり学習ではなく、 教師なし学習がもしかすると流行るかもしれませんね。現状は教師あり学習がメインで、 人間側で仮説を作ってコンピュータに機械学習させる形が主流ですが、 よりデータが増えて処理能力が高まれば、 仮説を考えなくてもビッグデータのインフラが勝手に有用なラベリングをしてくれる可能性が高まります。ただ、 そこに到るにはまだまだデータが足りない。現状、 どのログを蓄積するかは人間の主観で決めてしまっているため、 取れていないログがたくさんあると思うんです。 車田氏:私もやはり取得できていないデータはまだまだあると感じています。それに対して、

ハードウェアの進化、 テクノロジの進化の恩恵を活かしつつ、 ありとあらゆるものをカバーできるインフラを整えていく。特にリクルートライフスタイルにはデータの多様性があるので、 それを積極的にビジネスに活かせるインフラを作っていきたいですね。 山崎氏:僕が思っているのは、

ビッグデータインフラのエンジニアこそがビッグデータを一番使いこなせる可能性のある人だということです。さまざまな種類のデータがビッグデータのインフラに集まっていますが、 それに触れているエンジニアはデータの構成やその意味を一番理解しています。その強みを活かし、 ビッグデータインフラのエンジニアが新しい企画やサービスを提案する世界が来たらいいなと。そこが登りたい山ですね。 - ──本日はありがとうございました。