2014年1月17日、新宿にあるベルサール新宿グランドにて 「エンジニアサポートCROSS 2014」が開催されました。

本稿では、C会場で開催されたセッション「クラウドの組み立て方事始め H/W利用者としての事業者」についてレポートします。

登壇者は、セッションオーナーの山口亮介さん(ニフティ株式会社)、スピーカーの松本直人さん(さくらインターネット株式会社)、田口栄治さん(インテル株式会社)の3名です。

山口さん、松本さんがクラウド事業者視点で、クラウド基盤構築についての課題、H/Wベンダーへの要望を主に説明しました。その課題、要望に田口さんがH/Wベンダーとしての解を説明するという流れで、セッションは進みました。

クラウド基盤構築課題とその対応策についての検証状況

松本さんは、クラウド基盤構築の課題とその対応策について話しました。

ラックの高密度化

クラウド基盤を構築する際にかならずぶち当たる壁が、どこまで機器を集約するかというファシリティ設計です。42Uのラックに42台のサーバを搭載できればいいのですが、ネットワーク、サーバ、ストレージ、熱量、耐荷重などを考慮すると、42台搭載は現実的ではありません。したがって、ネットワーク、サーバ、ストレージ等のバランスをどうするかがラックの高密度化のキーとなると示しました。

ここで田口さんが42ラックへのフル実装構成について、社内の事例を紹介しました。インテルでは10万台のサーバを運用しているため、スペース効率を考えて1ラックにICT機器をフルに実装して運用しているそうです。最大、1ラック30kVAの電源密度で運用しています。今後の高密度実装で集約可能なネットワーク、ストレージ機能の開発も実施していることを挙げていました(のちほど詳しく説明します)。

ネットワーク

10GbEを検証したところ、ワイヤースピードが出ることは確認できました。ただし、ショートパケットの対応が課題です。ショートパケットの場合、ソフトウェア処理がネックになるためです。その解決策が、ネットワーク処理のオフロード対応したNICの採用です。オフロードNICを使うことでショートパケットでも、ワイヤースピードに近い性能が出るという検証結果が確認できたとのことです。

ただし、課題もあります。大量調達が難しいことです。もともと金融業界向けに開発されたため、そこまで流通しておらず、クラウド事業者が使うには時期尚早です。

PCI Express Gen3の最新規格でのネットワーク帯域の物理限界は128Gbps。どんな用途にここまでの帯域が必要か検討もつきませんが、この帯域をどう使うかを考えるのが、クラウド事業者の差別化につながるかもしれないと話していました。

ストレージ

容量とIOPSの最適化のために、よく使うデータはSSDに、あまり使わないデータはHDDに自動的に配置させる仕組みがあります。すでに商用プロダクトもリリースされています。価格と性能のバランスが肝となるため、クラウド事業者は上記のような仕組みを利用し、可能な限りコストパフォーマンスが高いストレージシステムを構築するのがよいと言及していました。

CPU開発ロードマップ

田口さんは、インテルでの開発モデルであるTick-Tock Development modelについて説明しました。

Tick-Tock Development modelでは、概ね1年ごとに、製造工程の改良(1プロセッサあたりのコア数増加)とマイクロアーキテクチャの改良(省電力、コア性能向上)を交互に行います。

Xeonプロセッサは、2000年から2012年の間に性能が100倍程度向上しました。特にNehalemのリリースで、省電力性能、周波数が大幅に向上し、ユーザの方に受け入れられました。

CPU性能は、毎年40%程度向上しています。それにあわせてリプレースすることでサーバの集約化、設置スペースの削減が可能となり、コスト削減を実現することができます。現状、一般企業で5~6年、クラウド事業者で3~4年、Amazon, Google等の超大規模事業者だと3年を切るくらいのペースでリプレースが実施されています。

現状のCPUのメニーコア化、コア性能向上に伴い、サーバは高密度化されています。CPU開発のスピードに、他の周辺機器開発が間に合っていない状況です。特に、入出力周りが高密度化に伴い影響が大きいため、Fabric開発に着手しました。具体的な製品としては、Fabricスイッチ、ファイバーケーブル、SFPコネクタのリリースを予定しています。Fabric開発着手の目的は、あくまでも性能向上と低価格化によるサーバ高密度化の促進です。

ラックの高密度化については、FacebookなどのOpen Compute Projectと共同検証を実施しており、その中で、ラックの新しいアーキテクチャ開発等を進めています。その成果をケースモデルとして、Rackspaceで実際にそのアーキテクチャがクラウドサービスに採用されています。

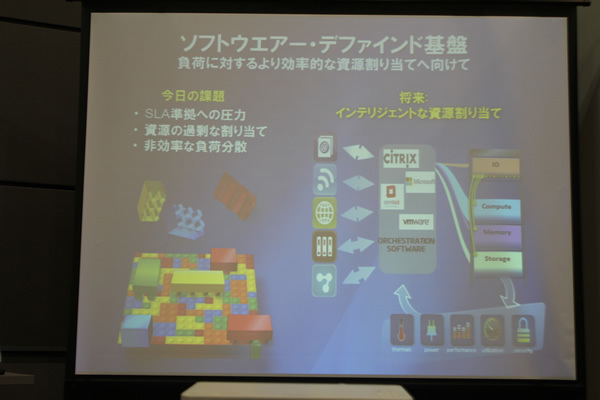

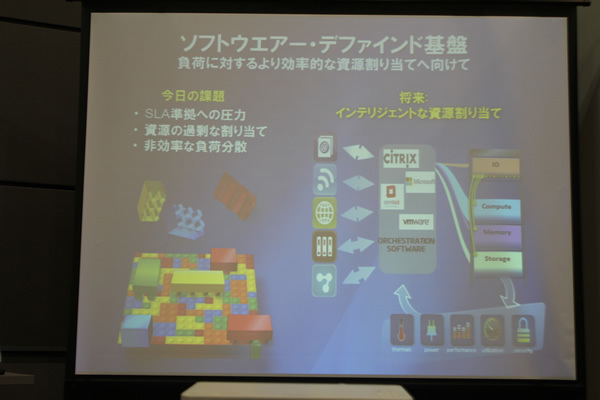

さらなる高密度化については、ソフトウェアデファインドなアーキテクチャが肝と考えており、設計・検証を実施しているそうです。

山口さんが「インテルが、クラウドOSを開発するということはありますか?」と質問したところ、田口さんは「あくまでもクラウドOSへの支援機能開発です。クラウドOSの開発には手を出すようなことはない」と述べていました。

ニフティクラウドの構成

山口さんは、ニフティクラウドを取り上げました。

サーバ機能検証段階で、CPUのコンテクストスイッチがボトルネックになり、想定性能が出ないことがあったと言います。その際、VMware社に協力いただいて、当時まだ出たばかりだった仮想化支援機構が十分に機能することを確認し、解決することができました。そのような経緯もあり、ハイパーバイザーにはVMwareを採用しています。また、サービスリリース当初は、納期や価格の面など色々な課題があり、一部機材を秋葉原で購入したこともあるとのこと。現在では、サービスリリース当時の構成と比較すると、CPUで3倍以上、メモリ10倍、ネットワーク10倍の構成になっており、メーカー製のサーバを利用しています。

山口さんが田口さんに、「今後インテルとしては、メニーコアという流れになるか?」と質問しました。田口さんは、「無計画にコア数だけを増やすということはしません。コア単体の性能向上にも注力する。ただし、ソフトウェアがメニーコアを必要とされるのであれば、その方向にもシフトしていくことはあります。また、すでにXeon Phiという60コア程度のコプロセッサもあります。高度科学技術計算用途以外では、こういった多くのコアを使い切るソフトウェアを開発するのは難しいと認識しています。メニーコアより現状程度のコア数程度のサーバを並列に並べていくというのがクラウド基盤として現実的だと思います」と述べていました。

Q&A

会場からの質疑応答がありました。

質問

松本さんの検証結果として、10/40GbE NICの性能も仕様どおりの性能は出るとありました。しかし、実際にはソフトウェアがボトルネックになり、その機能を十分に生かし切れない状況があると説明していました。そのような状況に対して、クラウド事業者として、どのような対策をしているのか教えてください。

回答

松本さんと山口さんの回答は次のように答えていました。

「cgroupsを使ってQoS制限をかけることで、リソースの品質担保を実施している。特に、ストレージのIOPSを重要視しているので、ここの設計について力をいれている。ただ、制限値については、どのクラウド事業者も同じと思うが企業秘密です」(松本さん)

「VMwareの機能を利用して、品質担保を実施している。ただ、どうしてもさサーバの性能限界に達するとベストエフォートになってしまう。その公平性担保という意味では、VMwareのDRS機能を使い、適宜リバランスするにしている」(山口さん)

まとめ

かつては、サーバが高額であり、簡単な移行もできなかったため、アアプリケーションのチューニングにお金をかけて、少ないリソースでいかに性能を出すかというアプローチしかできませんでした。

しかし、クラウド環境が整ってきている現在、システムの性能、安定性向上については比較的容易に、そして安価に実現できる環境になっています。クラウド事業者は日夜コスト削減(ラック高密度化など)を追求しており、クラウドサービスにしめるサーバの価格は、原価の50%を切るほどにまで低価格化していると言われます。今後アプリケーション開発において、さらなるコスト削減と品質の向上を求める場合は、クラウド効率利用がキーポイントになってくると思います。