The iPhone moment of AI ―5月29日、台湾で開催された「COMPUTEX TAIPEI 2023」のオープニングキーノートに登壇したNVIDIAのジェンスン・フアン(Jensen Huang)CEOは、ジェネレーティブAIが世界に及ぼしている影響力をこう表現しました。2007年6月に最初のiPhoneが登場してからモバイルの世界が激変したように、「 我々は現在、ジェネレーティブAIがAI、そしてITの世界を大きく塗り替えようとしている瞬間に立ち会っている」というフアンCEOの言葉通りなら、AIの技術革新を牽引してきたNVIDIAは新しい時代に向けてどんなソリューションを用意しているのでしょうか。本稿では、フアンCEOがCOMPUTEXで発表したニュースの中から、データセンターソリューションに関連した内容にフォーカスし、その概要を紹介します。

図 NVIDIA ジェンスン・フアンCEO

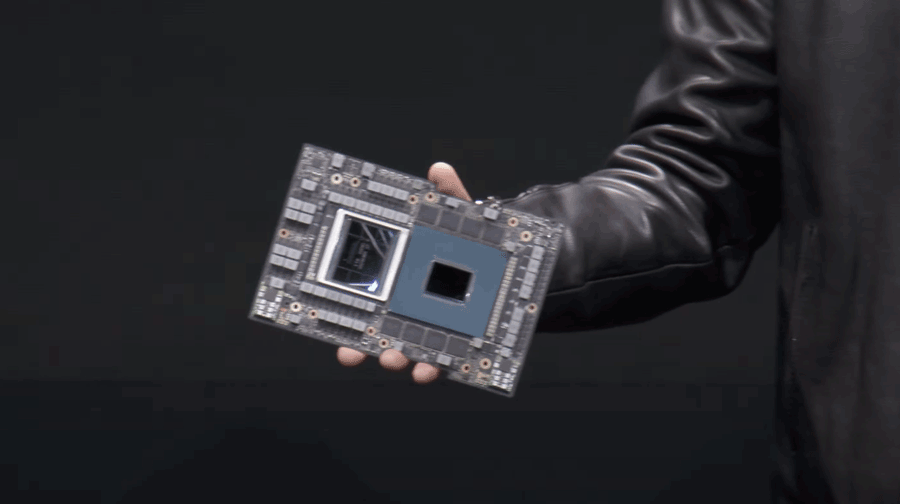

CPU+GPUを1モジュールで ―“Grace Hopper”の量産開始

2022年3月にNVIDIAが発表したデータセンター向けのCPU「NVIDIA Grace」と、AIの高速化に特化したトランスフォーマーエンジン搭載のGPUアーキテクチャ「NVIDIA Hopper」 、この両方を1つのモジュールに統合した開発コード「Grace Hopper」あらため「NVIDIA GH200 Grace Hopper Superchip」の量産化が発表されました。大規模なAIおよびハイパフォーマンスコンピューティング(HPC)ワークロードに特化して設計されており、Grace(CPU)とHopper(GPU)の統合はNVIDIAが開発する超高速チップ間インターコネクトテクノロジ「NVIDIA NVLink」が接続しています。これにより双方向で最大900GB/秒、標準のアクセラレーテッドシステム(PCIe 5.0)の約7倍という圧倒的な帯域幅を実現しており、ニーズが高まるジェネレーティブAIやHPCアプリケーションに対して「AIのスケールアウトを可能にしたインフラ」( フアンCEO)を提供するとしています。

図 1つのモジュールにGrace CPUとHopper H100 GPUを搭載した”Grace Hopper”ことNVIDIA GH200 Grace Hopper Superchip

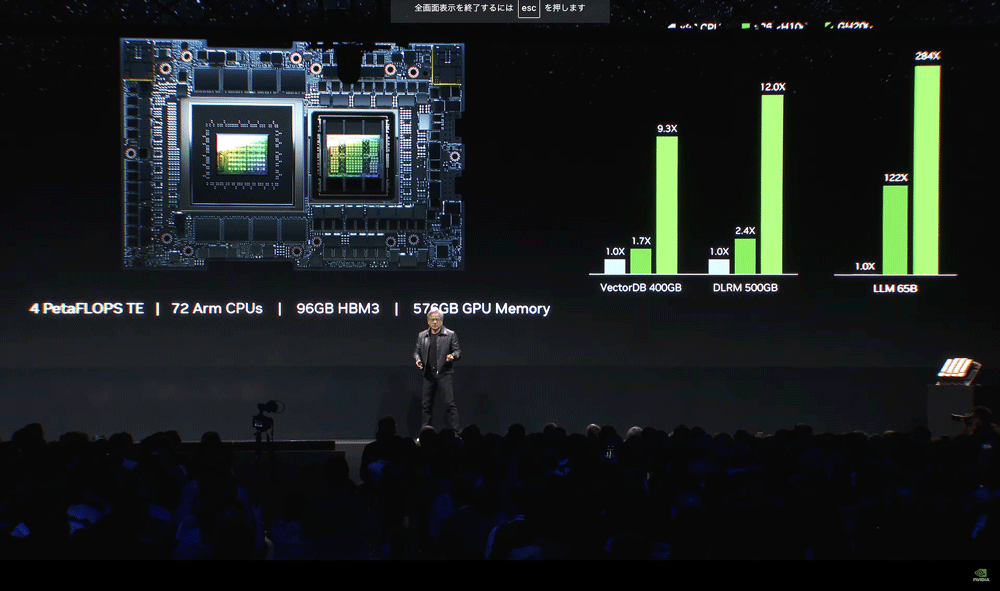

図 フアンCEOが紹介したGH200のスペック。72コアのArm CPU(Neoverse V2)、最大576GBのGPUメモリ、最大96GバイトのHBM3メモリを搭載し、Hopper H100に実装されたトランスフォーマーエンジン(TE)により、4ペタフロップスというパフォーマンスを実現している。VectorDB、DLRM(Deep Learning Recommendation Model)、LLM(Large Language Model)といったAIワークロードの実行においても、x86系CPUや前世代のH100+x86を大きくしのぐ

Grace HopperあるいはGrace CPUは、これまで米ロスアラモス国立研究所(Grace Hopper)や英ブリストル大学(Grace)といった世界最先端の研究所のスーパーコンピュータにいくつか導入されてきましたが、GH 200として量産が開始されたことにより、2023年後半からは米国と欧州を中心としたハイパースケーラーや研究所での導入が開始される予定です。

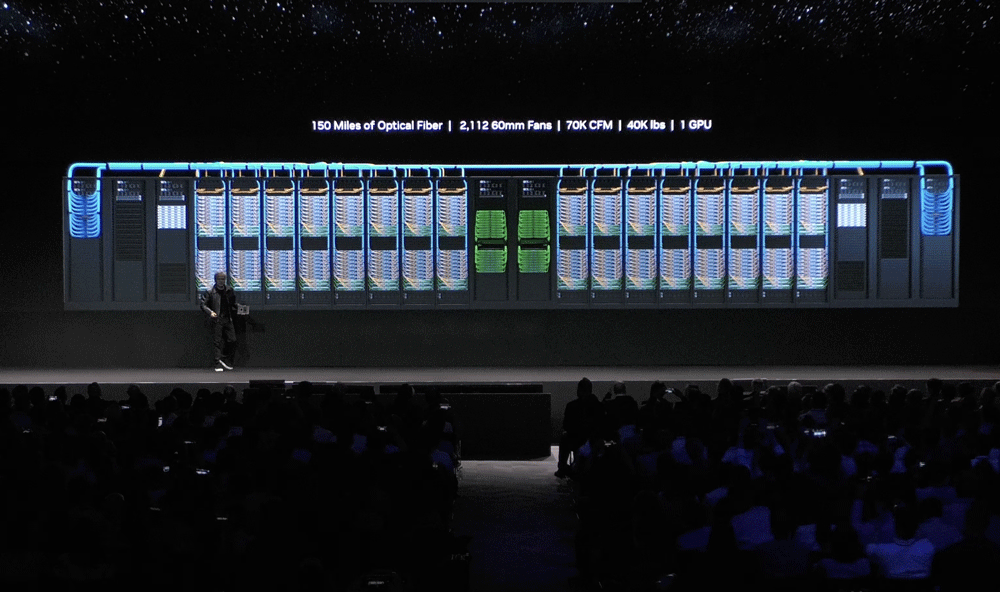

256基のGPUを1GPUとして扱える「NVIDIA DGX GH200」

このGH200を256基接続し、256基のGPUを1つの巨大なGPUとして扱うことを可能にしたAIスーパーコンピュータ「NVIDIA DGX GH200」も同時に発表されました。256基のGPUは、前述のNVLinkを複数接続するインターコネクト技術「NVIDIA NVLink Switch System」によって1つの統合されたGPUとして機能します。

図 256基のGH200を統合し、1GPUのスーパーコンピュータとして構成されたNVIDIA DGX GH200は、世界最高峰のスパコンと同等の1エクサフロップスを実現。すでにGoogle Cloud、Microsoft、Metaが導入を発表している

NVIDIAはエンタープライズAIに特化したポートフォリオとして「NVIDIA DGX」シリーズを展開していますが、今回発表されたDGX GH200は、2020年発売の「NVIDIA DGX A100」の後継世代にあたります。DGX A100の500倍となる144TバイトのGPUメモリ、NVLink + NVLink Switchにより実現した230Tバイト/秒という超巨大な帯域幅(DGX A100の48倍)に加え、1EFLOPSという世界最高レベルのスパコンと同等のパフォーマンスを発揮する、まさに次世代のAIスパコンが登場したといえます。提供開始時期は2023年末までとのことですが、すでにGoogle Cloud、Meta、MicrosoftといったジェネレーティブAIの研究開発に力を入れるハイパースケーラーがDGX GH200の導入を決定している点も注目されます。

ソフトバンクがGH200を導入する最初の通信事業者に

ComputexのキーノートでフアンCEOが発表したニュースの中には、ソフトバンクによるGH200採用のアナウンスも含まれていました。前述したようにGH200はまだ量産が開始したばかりであり、ユーザ企業が導入を検討するのはこれからとなりますが、通信事業者としてソフトバンクが最初の導入企業に名乗り出たことは日本のエンタープライズユーザにとっても非常に興味深いニュースです。

図 フアンCEOがソフトバンクとのGH200導入をキーノートでアナウンス。GH200をベースに、5GとジェネレーティブAIに対応したデータセンターを”reinvent”するとのこと。ロールアウトは2023年末が予定されている

この発表に関しては5月30日、NVIDIAのテレコム事業担当シニアバイスプレジデント ロニー・バシシュタ(Ronine Vasishta)氏が報道関係者向けに説明を行いました。同氏によれば、通信事業者やデータセンター事業者は現在、5GとAIという2つの大きなトレンドによる劇的な変化のさなかにあり、いまやデータセンターにはベストインクラスの5G品質と「AIファクトリ」としての機能が求められるようになっています。

また、オープンでフレキシブルなvRAN技術で構成されていること、TCO削減を考慮し、マルチテナントであること、エネルギー効率やサステナビリティに配慮していることもあわせて求められます。加えてソフトバンクのような通信事業者には5Gだけでなく、次世代の6Gへの準備も必要であり、これらを勘案した結果、GH200をベースにしたプラットフォームの導入を決定したとされています。

「ソフトバンクという日本のビジョナリーカンパニーが次世代のプラットフォームの基盤としてGH200を選択したことは非常に光栄。ジェンスン(フアンCEO)がキーノートで言及したように、GH200はAIをスケールすることができるアーキテクチャ。AIと5Gによりデータセンターの再発明(reinvent)とトランスフォーム(transform)が求められている現在、GH200がそのニーズに応える力となる」( バシシュタ氏)

なお、ソフトバンクによるGH200ベースのシステムの稼働は2023年末が予定されています。

いまやAIの世界を豊富なポートフォリオと強いリーダーシップで牽引する存在となったNVIDIAですが、COMPUTEXでの発表内容を見る限り、ジェネレーティブAIが隆盛となった現在もその優位性は揺らいでいないようです。そしてその優位性はコンシューマだけでなく、エンタープライズにおいても同様です。

コンシューマでの隆盛に比べ、エンタープライズITの世界ではまだジェネレーティブAIに対し、セキュリティやガバナンス、カスタマイズの自由度、ドメイン知識の精度などの観点から導入を躊躇している企業は少なくありません。しかし、バシシュタ氏のコメントにもあるように、Google Cloudやソフトバンクといったハイパースケーラーや通信事業者はジェネレーティブAIの急速な普及により、データセンターそのものあり方を早急に再構成する必要に迫られています。このニーズに対し、前世代をはるかにしのぐスペックと” 巨大な1GPU” というアーキテクチャで応え、リリースと同時にハイパースケーラーの導入発表を引き出したことは、エンタープライズAIにおけるNIVIDIAのエコシステム拡大という点でも非常に効果的だといえます。

NVIDIAは現在、通信事業者のほかにもヘルスケアや金融、小売などドメインに特化したAI戦略を展開していますが、今後、それぞれのドメインに対してどんなソリューションでもってジェネレーティブAIをサポートしていくのか、引き続きその動向に注目する必要がありそうです。

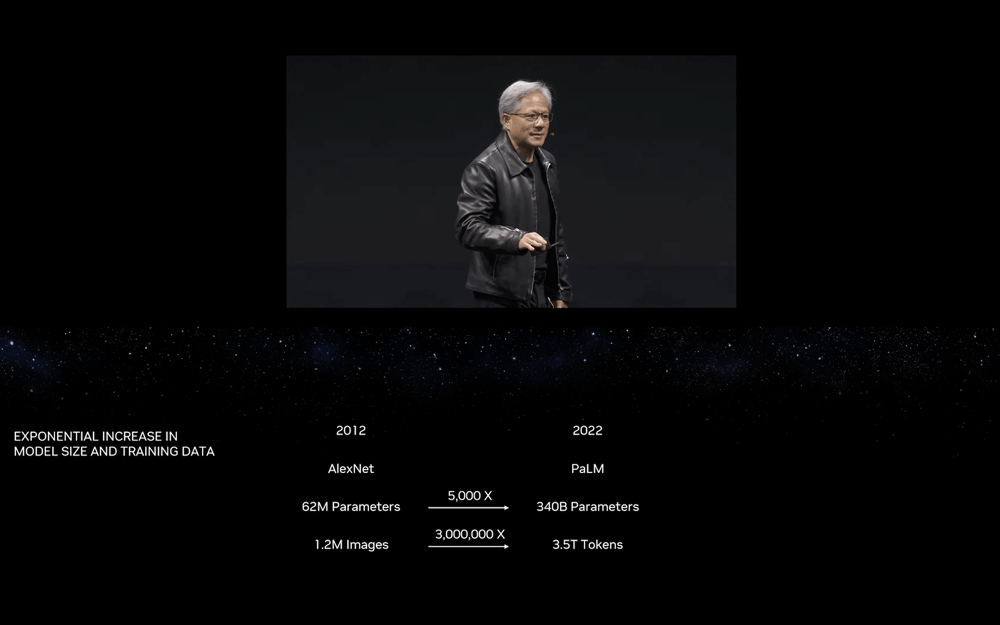

図 ジェネレーティブAIはハイパースケーラーやデータセンターに求められるリソースを大きく変えつつある。たとえば2012年に設計された畳み込みニューラルネットワーク(CNN)のモデルである「AlexNet」と、Googleが2022年に発表した大規模言語モデル「PaLM」とでは、モデルサイズも学習データの量も大きな差がある。データセンター事業者や通信事業者、クラウドベンダは早急にジェネレーティブAIのニーズを満たす必要がある