あけましておめでとうございます。よういちろうです。今年もよろしくお願いいたします。

昨年は、皆さんが体験したとおり大変な年になってしまいました。移動が制限され、人と会うことも難しく、生活に大きな影響が出てました。それは日本だけでなく地球規模で起きたことであり、多くのことが「止まってしまった」一年だったと思います。特に、当たり前だったことがそうではなくなってしまい、前提条件が崩れてしまった結果、人々のコンピュータやインターネットへの接し方も大きく変わった印象があります。

しかし、進化の歩みが完全に止まってしまったわけではありません。昨年、主要なAIアシスタントについては、当初よりもゆっくりになってしまったとは思いますが、着実に新規機能の提供や改善が行われてきました。そして、大きな方針転換も垣間見えてきていました。

本記事では、AIアシスタントが今年どのように進んでいくのか、筆者の考えを紹介したいと思います。取り上げるAIアシスタントは、日本においてプラットフォーム化をすでに遂げているGoogleアシスタントやAmazon Alexa、Apple Siriを対象とします。

AIアシスタント対応ウェアラブルデバイスの普及がさらに拡大する

新型コロナウイルスの流行が止まらず、人々は他人との接触を避けるべく、行動を制限している国が多い状況です。そのため、多くの人々が自宅で過ごし、外出は必要最低限となっています。ロックダウンという強い行動制限をかけている国もあれば、日本のように個々人の行動にある程度任されている国もあります。制限の度合いは各国の政策に依存しますが、積極的な外出を避けている点では共通しています。

MMD研究所による7月に行われたスマートフォンの利用時間に関する調査では、4月から5月にかけて行われた緊急事態宣言の前後で、スマートフォンの利用時間の変化があったことが示されています。結果としては、緊急事態宣言後に、スマートフォンの利用時間が増加しています。

新型コロナの影響でスマホの利用時間はどれだけ増えた? MMDが調査 - ITmedia Mobile

筆者が想像するに、行動が制限された結果、今まで行ってきた様々なことが行えなくなったために、他のことをしていた時間が「暇な時間」に変化したことが要因かな、と考えます。逆のことを言うならば、スマートフォンの利用時間が増えたことは、それだけ家にいる時間が増えたことの証明かもしれません。

スマートフォンはインターネット利用の中心的デバイスであり、外出先ではなく家で利用する時間のほうがもはや多い印象がありますが、「 外出時に身につけて利用するデバイス」 、つまり「ウェアラブルデバイス」も近年注目を浴びてきました。しかし、そもそも外出機会が減ってしまったためにウェアラブルデバイスを利用する理由がなくなってしまい、普及が滞ってしまったのではないか、と想像する方が多いかもしれません。2020年はウェアラブルデバイスは冬の時代を迎えてしまったと筆者も考えていました。

昨年の記事 にて、筆者は昨年ウェアラブルデバイス(特にスマートイヤホン)にAIアシスタントが搭載されて利用が進むと予想しました。よって、新型コロナウイルスの流行が拡大するに連れて「あ、予想を外してしまったかな」と思っていましたが、実際には期待通りの結果となったようです。

IDCが今年9月に発表した調査報告 によると、2019年と2020年との比較にて、ウェアラブルデバイスの出荷台数は14.5%の増加で着地すると報告されています。

“Global shipments of wearable devices are expected to total 396.0 million units in 2020 according to new data from the International Data Corporation (IDC) Worldwide Quarterly Wearable Device Tracker. This marks a 14.5% increase from the 345.9 million units shipped in 2019.”

新型コロナウイルスの影響によって各メーカーが出荷台数を一時的に制限するに至りましたが、需要自体は縮小することがなく、結果として昨年末までに4億台近くまで到達するのではないか、と予想されています。

“The first half of 2020 delivered positive results despite the impact of COVID-19 on the global economy. Even though vendors scaled down production and end users were quarantined, demand for wearables remained steady. The market was propelled by near-record demand for hearables, which was enough to offset slightly lower demand for watches and wristbands. The second half of 2020 is on pace to continue this trend and with the launch of new products – including hearables, watches, and wristbands – from multiple vendors, the wearables market is on track to reach nearly 400 million units this year.”

需要が落ち込まず、むしろ成長するに至った理由としては、新型コロナウイルスの流行拡大に関連して、人々の健康志向が今まで以上に加速したのではないかと説明されています。

特にスマートイヤホンといった「Hearable」デバイスに対しては、AIアシスタントが搭載されているモデルが多くなってきました。日本でも、GoogleからPixel Buds というGoogleアシスタント対応のスマートイヤホンが発売されていますし、ソニーなどの各種メーカーが発売しているハイエンドのスマートイヤホンでは、AIアシスタント対応を遂げているモデルが当たり前になってきました。

昨年のウェアラブルデバイスの普及スピードは、今年も維持されると予想されます。これは、多くの人々がAIアシスタントを利用する頻度が今後もより加速していくことを意味しています。残念ながら人々の活動の制限はまだしばらく続きそうです。しかし、その状況下においても、AIアシスタントをいつでも利用することができる環境が整いつつあります。

例えば、今年後半から年末にかけて人々の行動が徐々に元に戻っていくとするならば、ウェアラブルデバイスとAIアシスタントとの組み合わせを活かした数多くのサービスが一気に登場し、スマートフォンだけではないサービスの提供形態の模索が進んでいくと期待できます。特に、しばらくは非接触というキーワードが重要になりますので、その点においてもAIアシスタントの活用が多く模索されると予想できます。

スマートフォンによるAIアシスタントの再出発

冒頭で「様々なことが止まってしまった昨年」と紹介しました。大きな新商品発表イベントを各社が控えていたために、昨年があまり大きな動きがなかった印象を持っている方が多いと思います。しかし、AIアシスタントに関しては、着実に改善が進んでいますし、新規機能のリリースも多くありました。その内容を注意深く振り返ってみると、AIアシスタントは「大きな分岐点」に差し掛かっていることがわかります。

その要因として取り上げるべきものとしては、以下の2つがあります。

AmazonもGoogleも、最初こそスピーカーとマイクのみを搭載した「音声のみを扱うデバイス」を発売し、声のみでサービスを利用する「Voice User Interface(VUI) 」を押し出してきました。しかし、VUIのみで利用可能なサービスは、日常生活の中でちょっとしたことを行う場面ではとても役に立つ反面、キラーアプリはいまだに登場していません。特にマネタイズに成功している事例は皆無です。

その後、AmazonからEcho Showが、GoogleからNest Hubがそれぞれ発売されます。これらは、液晶画面を持ち、声で操作するだけでなく、画面にタッチして操作し、そして画面上に様々な情報が表示される、つまり「視覚」も利用するデバイスとして登場しました。これらのスマートディスプレイから提供される情報量は、当然スマートスピーカーよりも多くなります。また、音声認識の結果が画面に表示されることでユーザーが安心してVUI操作ができるようになる効果もあります。

スキルやアクションの開発者は、以下のテクニックを使って、画面にコンテンツを表示してVUIを補う視覚的機能を開発できます。

スマートディスプレイが従来のタブレットのようにならずに「VUIデバイスであること」を維持するため、各社それぞれスマートディスプレイ対応のスキルやアクションの開発に対して制限をかけています。例えばGoogleではゲームや教育向けのアクションのみ審査を通過できます。

スマートディスプレイに加えて、Googleから2018年にApp Actions という新しい機能の提供がアナウンスされていました。App Actionsは、Googleアシスタントに話しかけることで、Androidアプリが提供する各種機能を直接呼び出すことができる画期的な機能です。

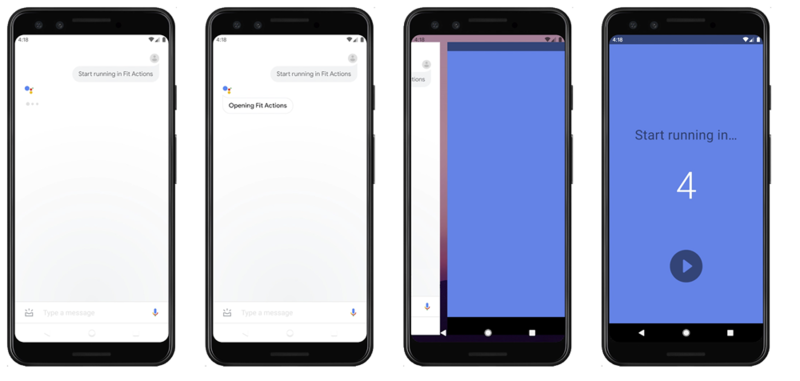

App Actionsの例。Fit Actionsアプリに「走り始めるよ」とGoogleアシスタント上で話しかけることで、Fit Actionsアプリの機能がDeep Linkにより直接実行される。

App Actionsの登場から昨年の中盤にかけて、特定のAndroidアプリ開発ベンダーによってApp Actionsの組み込みが行われ、様々な検証が行われてきました。そして、10月9日に行われたAssistant Developer Day イベントにて、すべてのAndroidアプリに対してApp Actionsの利用が許可されたことがアナウンスされました。

App Actionsの登場により、「 スマートフォンを声で利用する」という新しい使い方が提唱されたことになります。そして、昨年はその環境が整った年になったということができるでしょう。

人類には早かった「音声のみのデバイス」

スマートディスプレイやスマートフォンへのAIアシスタントの対応は、やはり「視覚的な情報は重要であり有用である」ことをAIアシスタント提供ベンダーが認めたことになると筆者は考えています。

つまり、先行して発売され現在に至るまで普及してきた「スマートスピーカー」という音声のみを扱うデバイスでは、イノベーションを起こし多くのユーザーの行動を変えられるだけの能力を持ったサービスが生み出されなかったということです。そして、音声のみでのサービス展開に固執するのではなく、ユーザーは徐々にVUIに慣れていくといった段階が必要だったことを意味しているのではないかと考えています。

GUIと違い、VUIには「操作対象が目に見えない」という決定的な違いがあります。見えないものをどう使うか、ユーザーは想像できません。また、情報は「ひと目で見てわかる」ものであれば、長々と説明されずに「見せてもらえれば良い」わけです。特に今までが「GUIが当たり前」でしたので、いきなり画面を失ってしまっては、多くのユーザーが困惑してしまうのも当然であることがやっと理解できた、というのが昨年のタイミングだったのかなと思っています。

スマートフォンを通じてVUIを学習する

今年は、多くのAndroidアプリ開発者がVUIに向き合う年になると考えられます。つまり、Androidアプリ開発者は、今までインテントや自らが開発したGUI上でしか呼び出されなかった機能を「声でも呼び出せるようにしていく」ことが求められます。

多くのAndroidアプリがApp Actions対応を遂げていくに連れて、Androidデバイスを使う際の「操作方法」が、指ではなく声でも可能になっていきます。先ほどの「見えないものは操作できない」というVUIの欠点は、App Actionsにおいては「GUIにて利用経験のある機能を声で呼び出す」ことになるため、障壁にはなりません。「 ○○と話しかければ、あの機能が呼び出される」とユーザーは明確に何が起きるか把握できるため、安心して声で話しかけ始めると想像できるわけです。

主要なAndroidアプリがApp Actions対応を遂げることで、例えばテレビCMでも「○○アプリから○○をしてみよう」ではなく「Googleアシスタントに○○と話しかけよう」というプロモーションも出てくると思います。結果として、ユーザーはスマートフォンの利用方法が変化していくに連れて、VUIへの印象も変化していき、遂には今年は「VUIの方が楽だよね」という状況になっていくのではないかと期待できます。

また、AppleのiOSで提供されているSiriについても、すでにアプリの機能を声で呼び出すことを可能にする「Siriショートカット 」機能があります。Siriショートカットの利用促進により、Androidだけでなく、iPhoneにおいても声で操作することが多くなっていくことでしょう。

スマートフォンを声で操作するようになれば、スマートスピーカーやスマートイヤホンなどのデバイスを今まで以上に使いこなせるようになります。そして、その状況を前提としたサービス構築も増えていきます。今年は、本当の意味で多くの人々がVUIに触れ、そして慣れていく年になるのではないかと予想できます。

まとめ

大きく生活が変化した中でも、AIアシスタントは進化を続けています。そして、次のコンピューティング環境として名乗りを上げているVUIは、模索が続いた昨年までから、今年は真の意味で人々に使われていくことになります。それは、新しいデバイスを買わずとも、皆さんの手にあるスマートフォンから始まっていきます。

生活が変化すれば、便利な道具も変わります。その変化は悪いことだけではなく、良いことももたらしてくれるはずです。AIアシスタントはその代表例として、今年大きく飛躍し、多くの人に使われ、インターネットを変えていくための原動力になっていくはずです。

その変化を、今年は皆さんと共に楽しみたいと思います。

スマートフォンの利用時間](/assets/images/dev/column/newyear/2021/ai-assistant-prospect/thumb/TH800_image2.png)