日本語に特化した大規模汎用言語モデルとして、

AIの民主化に寄与する大規模汎用言語モデル

- ――LINEとNAVERが共同で構築している大規模汎用言語モデルには、

どのような強みがあるのでしょうか。 佐藤:言語モデルには、

従来の特化型言語モデルと大規模汎用言語モデルの大きく2つに分けられます。 特化型言語モデルは、

事前に用意した教師データを使ってファインチューニングを行う際、 最適なアウトプットを出力するためのパラメータの調整を行えるため、 特定のタスクに対して性能を出しやすいといったよさがあります。さらにモデルがコンパクトであることも特化型言語モデルのメリットになります。 一方、

大規模な汎用言語モデルはファインチューニングがしづらく、 モデルも大きなものになる代わりに、 1つのモデルでさまざまな用途に対応できることが利点です。 これにより個別のタスクごとにモデルを作る必要がないことから、

ある問題を解きたいと考えたとき、 スピーディに着手してアウトプットまで辿り着くことができます。 さらに、

大規模なデータを用いてモデルを構築することから、 出力されるテキストが非常に滑らかであることも大規模汎用言語モデルのメリットです。実際、 大規模汎用言語モデルであるHyperCLOVAから出力したテキストは、 AIが出力したものだとわからないレベルです。 砂金:特定の用途に特化して言語モデルを作ろうとすると、

自然言語処理や機械学習、 深層学習を理解している、 市場価値の非常に高い人が何人も必要となってしまいます。 しかし大規模汎用言語モデルであれば、

1つでさまざまな課題をカバーすることが可能です。さらに専門家が関与することなく多くの処理を実施できることも大規模汎用言語モデルの利点です。 従来のAIを用いた対話や文章生成は、

扱うのが非常に難しい側面がありました。しかし大規模汎用言語モデルであれば、 その難しさを解消することが可能です。これによって一気に言語モデルを民主化し、 どんな場面でも気軽に使ってもらうことができる。これが我々のやりたかったことです。

HyperCLOVAの開発はLINEのフラグシッププロジェクト

- ――大規模汎用言語モデルの開発には、

どのような意図や考えがあったのでしょうか。 佐藤:自然言語処理のアプリケーションなどを開発するうえで、

大規模汎用言語モデルを自ら開発できるか否かは大きな分かれ目になり、 我々が到達できる地点がまったく変わります。 LINEとしては、

こうした言語モデルを自分たちで作ることができて、 お客さまが使えるように提供することもできる。そういう立場になるために、 大規模汎用言語モデルの構築に取り組みました。 砂金:我々の身近なところには、

解くべき課題が山積みになっています。その課題ごとに言語モデルを用意するのではなく、 大規模汎用言語モデルを1つ構築し、 それを使ってまとめて課題解決すればいいんじゃないかと考えました。 LINEは提供するサービスの多さや規模ゆえに、

日本語を扱ううえで多くの課題を抱えていますので、 その解決のための仕組みとしてHyperCLOVAを作ったというのは、 すごく自然な流れだったと思います。 - ――ただ、

大規模汎用言語モデルの構築には多大なリソースを費やすことになるため、 プロジェクトをスタートさせるかどうかの判断は難しかったのではないでしょうか。 砂金:流れとして最初にあったのは、

OpenAIが開発した 「GPT-3」 です。これを見たときに、 確かにエポックメイキングだねと話していました。ただ、 GPT-3はあくまで英語圏の言語モデルなんですね。当然ながら言語ごとにクセや難しさがあり、 英語でできているからといって、 日本語でも同じことがすぐにできるわけではありません。 しかしGPT-3で大きな可能性が見えているのに、

英語以外の言語を使う我々はその恩恵を享受できないのは望ましいことではないでしょう。じゃあ誰かがやらなければならないとなったときに、 日本においてはLINE、 韓国ではNAVERがそれぞれやるべきだろうと判断しました。 さらに言えば、

今回のHyperCLOVAの構築は多くの人に注目してもらえるフラグシッププロジェクトになります。そのプロジェクトを走らせることによって多くの人たちに注目していただき、 自分も貢献したい、 あるいはプロジェクトに関わってみたいと考える人が増えるのであれば、 このプロジェクトに取り組む価値は十分にあると考えています。 - ――言語モデルの構築における日本語特有の難しさとしては、

どういったものが挙げられますか。 佐藤:たとえば商品販売サイトで

「モニターが欲しい」 といったとき、 目的のモニターを探すためのキーワードとして、 モニターやディスプレイ、 あるいは液晶モニターや液晶ディスプレイなど、 さまざまなパターンが考えられます。 このように日本語は、

単語に紐付く言葉がたくさん発生し、 その紐付く言葉を適切に指定しなければ求める情報が満遍なく手に入らないといったことが起こります。 日本人の場合、

こうしたことはあたりまえだと思いがちですが、 こうした悩みは日本語圏特有のもので、 それ以外の言語でそういったことに悩むことはあまりありません。 日本語にはこのような特性があるため、

日本語と英語で同じサイズのテキストを集め、 それらを使ってモデルを構築すると、 日本語は英語のものよりも性能が出ないことになります。 また、

日本語は何か学習させるときに文字の種類が非常に多くなってしまいます。深層学習でモデルを構築する際、 その中で使える語彙の数が5万とした場合、 英語であれば文字だけでなく単語まで含めることができますが、 日本語で5万程度だとかなりの部分が1つの文字で埋まってしまいます。そうすると、 英語と同程度の言語モデルを構築するためには語彙の数をもっと増やす必要があり、 学習のやり方や調整もまったく違うといったことが起きます。 こうした背景があるため、

英語と日本語で素直に同じ手法を適用すると、 日本語は全然性能が出ないといったことになります。こうした点は日本語ならではの難しさです。

わからないことがあればHyperCLOVAに聞け!?

- ――HyperCLOVAの用途として考えられるものを教えてください。

砂金:我々が応用の可能性を探っているのは、

文章の生成や要約、 対話などの分野です。 このうち、

文章生成についてはカジュアルな文章から業務報告書のようなフォーマルな文書まで、 さまざまなバリエーションがあります。そのどれにHyperCLOVAを適用すると有効なのか、 あるいは多くの人にとって有用で、 なおかつ開発や構築の面においても無理なくできる領域はどこかといったことを検討しているタイミングです。 考えられるものの1つとしては、

ECサイトなどに掲載する商品説明があります。心のこもった文章ではなくて、 とにかく商品に関する説明をWebサイトに載せなければならないけれど、 大量の商品の説明を書くのは大変である、 そういった場面で使えるのではないかと思います。あるいは業務報告書や障害報告書などの作成をAIが肩代わりできれば便利でしょう。 要約にも利用することができます。リリース予定の

「CLOVA Note」 というサービスを使えば、 会議やインタビューの内容を書き起こしできるのですが、 さらにHyperCLOVAを使って要約を生成すれば議事録の作成を自動化できます。 目的が明確ではない利用シーンもあるでしょう。たとえば雑談を成立させることができるというのは、

それ自体が生産性向上や売上拡大につながるものではないかもしれませんが、 我々にとっては非常に重要なトピックです。 このように文章生成や要約、

対話のそれぞれにおいて、 皆さまのお役に立てるところはあるだろうと思っています。

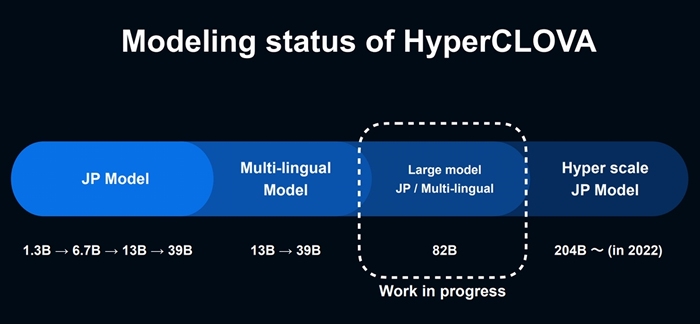

2022年には204Billionモデルの構築にも着手

- ――LINE DEVELOPER DAY 2021において、

820億 (82Billion) という膨大なパラメータを用いた新たな言語モデルを構築中とのお話がありました。82Billionモデルは従来のものに比べ、 どういったベネフィットがもたらされるのでしょうか。 佐藤:実は韓国版に関しては82Billionモデルの構築が終わっていて、

詳細なデータも論文などとして公表されています。 この82Billionモデルでは、

自然言語処理のさまざまなタスクにおいて、 既存の39Billionモデルよりも高い性能を達成できることが韓国語版で確認が取れています。当然、 日本語版でも同じような傾向の性能向上が見込めると考えています。 ただ、

具体的に体験がどこまで上がるのか、 どこまで気持ちよい体験になるのかといった部分について、 日本語版での使用感は確かめられていません。実際にどうなるのか、 すごくワクワクしながら作業を進めています。 また先ほどもお話ししたとおり、

日本語のモデルを作る際、 英語のモデルと同程度の量のテキストでは十分な性能が出ません。そのため、 モデルを構築する際にはパラメータ数の3倍程度のトークンを用意しなければならないことがわかっています。具体的には、 従来の39Billionのときに使ったコーパスよりも、 82Billionのコーパスは2倍ほど大きくなります。 このようにコーパスが大幅に増えるため、

モデルに含まれているコンテンツの量や種類、 傾向といったものがより多く含まれることになり、 39Billionモデルよりも82Billionモデルは幅広い情報のジャンルを扱うことができると考えています。 このようにパラメータ数や計算のステップ数を増やせば性能は上がることが分析結果で証明されています。では、

サンプル数が少ないモデルに価値はないのかというと、 決してそんなことはありません。 82Billionモデルの後、

2022年には204Billionモデルの構築にも取り組む予定ですが、 そのように大きなモデルを構築したとしても、 39Bllionモデルで求める性能が得られたり、 特定のジャンルにおいて問題なく使えるのであれば価値はあります。 具体的な価値としてあげられるのは、

モデルの大きさです。モデルを用いて推定処理を行う際、 そのための環境の大きさはモデルの大きさに左右されることになります。39Billionモデルであれば、 204Billionモデルを使う場合よりも数分の1サイズの環境で済みます。 そのため、

204Billionモデルである必要がなければ、 39Billionモデルといった小さいモデルを使うことに経済的合理性があります。実際、 我々も39Billionモデルの性能向上やデータの更新に取り組む可能性があります。

エンジニアの皆さんにHyperCLOVAをおもしろがって使っていただきたい

- ――最後に、

予定している今後の取り組みについて教えてください。 佐藤:先ほどお話したとおり、

2022年は204Billionモデルの構築を進めることになります。 204Billionモデルになると、

必要なコーパスの量が82Billionモデルの2. 5倍以上となり、 必要になるデータ量が大幅に増加します。一方で、 学習におけるトライアンドエラーの回数が単位時間内では減ることになり、 難易度は増すと考えています。さらに使用するハードウェアの数が増えるため、 その管理コストも増加します。そのほか、 モデル構築にかかるエンジニアの負担や、 失敗したときにロストする時間も増えていくでしょう。 このように大変なプロジェクトになりますが、

完成すればそれに見合うリターンが得られると思っています。 砂金:まず、

HyperCLOVAを多くの方々に体験いただく機会として、 「HyperCLOVA Hands-on」 を12月から1月にかけて開催します。我々がご用意する環境を通して、 どのようなことができるのか実際にお試しいただけるイベントです。また、 何らかのWebインターフェースを用意して、 AIの専門家でなくてもちゃんと使えるような状態で皆さまに公開する準備も進めています。 いずれかのタイミングでハッカソンのようなイベントを開催できるといいなとも思っています。ビジネス先行でマーケットを見据えてアプリやサービスを作るということだけではなく、

エンジニアの皆さんに我々の技術を面白がっていただき、 これを如何に使いこなすかといったところから新しい価値が生まれる可能性がある、 HyperCLOVAはそういった技術だと考えています。 また、

HyperCLOVAを世の中に出していく際には、 いくつかのステップがあると思っています。 現状はLINEのAIカンパニーの中で試行錯誤している状態で、

この後はLINEのさまざまなサービスで使われるようになるでしょう。その後は、 Yahoo! JAPANやZOZOTOWN、 アスクルといったZホールディングスグループ各社のサービスでの活用の可能性があると思います。そして将来的には、 外部に公開する可能性もあるでしょう。 その際、

裏側でHyperCLOVAの技術が使われていて、 それによってユーザ体験が変わったということになればすごくうれしいのですが、 ユーザに気づかれたら負けだという感覚もあります。このAI技術はすごいだろうというのは、 裸が丸見えの状態みたいで格好悪い (笑)。そうではなく、 気づかないようにさっとユーザに手を差し伸べる、 あるいは煩雑だった操作がすごく楽になっている、 そういったことをユーザに気づかれずにできれば我々の勝ちだと思っています。 もし、

一刻も早くHyperCLOVAに触りたいと考えていただけるのであれば、 LINEやZホールディングスグループ各社にご入社いただくことが一番の近道だと思うので、 ぜひ検討していただきたいですね。 - ――本日はありがとうございました。