とのこと。

そうした状況を改善するため、現場に近いところで提案を行うコンサル型データアナリストと、MapReduceやデータマイニングにすぐれたエンジニア型データアナリストが、事業マーケターと協働できる体制が作られました。タイプの違うアナリストが一緒に動くことでこれまでにないシナジーを起こし、より多くのビジネス案件を回していくという方針に切り替えたのです。

ちなみに石川氏はエンジニア型で、「リクナビ」や「カーセンサー」などの事業マーケターからコンサル型(分析者)のもとに上がってきた要件定義に対し、事業担当者と直接のやり取りを行いながら実装や分析を行い、技術提案や、場合によっては案件提案も行うという、最前線の部隊に属しているそうです。

このように見ていくと、リクルートでは至極スムースにデータ分析のための活動が行われているように思えますが、多くの企業が陥る情報活用の失敗に、リクルートもまた苦しんできたと石川氏は言います。「分析をしただけで、何のビジネス効果も得られないということも正直あった。効果がなければ予算を獲得できなくなるし、そもそもデータを信用しなくなるという風土になりやすい。だがリクルートが(情報活用で失敗した)他社と違ったのは、ボトムアップの文化があったという点。事業担当者もエンジニアも分析者も、上から降ってきた案件ではなく、泥臭く要件を出して実装を繰り返し、効果を出すことにつなげてきた。この泥臭さがHadoopの社内での普及につながった」と石川氏。

予算がないから、実績がないから、と上層部にダメ出しされてもあきらめることなく、Hadoopの良さを信じて"泥臭く"現場から提案を続けたことが、いまのリクルートグループにおけるHadoop活用につながっているのです。

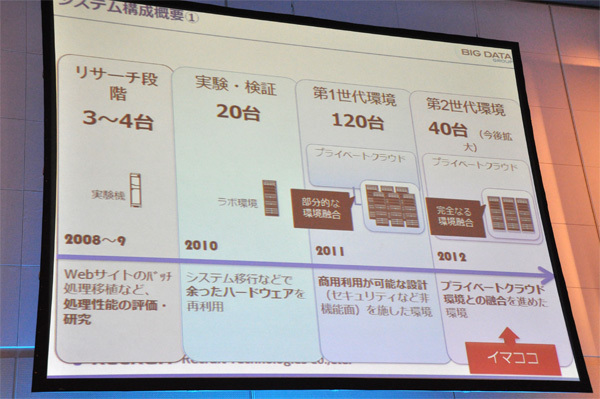

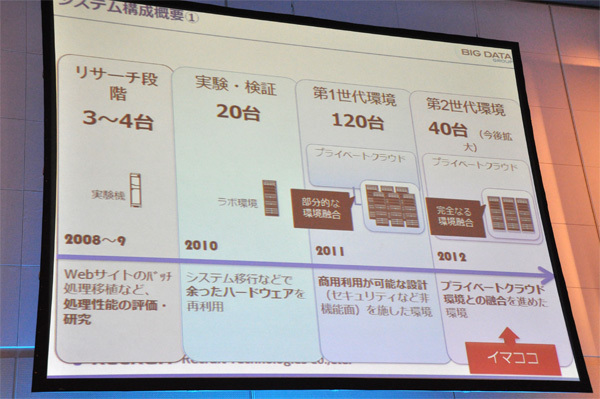

もともとリクルートはビッグデータという言葉がバズワードとなる前から、データ分析に取り組む環境を段階的に整えて来ましたが、ここ1、2年でとくに大きく変わったのはやはり扱うデータ量が膨大になったことだと石川氏は言います。現在の同社におけるHadoopシステム構成は"第2世代"、MapRおよびGreenplumMRが稼働する40台のHadoopクラスタをプライベートクラウドと完全に統合し、3ノードから利用リソースに応じて増設できるしくみになっています。Apache HadoopとCDHで構成されていた第1世代のHadoopシステムは120台でプライベートクラウドとの統合も部分的だったことを考えると、統合を進めたことでより効率的なリソース活用が実現できていることがわかります。

Hadoopをプライベートクラウドに完全統合し稼働台数の削減に成功

またリクルートではHiveやmahout、sqoop、HBaseといったHadoopエコシステムも積極的に活用しています。とくにSQLライクな操作が可能なHiveはエンジニアだけでなく、分析を担当するコンサルタントにも利用しやすいため、社内で広く普及しているそうです。

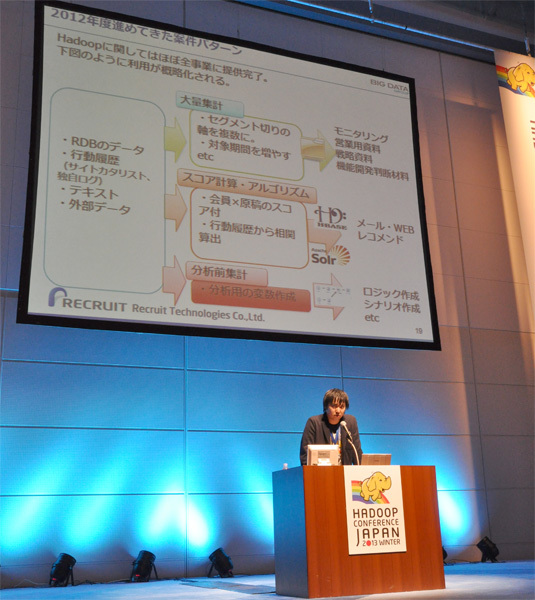

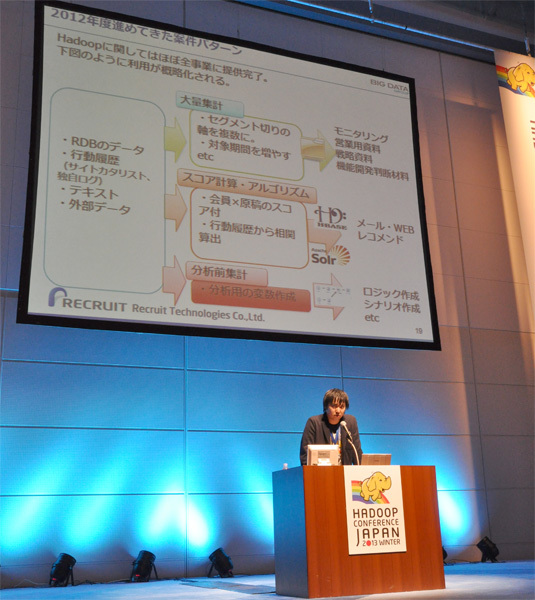

RDBで37時間の処理がHadoopでは30分、利益効果は1億円相当

「リクルートのほぼ全事業部でHadoopを提供している。現在、13事業部で120件超のデータ利活用を展開中」という石川氏。データソースにはRDBのデータはもちろん、行動履歴、テキストデータ、そして外部から購入したデータなども含まれます。案件パターンとしては、モニタリングや営業用資料、戦略資料のベースとなる「大量集計」、メールやWebレコメンドに使われる「スコア計算/アルゴリズム実装」、ロジックやシナリオの作成に利用する特別な分析変数を用いた「分析前集計」があり、すべての案件がこの3つのどれかに当てはまるとのことです。

Hadoop運用3つのパターン

ここで石川氏が具体例として挙げたのが、国内No.1の就職/転職サイトである「リクナビ」の事例です。現在リクナビでは、2014年以降卒業予定の学生に対して情報を提供する「リクナビ2014」を展開していますが、個人の行動履歴をもとにHadoopで分析したお勧め企業一覧を表示する「パーソナライズド企業一覧」という機能を実装したところ、7日間で1万8,000ものエントリがあり、そのうちお勧め企業をまとめてエントリする一括エントリも149回(1万3,410件)あったとのこと。これは「利益として計上すると約1億円」(石川氏)にも上る効果だそうです。

また社会人向けの転職支援を行う「リクナビNEXT」では、応募総数の促進をはかるため、ユーザに対して別のユーザを転職仲間としてレコメンドする「転職仲間機能」を2012年4月から実装しています。ログインの頻度やアクティブ/ノンアクティブなどからユーザの指標を抽出し、ユーザごとに属性のあったユーザをレコメンドする機能で、こちらは1週間で約70の応募増という効果を得ています。さらにこの転職仲間機能のロジックを「リクナビ2013」に移行し、メールで配信したところ、通常のメールに比べて2倍の効果を得ることができたそうです。「風通しの良い組織だからできることで、チームをひとつにした甲斐があった案件」と石川氏は語っています。

このように着実にHadoop活用を利益につなげているリクルートの事業ですが、石川氏は次の戦略の施策として「オファー施策の改善」を挙げています。レコメンドのような目に見えやすい施策と異なり、「オファーはどのようなステータスのカスタマーに送られているのか」「オファーを受信するタイミングで返信率はどの程度変化するのか」といった分析を高い精度で行うことができれば、スカウトメール送信など新たな商品の開発につながります。「こうした商品は保存データの容量が限られていた既存のRDBだけではできなかった。Hadoopにデータを移行したことで、会員の離脱のタイミングやレジュメの変更比較が可能になり、部分的な行動履歴ではなくその範囲を拡張して長期保存できるようになった。こうした下準備が整っているからこそ分析が進む」(石川氏)

既存のRDBでは実現できなかったことがHadoopで実現できるようになったもうひとつに、処理の速さを挙げることができます。「分析の中で使われる1つのクエリは、メッセージ送信テーブル(3,500万件)と行動履歴テーブル(7億件)を外部結合して120億件の中間テーブルを作成する処理を行っている。通常のRDBでは37時間程度かかると見られているが、Hadoopではこれが30分で返ってくる」と石川氏。文字通りのビッグデータを裏で支えるHadoopの力を証明する価値あるアウトプットと言えるでしょう。

今後世に出るすべてのサービスのバックでHadoopが動く!

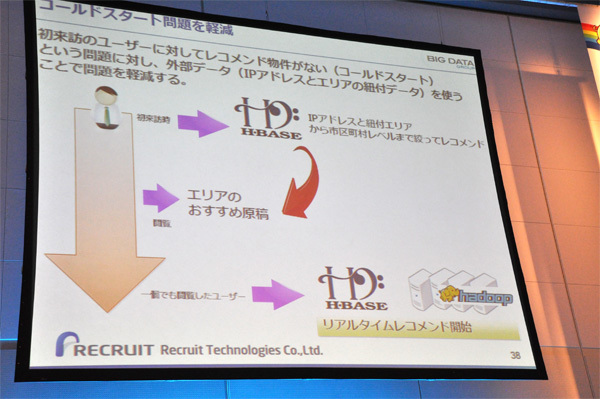

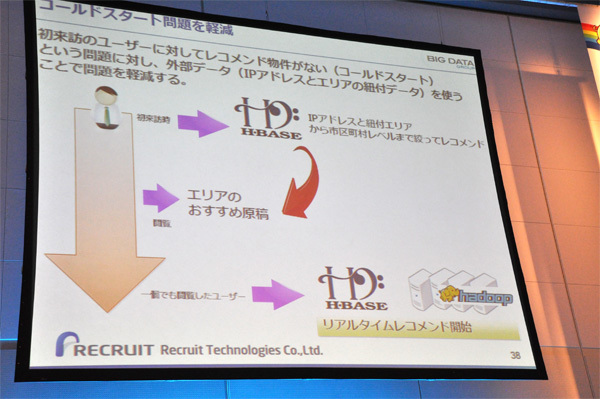

すでにリクルートにおいては「Hadoopは開発ステージから利用ステージに入っている」(石川氏)という状況にあります。その中で現在、力を入れている技術が「はたらいく」などのマッチングサイトにおけるリアルタイムレコメンド機能の実装です。マッチングアルゴリズム作成フェーズの演算を移植したHadoopと、行動履歴の保存先としてカラムナー型データベースのHBaseを連携させ、リアルタイムレコメンドを行うというもので3月には実装完了予定とのこと。「もともと組織改編前から形態素解析を続けており、両方向で活用のめどをつけていた。リアルタイムで差配が効くレコメンドアルゴリズムが実装されるはず」(石川氏)

リアルタイムレコメンドが「コールドスタート問題」にも効く?

また、Hadoopエコシステムのプロダクトの中ではHiveの活用にも注目しているそうです。「リクルートには非構造系のデータがたくさん残っている。HBase 0.92から追加されたコプロセッサ機能などを使ってオンライン画像解析などに役立てたい」と石川氏。エンジニアだけでなく、事業部の誰もがHadoopを使えるようにするために、ユーザビリティを強化したツールの提供やTipsの整備も進めていくとしています。「使い手がHiveに慣れてくれば、SQL対応のApache DrillやCloudera Impalaの導入を進めることもできる」と石川氏が語るように、ユーザの成長に応じて利用するソリューションを変更していく姿勢はITがビジネスと寄り添っていくためにも重要なポイントです。

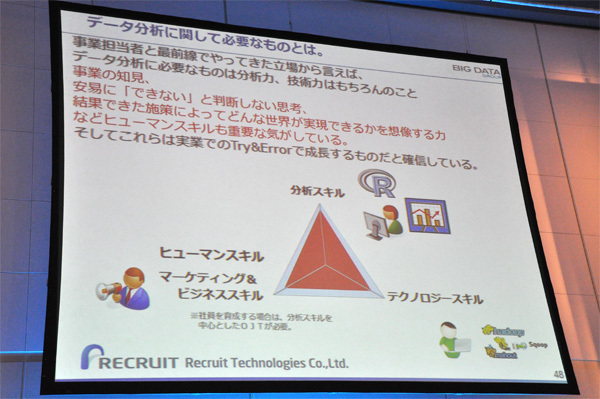

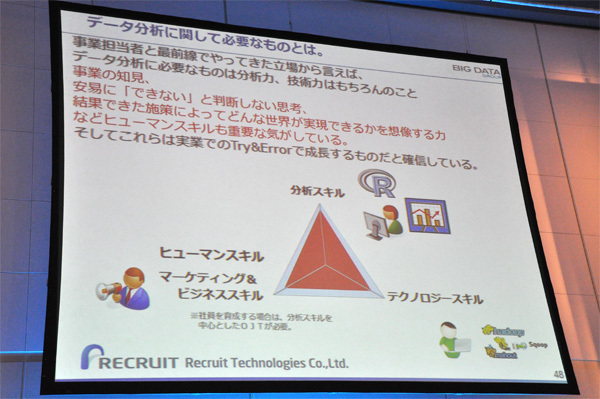

講演の最後、「リクルートのビッグデータ解析は"トライ&エラー"方式」と石川氏は強調しています。すばやく環境を構築し、データを移行し、実際のデータを使ってアウトプットを行い、その結果を見ながら要件を詰めていく。その繰り返しがやがてひとつの施策を生み出していくことにつながるのです。「データ分析に必要な素養は、分析力、技術力、そしてヒューマンスキル。そしてこれらは本や哲学書で身につけるものではなく、トライ&エラーを繰り返す実業の世界でこそ身につく力」と語る石川氏の言葉に、組織の壁をなくしてビジネス部門とIT部門がお互いを伸ばしてきた実績を見ることができます。

データ分析に必要なのは技術力+ヒューマンスキル

「リクルートはこれからもHadoopを使い倒していく。今後、世に出るサービスはすべて後ろでHadoopが動いている。リクルートのサービスを使うとき、そのことにすこしだけ思いを馳せてくれるとうれしい」─リクルートは、就職や転職、結婚、引越しといった人生の大きなイベントと、グルメや旅行、習い事などの日常のイベント、その両方でユーザとクライアントを結びつけるサービスを提供しています。あらゆるサービスでNo.1のシェアをもつリクルートの全サービスがHadoopで稼働しているなら、我々の人生も日常も、Hadoopに支えられている部分は少なくないのかもしれません。