ここ1年ほどの間、データアナリティクスの世界ではマシンラーニング(機械学習)や深層学習(ディープラーニング)といったキーワードをニュースなどで頻繁に聞くようになりました。その理由に、自動運転カーやロボティクス、あるいは「アルファ碁(AlphaGo) 」など、AIにおける技術革新が実用レベルに達しつつあることを感じさせるユースケースが増えていることが挙げられます。そしてこれらのイノベーションの本場はやはりシリコンバレーであり、この地を本拠とするGoogleやFacebook、AppleといったAI研究の最先端企業に牽引され、データアナリティクスの世界はすさまじいスピードで前に進んでいます。

世界最先端を行くAI、そしてデータアナリティクスの本場ではいま何がホットトピックなのでしょうか。 本稿では3月9日、10日(米国時間)の2日間、米サンフランシスコで開催されたデータアナリティクスのカンファレンスである「Gigaom Structure Data 2016」の現地取材を通して、2016年のデータアナリティクスの中心となりそうなトピックを挙げてみたいと思います。

Spark+Kafka ─リアルタイムストリーミング処理の生命線

2月に東京で行われた「Hadoop / Spark Conference Japan 2016 」では国内におけるSparkブームの拡大を強く感じましたが、Sparkを生み出したUC BerkeleyがあるシリコンバレーでもSparkの普及スピードはすさまじく、データサイエンティストを名乗るならもはやSparkは必須スキルという雰囲気さえ漂います。

「Sparkは(アナリティクスにおける)アプリケーションの作り方を根底から変えた。Hadoopの良さを引き続きながら、アクセラレーションに注力し、処理スピードを大幅に改善した功績は大きい」と語るのはApache Kafkaのクリエーターのひとりとして知られるNeha Narkhede氏です。LinkedIn出身のNarkhede氏は現在、Kafkaベースのストリーミングデータ処理を得意とするスタートアップCofluentのCTOとして活躍中ですが、「 リアルタイムデータを収集するKafkaと低レイテンシでデータを処理するSpark、現在はこの組み合わせがデータアナリティクスにおける定番になりつつある」と語っています。

Neha Narkhede氏(中央) 、Ion Stoica氏(左)が登壇した「Building the data framework for tomorrow's apps」と題されたセッション。右端はモデレータのZDNet、Andrew Brust氏

ちなみにKafkaについては、ユニコーン企業の代表格ともいえるSlackのデータエンジニアリングディレクター Josh Wills氏が別のセッションで「Kafkaは我々にとって頭で考えて使うものじゃない。Kafkaはもう空気みたいな存在で、なければ息ができなくなる」と強調していたのが印象的でした。

Kafkaについて語るJosh Wills氏(中央)

Narkhede氏が指摘する通り、SparkとKafka、そしてPrestoなどのオープンソースのミドルウェアはいまやリアルタイムデータアナリティクスに欠かせない存在です。現在、データアナリティクスの世界は強力な"リアルタイム指向"ともいうべきトレンドが支配的で、そのニーズに応じてSparkやKafkaも進化しているといえます。たとえばSpark開発の中心的存在であるDatabricksでCEOを務めるIon Stocia氏は「DatabricksはSparkがノーマルなクエリ(SQLクエリ)をリアルタイムで扱えるようにするために、新たなエンジン(Spark SQL)を投入した。これによりストリーミングデータを構造化データのように処理できるようになった」と語っており、SparkはHadoopの資産に必ずしもこだわるのではなく、アナリティクス基盤としての速さと使いやすさをどこまでも追求していく姿勢であることを示しています。Sparkはまもなく2.0がリリースされる予定ですが、1000人以上のコントリビュータがその開発スピードの向上に寄与しています。こうした体制がプロダクト自体の速さを支えているとも言えるかもしれません。

ペタバイトを捌けるのはオープンソースプロダクトだけ

オープンソースプロダクトをデータプラットフォームの中核エンジンとして利用するユーザは多く存在しますが、その象徴的存在ともいえるのがNetflixです。毎日1兆を超えるトラフィックをさばき、「 ユーザ数の増加よりもデータ量の増加のほうがはるかに大きい」( Netflix データプラットフォーム部門ディレクター Eva Tse氏)というNetflixでは、膨大なストリーミングデータをいかに効率よく処理するかは最重要課題です。

Netflix、Eva Tse氏(左)のセッション

Tse氏は「NetflixのデータインフラはAmazon S3、Spark、Kafka、Presto、Hive、Pigなど、オープンプラットフォームで構成されている。Teradataなどのプロプライエタリも使っているが、エンジンレイヤはすべてオープンソース。ペタバイト級にスーパーリニアにスケールするデータをさばけるのはオープンソースしか考えられない」と断言しています。とくにPrestoを導入してからは、それまで数十分以上かけていたクエリ処理の90%を1分以下に短縮できるようになったとのこと。プロプライエタリを否定するわけではないが、Netflixのようにデータのスケール規模が桁違いになると、データプロセッシングの要となるミドルウェアにプロプライエタリを採用することはさまざまな面でリスクが大きいことがうかがえます。

Google ─世界最先端のAI企業がいま取り組んでいること

囲碁の世界チャンピオンとGoogleの「AlphaGo」の対決は世界的にも大きなニュースとなりましたが、その対局にも関与していたGoogleのシニアフェロー Jeff Dean氏は韓国での対局の途中から直接本カンファレンスにかけつけました。

Googleはここ数年、検索エンジンの会社からAIを事業の中心とする巨大企業への転身を急速に進めています。Dean氏は「Google Brain(ディープラーニングプラットフォーム) 」 「 Spanner(GPSを駆使したデータセンタープラットフォーム) 」などGoogleの最先端AIプロジェクトの中心人物として知られており、まさしく"AI企業としてのGoogle"を象徴するひとりです。

Jeff Dean氏(左)

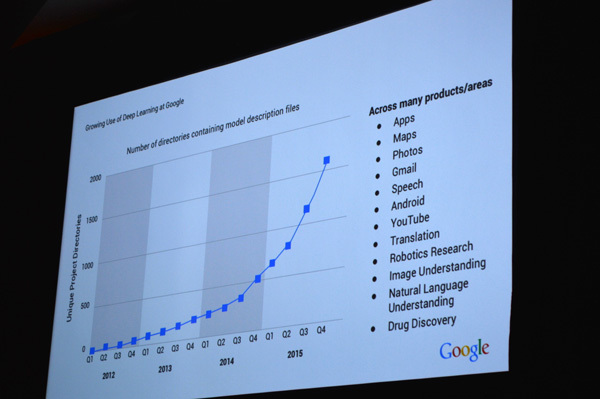

現在、GoogleがAI研究にどれほどフォーカスしているのか、Dean氏は1枚のスライドを見せてこれを説明しています。現在、AI研究に関するGoogleのプロダクトは1500を超えていますが、その数が急激に増えたのは2015年後半から2015年にかけてのこと。とくに2015年後半からのフォーカスは急激で、その勢いはいまも継続中です。

GoogleのAIプロダクト数の増加

このGoogleのAIへの取り組みを象徴するプロダクトがオープンソースのディープラーニングフレームワーク「TensorFlow」です。2015年12月に公開され、世界中で大反響を呼んだこのライブラリは「現在、マシンラーニングのレポジトリとしてはGitHubで一番ダウンロードされている」( Dean氏)存在となりました。なおDean氏はTensorFlowを含むGoogleのディープラーニングプロダクトを「ニューラルモデル(Neural Model) 」と呼んでいました。

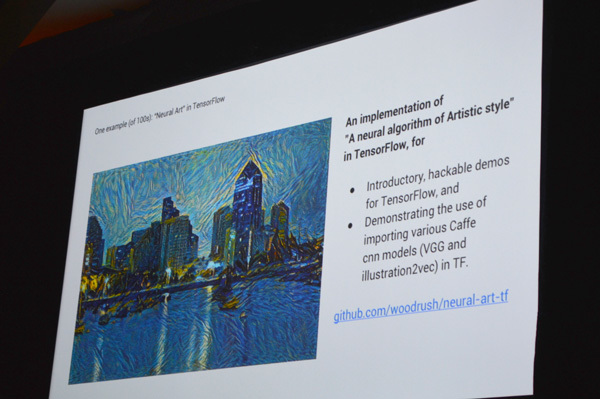

TensorFlowではこれまで一般のエンジニアでは手が届かなったような環境がさまざま提供されます。たとえば、任意の画像や写真に対し、ニューラルアルゴリズムを用いてアーティスティックに描画する「Neural Art」などはその一例です。

TensorFlowによる「Neural Art」

AlphaGoのニュースでふたたびTensorFlowへの注目度が高まっていますが、ディーン氏は現在のニューラルモデルの課題は「人間に比べて表現力と認識力に欠けている」ことを指摘しています。たとえば人間なら「○○さんが小さなグリルを使ってサンドイッチをあたためている」と目で見て認識できる光景を、ニューラルモデでルは「あるひとりの人間が何かの食べ物をグリルで調理している」と表現します。この認識の精度を高め、人間と同等の表現力を得るためにGoogleが始めたマシンラーニングプロジェクトが「Google Cloud Vision API」です。Dean氏は「画像を"トランスレーション"する能力」を飛躍的に高めるためにGoogle内でもチームを拡大中だとしています。この研究がさらに進めば、人間と同等の画像認識能力どころか、その画像に直接は写り込んでいないコンテキストまでを読み取り、人間では分析できないレベルでの予測すら可能になるのではないかと思えてきます。

Google Cloud Vision API

Spark登場で“アナリティクスの世界が多様化した”

シリコンバレーでは現在、女性データサイエンティストが急増しており、本カンファレンスのスピーカーのひとりでもあったAirbnbのデータサイエンスマネージャ Elena Grewai氏は「Airbnbでは意図的に女性データサイエンティストを採用する方向にある」と語っています。多様なデータを分析し、多様なアプリケーションを作り、多様なビジネスに対応していくためには、データサイエンティストもダイバーシティに構成されていなければならない ─これはAirbnbだけでなく多くのシリコンバレー企業に共通する認識のようです。

Airbnb、Elena Grewai氏(左)

取材中、ひとりの若いイラン人女性データサイエンティストと話をする機会があり、彼女はシリコンバレーの現状を次のように語りました。「 シリコンバレーは本当にいま女性のデータサイエンティストが増えている。PyhtonとSparkが使えれば、とりあえずスタートラインに立てる。Hadoop全盛のころはそういう雰囲気はなかったかもしれないけれど、Sparkが主流になってからは明らかにアナリティクスの世界が多様化したように思う。大きなデータに、時間をかけてちまちまとHadoopでバッチ処理するなんて、もうかったるくてやってられない」 。

ほしいデータは過去ではなく"いま"にある、その"いま"を"すぐ"に分析するのに女性の力を活用しない手はない…、ダイナミックに動き続けるシリコンバレーのデータアナリティクスは、"リアルタイム"をキーワードに誰も見たことがない世界へと進化を続けています。