6月28日~30日(米国時間)の3日間に渡って米サンノゼで開催された「Hadoop Summit 2016 San Jose」には、世界36ヵ国から約4000名が参加し、Hadoop誕生から10周年を迎えたアニバーサリーイヤーにふさわしい盛況を見せていました。Hadoopのユーザや開発者、そしてHadoopビジネスを展開する企業が世界中から集まる現場に居合わせると、あらためてHadoopがデータ分析プラットフォームのデファクトスタンダードとして、確固たる地位を獲得したことを強く実感させられます。

筆者は昨年も本カンファレンスに参加 しましたが、変化のスピードが速いIT業界を象徴するかのように、昨年にはなかったいくつかのトレンドがHadoop周辺で起こっていることを感じました。本稿では3日間の取材を通して見えてきた、Hadoopおよびデータ分析ビジネスに起こりつつある兆候について検証してみたいと思います。

Hadoop Summit 2016 San Joseの会場となったサンノゼコンベンションセンター

Elephant in the Cloud ―クラウドへのHadoopデプロイと連携が本格化

Hadoop SummitはHadoopディストリビュータのHortonworksがYahoo!とともに世界各地で主催するイベントですが、もっとも規模が大きく、話題性が高いのがここサンノゼでのカンファレンスです。なお、2016年10月には東京ではじめてのHadoop Summitが開催されることが決定しています。

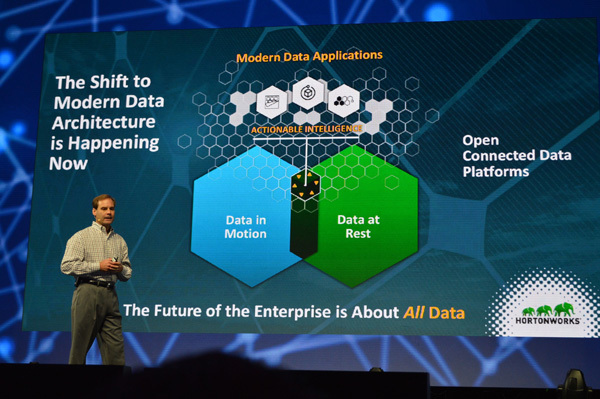

開催期間の3日間に渡ってキーノートのホストを務めたHortonworksのプレジデントであるハーブ・クーニッツ(Herb Cunitz)氏は、オープニングで現在のデータビジネスを取り巻くテーマを5つ挙げています。

急速に進むデジタル化により、あらゆる顧客はビジネスを変容(transform)させる必要に迫られている

テクノロジの側面だけではなく、ビジネスバリューの側面からデータが語られるようになっている

データがどこに分散していてもつねに"Connected"である状態が求められており、とくにデータセンターとクラウドをまたいだ連携が重要になっている

エンタープライズでの利用に耐えるにはセキュリティとガバナンスを備えたスケーラビリティが必要

エコシステムの構築と成長を促進する

Hortonworksのプレジデント、ハーブ・クーニッツ氏によるオープニングセッション

クーニッツ氏が挙げているトレンドはここ1、2年のIT業界でよく耳にするものですが、ことHadoopビジネスに限って言えば、クラウドとの連携はもっとも注目度の高いテーマです。これまでHadoopを導入する企業のほとんどはオンプレミス(データセンター)での稼働を選択していました。しかし、エンタープライズ企業によるAmazon Web Services(AWS)やMicrosoft Azureなどパブリッククラウドへのデータ移行が急激に進むに従い、"Elephant in the Cloud"―クラウド上でのHadoopのデプロイおよびデータセンターとクラウドのデータ連携が現実感を伴ったニーズとなりつつあります。

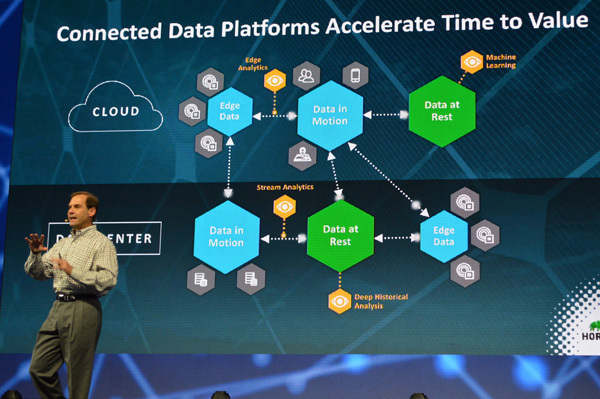

ではHadoopのトップベンダであるHortonworksはこのクラウドへのニーズをどのように捉えているのでしょうか。初日キーノートに登壇したHortonworksのロブ・ビアデンCEOは「データの性質と処理のパターンによって、クラウドとデータセンターを使い分け、適切に連携させることが重要」と強調しています。「 適切なデータを適切な場所に置き、互いに連携させることでつねに"Connected"なデータプラットフォームが構築され、データを価値に変えるスピードを加速する」( ビアデンCEO)

Hortonworksのロブ・ビアデンCEOによるプレゼン:現在求められているのはクラウドとデータセンター間のデータのシームレスな連携

ビアデンCEOはここで具体例としてリテール業界におけるデータ連携を取り上げています。POSデータにもとづいたサプライチェーンの最適化、店舗におけるオペレーション、インベントリシステムの構築、ソーシャルメディアからの情報の吸い上げ、顧客の購入パターンの分析、ロイヤリティプログラムや顧客の360度分析など、業界に特化したニーズに対し、高い精度とスピードでもって応えていくためには、1ヵ所にデータを集約するのではなく、データのステータス(誕生したてのデータ/動くデータ/静止するデータ)と処理のパターンによって置き場所を分ける必要があります。リアルタイムにソーシャルデータのエッジ分析を行うならクラウド上ですべての処理を完結し、インベントリシステムならデータセンター上に対象となるデータを集約してヒストリカル分析を行う、といったように"適材適所"なデータの扱いがいまのビジネスには求められているのです。

「Hadoopがバッチオリエンティド(batch oriented)だった10年前とは、データアプローチのスタイルが激変している」というビアデンCEOの言葉通り、データソースもデータ処理のパターンもその書き出し先も多様化しています。もちろん、これまでも「Amazon Elastic MapReduce」のようにパブリッククラウド上で提供されるHadoopのマネージドサービスはありましたし、Treasure DataのようにAWSクラウドの上に構築されたHadoop基盤上でデーター分析サービスをワンストップで提供するベンダもあります。しかし現在求められているのは単なるクラウドへのデータ集約や分析ではなく、データの性質に応じたクラウドとデータセンターの使い分けと、それらのシームレスな連携、つまり"Connected"であるというのがHortonworksの主張です。データはどうしても部門ごと、事業ごとにサイロ化しがちなので、これらを自在に連携させることこそがビジネスの差別化に欠かせないとしています。

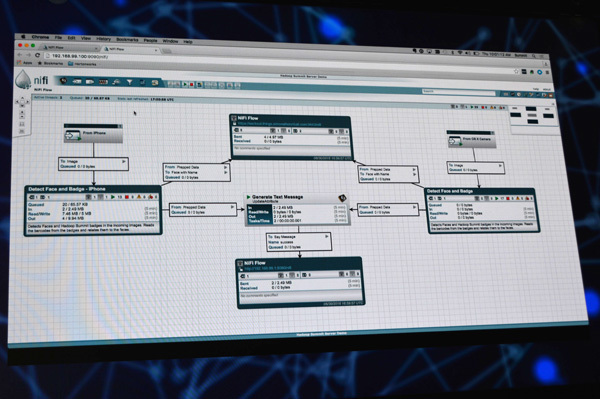

Hortonworksは2015年7月、Apache NiFiというデータフローオーケストレーションツールの開発を手掛けるOnyaraというベンチャーを買収し、この技術をベースに「Hortonworks DataFlow(HDF) 」というディストリビューションを展開しています。従来から提供するApache Hadoop 100%互換の「Hortonworks Data Platform(HDP) 」が"静止するデータ(Data in Rest)"を扱うのに長けているとしたら、HDFはIoTのストリームデータなど"動くデータ(Data in Motion)"の収集から分析を行うのに適しています。もちろんクラウドにもオンプレミスにも対応しています。静と動のデータをクラウドとオンプレミスの両方でConnectedな状態を保つ ―"Elephant in the Cloud"というよりも"Elephant also in the Cloud"のほうが適切かもしれません。

データオーケストレーションツールのApache NiFiはHDFのベースとなるプロダクト。データフローを最初から最後までデザインできるところが最大のポイントで、ストリームデータなど動くデータを扱うのに最適

静止するデータ(Data at Rest)と動くデータ(Data in Motion)を適切に連携させることが今後のHadoop上でのデータ分析におけるキーテーマ

Hadoopイノベーションの担い手となったMicrosoft

今回のHadoop Summitでは昨年までにはなかった「イノベーションスポンサー」という枠が設けられ、そこに名前があった企業はMicrosoftでした。つい数年前まで「Dryad」という独自の並列分散処理基盤を開発し、Hadoopを敵視していたMicrosoftが、オープンソースの巨大プロジェクトであるHadoopの名を冠したカンファレンスに特別枠のスポンサーとして参加する―Hadoop誕生の10年前には誰も想像できなかったことだと思います。サティア・ナデラ氏がCEOに就任して以来、怒涛の勢いで変革を続けるMicrosoftですが、オープンソースへの傾倒、そしてHadoopへのコミットが、日に日に強く/深くなっていることを強烈に印象づけていました。本カンファレンスでのMicrosoftの存在感はきわめて強く、Microsoftブースや主催セッションにはつねに多くの人々を集めていました。

Microsoftブースに置かれていたTuxペンギンたちが隔世の感を醸し出す

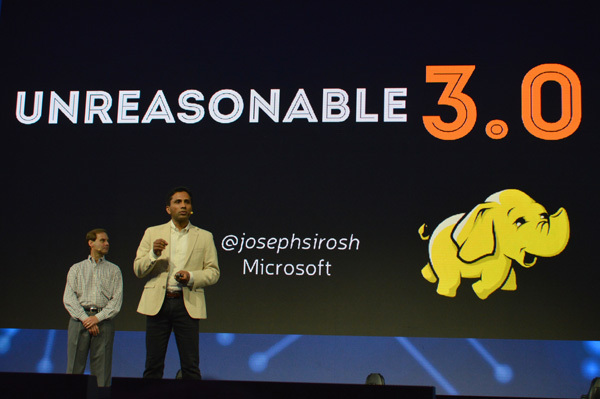

初日のオープニングキーノートにはビアデンCEOに続いてMicrosoftでデータグループ部門のバイスプレジデントを努めるジョセフ・シロシュ(Joseph Sirosh)氏が登壇し、Microsoftがデータビジネス、とくにAzure上でのデータ分析において実現してきたいくつかの大きな成果を強調しています。

マシンラーニングによってインドの子供たちが貧困から学校をドロップアウトする状況を予測、回避策を取ることで低減へ

3.11の福島の原発事故による放射能汚染に関するデータをAzure上のHadoopサービスである「Microsoft Azure HDInsight」に集約し、ヒートマップを作成

世界中の女性の健康リスクを減らすための施策について、Cortanaを使ってアイデアを出しあうオープンコンペティション「Women's Health Risk Assesment」

シロシュ氏はこれらのイノベーションを「Unreasonable 3.0」と表現しており、現代のACID(Algorithm/Cloud/IoT/Data)によって既存の常識では考えられなかったことが次々と現実化していると語っています。

HDInsightでデータを集約し分析した福島の放射能汚染ヒートマップ

Unreasonable 30 - データの力により「いままでできなかったことができるようになってきている」と強調するMicrosoftのシロシュ氏

なお、MicrosoftのHadoopソリューションであるHDInsightはHortonworks Data Platformをベースに構築されており、今回のカンファレンスでは両者が今後、クラウド上のHadoop関連ビジネスにおけるパートナーシップを強化していくことが発表されています。こうした提携からも、"Elephant in the Cloud"へと向かうトレンドがうかがえます。

10 Years of Apache Hadoop!

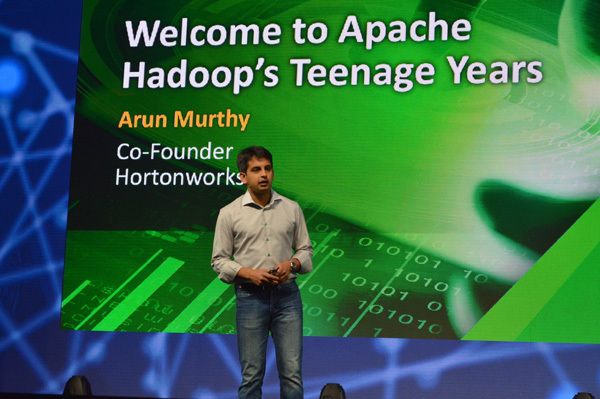

オープニングキーノートには引き続き、Hortonworks創業者のひとりであり、Hadoop界のレジェンド的存在としても知られるアルン・マーシー(Arun Murthy)氏が登壇し、Apache Hadoopが10歳の誕生日を迎え、晴れて"ティーンエージャー"になったことを喜ぶとともに、これからのHadoopの課題として「モダンアプリケーションはすべてデータ・アプリケーションとなる。だからこそ、Hadoopは現在の100倍使いやすく、デプロイしやすく、セキュアで、管理しやすい存在にならなければならない」と語っています。マーシー氏はとくに増え続けるオンライン詐欺や企業への大規模攻撃を取り上げ、これらの悪意に対抗するにはHadoop上でマシンラーニングなどを駆使したリアルタイム分析がますます重要になってくるとしています。

Hortonworks共同設立者 アルン・マーシー氏のセッション

オープニングキーノートの終わりには、世界中から集ったHadoopコミッタが壇上に上がり、Hadoopの10周年ケーキとともににぎやかにお祝いが行われました。日本からもコミッターとして小沢健史PMC(NTT) 、鯵坂明PMC(NTTデータ)の2人が参加しています。世界中の開発者がそれぞれの現場での課題感を持ち寄りながら、英語で議論を重ね、交流し、Hadoopを進化させながら自分自身の腕も磨いていく、そうしたコミュニティの力、オープンソースの力がHadoopをここまで成長させてきたことをあらためて強く感じさせるセレブレーションでした。

コミッタが登壇してHadoopの10歳をケーキでお祝い。小沢PMCと鯵坂PMCも登壇

Hadoopコミッタは会場のどこでも声をかけられすぐにディスカッション。日本から参加の小沢PMC、鯵坂PMCも各国の参加者から大人気でした。

昨年のHadoop Summitのテーマが「リアルタイム」と「エコシステム」であったなら、今回のテーマは明らかに「クラウド」 、そして「Connected」であったように思えます。リアルタイムとエコシステムをさらに一歩進め、どんなデータがどこにあっても、どんな処理がなされていても、スピーディにセキュア実行すること、それがイノベーションを加速する - ビアデンCEOは「データはいまやプロダクトであり、どんな企業にとっても欠かせないアセット(資産)だ」とキーノートで語っていましたが、裏を返せばデータをプロダクトとみなせず、適切に扱えない企業は市場に入ることすらできない時代になっているのかもしれません。そしてデータの必要性と重要性が高まるほどに、Hadoopの存在価値も高まっていきます。

もうひとつ、今回のカンファレンスで強く印象に残ったのは、参加者の多様化でした。Hadoop開発者にはもともとインド系や中国系の人々が多いのですが、今回は女性の参加者も目立って増えています。とくにSparkやマシンラーニング系のセッションでは女性が半数近くいることも少なくありませんでした。主催者のHortonworksやYahoo!に女性が多いということも影響しているのかもしれませんが、データが多様化するならそれを扱う人材も多様化するのは当然の流れであり、シリコンバレーを中心に新しい変化が起こりつつあることを実感しました。

この10年、HadoopはビジネスとITの変化とともに、自分自身をダイナミックに進化させてきました。ティーンエージャーになったHadoopがこれからどう成長していくのかに、引き続き注目していく必要がありそうです。