サポートページ

ダウンロード

(2019年3月7日更新)

サンプルファイルのダウンロード

本書のサンプルファイルをご利用いただけます。

サンプルファイルの利用方法についてはzipファイル内のREADME.txtを参照してください。

- ダウンロード

- sample.zip

補足情報

(2019年10月1日更新)

Webサイトの変更等により動作しなくなった箇所の修正情報を一部掲載します。

著者のブログにていくつかフォローしている箇所もあるので、こちらもご覧ください。

P.279 broad.py

(2019年7月9日更新)

Webサイトの変更に伴い動作しなくなっていました。

|

P.273 サイトの変更に伴う入力内容の変更

(2019年2月22日更新)

サイト内容に伴い、住所、スコアの取得が動作しなくなっていました。

下記のようにそれぞれ変更してください。

| 変更前 |

|

|---|---|

| 変更後 |

|

P.189 P.190 Amazon.co.jpの注文履歴

(2019年2月7日更新)

Amazon.co.jpの変更に伴い、書籍中のrobobrowserを用いたコードは動作しなくなっています。

もとのコードを参考に5.6などで解説しているSeleniumを利用してください。

P.81 SQL文のMySQL 8.0対応

(2018年10月31日更新)

MySQL 8.0以降では rank が予約語になったため、SQL文中で rank という名前を使用している箇所をバッククォートで囲う必要があります。

具体的にはP. 81のリスト3.4 save_mysql.pyの14行目を次のように変更します。

|

P.136 Twitter API利用時にCallback URLを使わない方法

書籍中で紹介した当時とはAPIの認証画面で一部変更があります。引き続きCallback URLナシでも利用できるのでその方法を補足します。

Callback URLは「Sign in with

Twitter」(ユーザーにTwitterアカウントでログインしてもらう機能)を有効にする場合のみ必須です。APIによるツイートデータの収集という観点では「Sign

in with Twitter」は不要です。

従来のアプリページ (https://

used to Sign in with Twitter」というチェックボックスが、新しい開発者ポータル

(https://

Twitter」というチェックボックスがそれぞれのアプリのページにあるので、このチェックを外せばCallback URLは求められません。

参考: Action REQUIRED - Sign in with Twitter users must whitelist

callback URLs - Announcements - Twitter Developers

https://

P.206 コラム「JSONに対してクエリを実践するjqコマンド」で利用したAPI

APIに変更がありました。下記のURL(https://map.yahooapis.jp/...)を利用してください。

なお、Yahoo! ID連携 v2は書籍中でアプリケーションIDと呼んでいた部分がClient IDに変更されています。読み替えてご利用ください。

P.228でScrapyでコンテンツを取得できない

(2018年10月2日更新)

書籍発行時とblog.scrapinghub.comの動作が変わったため、正常に動作しなくなってしまっています。

弊社Webサイトに現在のscrapinghub.comでも動作するよう改善したサンプルファイルをアップロードしたのでこちらをご確認ください。

P.240でresponse.css()などが動作しない

(2018年10月2日更新)

書籍で使用していたトピックスの記事は掲載から時間が経って消えています。代わりにP.236(6.3.4)のScrapyShellを起動する箇所で、Yahoo!ニュースのトップページに掲載されているお好みのトピックスのURLを使用して起動してください。

|

P.192 PhantomJSの利用時の警告

(以下2018年5月8日更新)

Selenium 3.8.1以降でPhantomJSを使うと以下のWarningが表示されますが、2018-05-06時点で最新のSelenium 3.11.0でもPhantomJSは使用でき、書籍に記載のコードも問題なく動作します(ただしPhantomJSは最新版を使用して下さい)。

UserWarning: Selenium support for PhantomJS has been deprecated, please

use headless versions of Chrome or Firefox instead

なお、このWarningに従ってChromeやFirefoxのヘッドレスバージョンを使う方法は、以下の記事を参考にしてください。

SeleniumからStableになったHeadless Chrome/Firefoxを使ってみる - Qiita

https://

(以下2017年11月9日更新)

P.275 サイトの変更に伴う入力内容の変更

サイト内容の変更に伴いコードが動作しなくなりました。

tabelog.pyの38行目(addressの部分)を下記のように変更してください。

|

P.162 ファイル内容の変更に伴う入力内容の変更

jgbcm_all.csvの表記ルールの変更に伴い、下記のようにdf_jgbcmの定義を変更する必要があります。

1行目の追加内容を無視しています。

|

P.169とP.170 ファイル内容の変更に伴うリストの変更

jgbcm_all.csvの表記ルールの変更に伴い、下記のようにP.169のdf_jgbcmの定義を変更する必要があります。

1行目の追加内容を無視しています。

|

あわせて、P.170でjgbcm_all.csvを出力する個所も変更の必要があります。

|

P.43, 2.4以降のgihyo.jp/dpにアクセスする操作が動作しない

gihyo.jp側の変更によりurllibによって「https://gihyo.jp/dp」にアクセスできなくなりました。

書籍中で案内している「https://gihyo.jp/dp」のURLをすべて、サンプルサイトの「http://

|

P.168 P.169, macOS Sierraのフォント指定

macOS Sierraでは、matplotlibから使用できる.ttf形式の日本語フォントファイルがなくなってしまったため、以下の手順でMigMix 1Pフォントをインストールしてください。

- http://mix-mplus-ipa.osdn.jp/migmix/ から migmix-1p-20150712.zip をダウンロード・展開する。

- ZIPファイルに含まれているmigmix-1p-regular.ttfを~/Library/Fontsにコピーする。

- 以下のコマンドでmatplotlibのフォントのキャッシュファイルを削除する。※ P.166 脚注39のパスはLinuxのもので、macOSでは異なるので注意してください。

|

P.127, 5.1 データセットの取得と活用

P.127でダウンロードするWikipedia日本語版のデータセット(記事ページの最新版のダンプ)は定期的に更新され、一定以上古いものは削除されるため、書籍に記載のURLではダウンロードできなくなっています。

最新のダンプファイル一覧のページ (https://

2017年4月6日現在では以下のURLでダウンロード可能です。

https://

P.192, 5.6.1 JavaScriptを使ったページへの対応方法

PhantomJS 1.9.8を使用した場合、リスト5.25(P.201)とリスト5.26(P.203)のスクリプトが正常に動作しなくなっています。

最新のPhantomJS 2.1.1を使用すると改善します。

OS XではHomebrewで最新版(2016-12-06時点で2.1.1)がインストールされます。

古いバージョンを使用中の場合は`brew upgrade phantomjs`で最新版をインストールできます。

Ubuntuではインストール手順で`1.9.8`となっている箇所をすべて`2.1.1`に置き換えて実行すると2.1.1をインストールできます。

|

バージョンを確認すると2.1.1となります。

|

P.198, 5.6.2 noteのおすすめコンテンツを取得する

ページ読み込みのタイミングによっては、リスト5.24(P.198)、リスト5.25(P.201)、リスト5.26(P.203)のスクリプトが失敗することがあります。

この場合、`driver.get()`の後、

`driver.find_elements_by_css_selector()`または

`driver.execute_script()`の前に`time.sleep(2)`でスリープを入れると成功します。

P.200の解説にあるように、通常のWebページでは`driver.get()`の実行時にonloadイベントの発生時点までブロックされます。一方、noteのようにSingle Page Applicationの場合、onloadイベント以降もAjaxによる通信が継続していることがあります。このため、スリープを入れてAjaxの通信が完了するのを待ちます。

本来はAjaxの通信が完了するまで待つべきですが、そのような待ち方を指定できないので、ここでは仮に2秒としています。

|

リスト5.24(get_note_content.py)では、ファイル冒頭に`import time`も追加してください。

サンプルファイルは修正済みです。

P.228, 6.1.2 Spiderの実行

ScrapingHub社のブログの構造の変更により、リスト6.1の`myspider.py`は投稿を1件も取得できなくなっています。

ScrapyのWebサイトに掲載されているサンプルコードも変更されています。 新しいサンプルコードにコメントを追加すると以下のようになります。(サンプルファイルに`6-1/myspider_mod.py`として同梱)

|

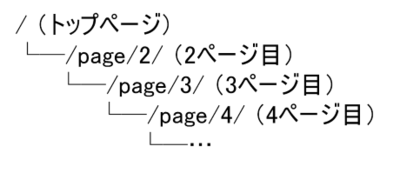

このSpiderは「一覧のみパターン」のSpiderで、まずブログのトップページから投稿のタイトルをすべて抜き出します。

続いてページ下部にある「OLDER POST」というリンクをたどって、次のページを取得します。

そこからも同様に投稿のタイトルをすべて抜き出し、さらに次のページへと再帰的に繰り返します。

後のページまでたどって「OLDER POST」というリンクがなくなったら終了です。

リンクをたどる流れを図で表すと次のようになります。

実行結果は書籍内のものと変わりません。

お詫びと訂正(正誤表)

本書の以下の部分に誤りがありました。ここに訂正するとともに、ご迷惑をおかけしたことを深くお詫び申し上げます。

(2018年5月21日最終更新)

P.80 MySQLの操作

| 誤 |

|

|---|---|

| 正 |

|

MySQL 5.6では動作していましたが、正しくないコードのためMySQL 5.7以降で動作しませんでした。

P.316のcolumn AWS利用におけるセキュリティの注意点

| 誤 | 他要素認証 |

|---|---|

| 正 | 多要素認証 |

P.50の脚注15(*15)

| 誤 | 後この例では Google Chrome の〜 |

|---|---|

| 正 | この例では Google Chrome の〜 |

P.94, メソッド名の誤記

| 誤 |

|

|---|---|

| 正 |

|

P.168 P.169, フォント指定の漏れ

リスト5.11 (P. 168) およびリスト5.12 (P. 169)でフォント指定が誤っていました。Osakaを追加するとEl Capitanで日本語が正常に表示されるようになります。

| 誤 |

|

|---|---|

| 正 |

|

目次 「A.1.2 Vagrantとは」の対応ページ(第2刷以降修正済み)

| 誤 | 362 |

|---|---|

| 正 | 361 |

P.68 表3.1「直下のテキストが"概要"というテキストであるh2要素」のXPath(第2刷以降修正済み)

| 誤 | //h2[text()="概要")] |

|---|---|

| 正 | //h2[text()="概要"] |

2つ目の「)」が不要です。

P.140 脚注番号21のURL(第2刷以降修正済み)

| 誤 | https://dev.twitter.com/overview/api/twitter-libraries |

|---|---|

| 正 |

https:// |

P.149 ソースコード中のインストールに関するコメント

| 誤 |

|

|---|---|

| 正 |

|