機械学習については、一年前に比戸氏自身が発表した「あなたの仕事に機械学習を活かす5つのポイント」の中身が良いと挙げました。ちなみに、CROSS 2014では機械学習CROSSのセッションオーナーも務めています。

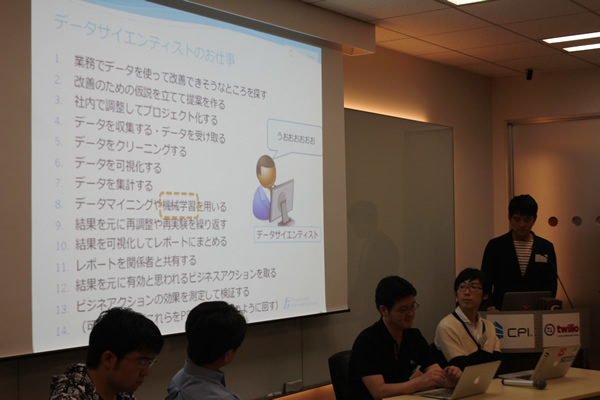

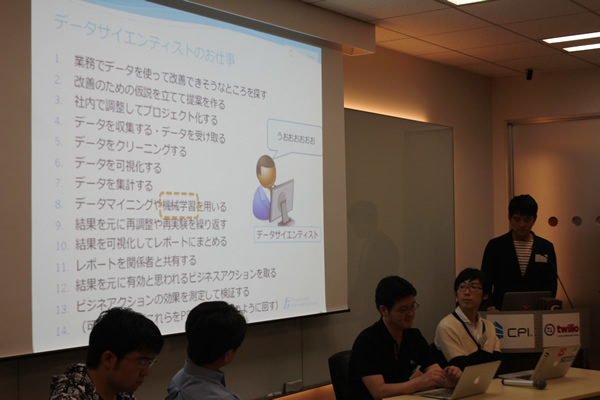

データサイエンティストについては、この言葉がよく使われ始めた2012年頃からこれまでに、三部作として次の発表を順次行ってきたと紹介しました。

比戸さんは「機械学習をデータサイエンティストが学ばなければならいというのは、最終的な解析結果の価値を高めるために重要。この流れは最近高まっている。そのような中、ようやく本書が刊行されたと理解している」と話しました。そして、「これまでネガティブすぎる神話とポジティブな神話が付きまとっていた機械学習について、本書の一番最初で、それらを打ち消して伝えたかった」と、自身が執筆した特集について紹介しました。

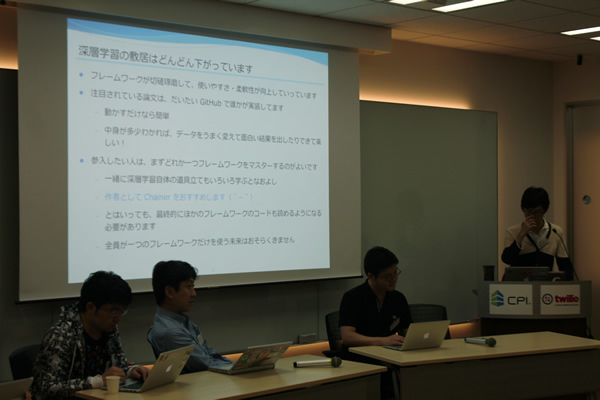

「深層学習をはじめるには」

第1部特集4「深層学習最前線」を担当した、Preferred Networksの得居誠也さんは自身が執筆した深層学習について発表しました(発表資料)。

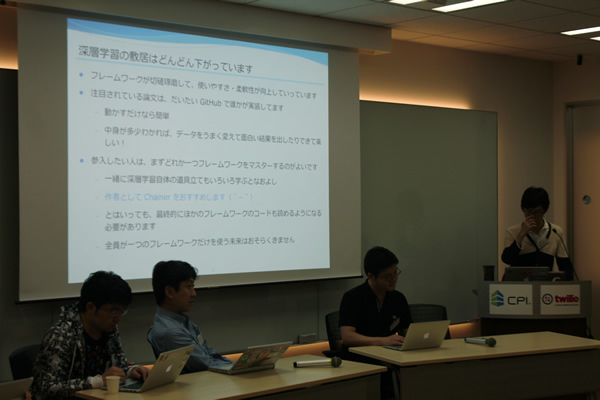

得居さんはここ2、3年ほど、深層学習に携わっていて、今年4月からは深層学習のフレームワーク「Chainer」を開発しています。フレームワークについて「Chainer以外にもいくつもあり、シェアを取り合っていて切磋琢磨している。ユーザ側から見るとどんどん使いやすくなっている段階で、始めるための敷居が下がってきている」と説明しました。

深層学習を始めたい人は、最初にどれか1つのフレームワークをきちんとマスターすることを勧めました。それと同時に、深層学習の道具立てとなる、ニューラルネットワークなどの基本的な部分を勉強していくのが良いとしました。最近は、注目されている論文が発表されると、だいたい1週間程度で誰かが実装してGitHubなどで公開しているそうです。そのため、面白い結果が出ているものは、動かすだけなら誰でもできる状況になりつつあるとのこと。

このように実装の敷居は下がりましたが、得居さんは「深層学習自体はややこしいところがいろいろある」と言います。業務などで機械学習タスクが必要になった時に、最終的に精度が良いからという理由で深層学習を使う必要はないと注意しました。例えば、データが少ない時には深層学習を行うべきではないと言及。そのため、「深層学習以外の選択肢を知るためにも機械学習全般の学習をしていたほうが良く、そういう意味で本書は良い入門になっている」と述べました。

自身が執筆した特集について「深層学習とはどういったものなのかを概観する内容になっていて、この章だけを読んでマスターするという感じではなく、始めるきっかけになれば」と説明しました。そして、岡谷先生の『深層学習』や、様々な手法を解説しているdeeplearning.netでより学んでほしいと話しました。

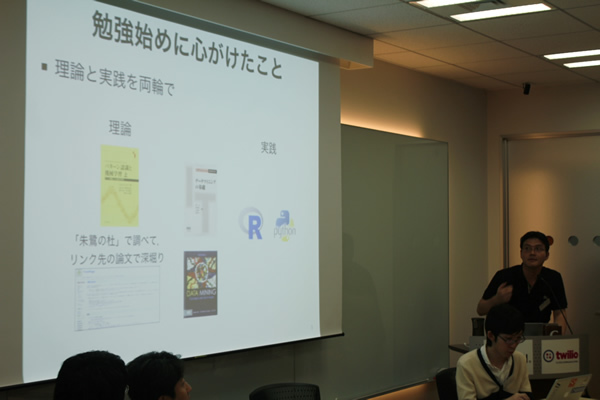

「機械学習に入門した頃の回想録」

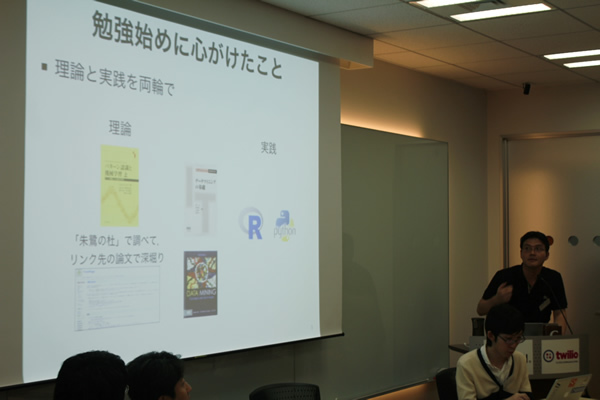

第2部特集1「機械学習ソフトウェアの概観」を担当した、トヨタIT開発センターの福島真太朗さんは記事で「ツールを使いながら理論と実践を両輪で勉強すると理解が深まる」と言及したことから、自身の機械学習との関わりを振り返りながら、どのように勉強を始めたのかについて発表しました(発表資料)。

福島さんは現在、車関係のデータマイニングをしていますが、機械学習の関わりは2009年くらいからで、その前は金融工学に関する仕事についていました。当時を「数学にはほとんどアレルギーがなかったけれども、データを分析すること、特に探索的に分析することにはあまり慣れていなかった」と振り返りました。そのため、単に理論書を読むだけとか、単に分析するだけではなく、理論と実践を両輪で組み合わせることを心がけていたと言います。

その頃は、よく産総研の神嶌先生がまとめている朱鷺の杜にたどりつくことが多かったとし、そこから論文を調べたり、レビューを見たりして知見を深めて実装したそうです。また、scikit-learnなどのツールを使って試行錯誤していくうちに、いろいろな知識が増えたり、ツールの使い方やどういうことを行えればいいのかというのが分かったとのこと。

自身が執筆した特集については「機械学習を実行するソフトウェアはどんなものがあり、それらのメリットとデメリットを伝えたかった」と話しました。また、「R、Python、Julia、Spark MLLibでの実行例を取り上げたけれども、その部分は文章だけでは分からないと思って入れたもので、筆者としてはおまけ」にあたると述べていました。

「養成読本と私」

第2部特集2「Pythonによる機械学習入門」を担当した、シルバーエッグ・テクノロジー 加藤公一さんは普段仕事で、ECサイト向けレコメンデーションサービスのアルゴリズムを開発しています。今回は本書の関わりとその思いについて発表しました(発表資料)。

今回の執筆のきっかけは、勉強会の帰りに比戸さんに声をかけられたこと。自身が担当した特集について、尾崎隆さんの本書の書評に「加藤さんのことだからてっきりフルスクラッチからごりごり書くのだと思ったら違った」というコメントがあるとおり、今回はPythonの機械学習ライブラリscikit-learnの使い方の入門を書いたと紹介しました。

ただ、scikit-learnを一生懸命押しても仕方がないと思ったそうです。また、学部2、3年生でこれから始める人のことを考えて、その前のベースとなるNumPyやSciPyの解説、可視化のグラフはどう描くかについて、きちんと説明するという道筋を立てたとのこと。特に、Matplotlibについて丁寧に説明したこと、実験データについてもscikit-learnに入っているあやめ、糖尿病を使っていると話しました。

そして、本書にかける思いを次のように語りました。「Pythonは機械学習に便利なので皆さん使います。また、機械学習自体は敷居が高くて、でも動かしてみるだけならそんなに難しくない。ただ、全体的に英語のドキュメントベースで、英語は避けて通れないのですが、最初の敷居の高さだけはちょっと下げてあげたいと思い、執筆しました。もちろん、ずっと英語を避けて通れませんが、最初に日本語の書籍があると良いことだと思います」(加藤さん)。また、機械学習をしたい人に向けてPRMLを読むことだけを勧めるのではなく、手を動かして面白いと感じてもらいながら理論をきちんとやれる環境があると良いとし、その最初の入り口を用意するというのを目指したそうです。

最後に、本書全体を通して良い入門書になっているとし、特に勤務先がレコメンドサービスの会社なので、関さんが書いたレコメンドの部分は営業の人にも勧められる内容だと話しました。

「推薦システムとはなんなのか」

第2部特集3「推薦システム入門」を担当した、Gunosyの関喜史さんは現在、仕事ではニュース配信や、流行のニュースを自動的に推定するためのロジックを実装していたり、データサイエンティスト的なことをしているそうです。今回の執筆にあたっては、推薦システムについて誤解がないように説明すること、推進システムを技術と理論の両面からその入口部分を説明することを念頭においたと話しました。

推薦システムは「ユーザが好む情報を提示するシステム」であるとよく言われますが、この表現は誤解を招くと思っているので好きではないと言います。そして、「別にユーザが好む情報を提示しているわけではなく、ユーザの好む情報が何なのかと言うのをある程度仮定して、その仮定に基づいて処理しているシステムである」と述べ、このあたりの話を始めの章で詳しく紹介したとのこと。そのため、推薦システムを導入したい会社や、推薦システムを販売している人が知っておきたいことが説明されていると紹介しました。

推薦システムに関する日本語の書籍として、『情報推薦システム入門』と『集合知プログラミング』を挙げました。ただ、この2つの書籍を読むだけでは実際の推薦システムを作れないと言います。理論がどういう目的のためにあり、それを自分の会社の目的ために合わせるためにどこを調整すれば利益になるのか。そういうことをやらないと上手くいかなものだと指摘しました。そこで本書では、その背景を重視したとのこと。

また、推薦システムのチューニングついては、理論的なもの、場当たり的なものがあると挙げ、後者が効くケースも多いと言います。ただ、この手のノウハウは世の中に出ていないのが多いと指摘。そこで最後の章で、壁にぶつかった時にどうしたら解ける可能性が高いのか、おおまかに書いたと紹介しました。

このように推薦システムは、何をしているのかを正しく把握したり、自分たちの課題に合わせて使うために上手く直したりしないと使えません。関さんは「いくつかチューニングノウハウをいくつか公開したつもりなので、推薦システムでつらい思いしている人は頑張ってほしい。また、皆さんの知見も発信してほしい」と述べていました。

最後に、関さん自身が最近考えることとして次の事柄を挙げていました。

- パーソナライズの度合い:現在は文脈とか、ジャンル以上のものを追い求めている時代になっている。

- 学術研究のビジネスにおける意義:過去のデータを再現する研究が主なものであるため、ビジネスとの兼ね合いが今後数年の課題。

- チューニングやデータの持ち方:知見を新たに発信しつつ、上手いことできるライブラリを作れたらすごい幸せになる。

阿部厳さん

第2部特集4「Pythonで画像認識にチャレンジ」を担当した、Preferred Networksの阿部厳さんは、自身が担当した特集のダイジェストを発表しました(発表資料)。ちなみに仕事では、コンピュータビジョン、画像認識の開発研究をしているそうです。

画像認識は大きく2つに分けられると言います。一つはとても単純なルールを書いて認識するもの(例えば、赤い部分が一定以上大きかったらメールすること)。もう一つは本書のテーマである、機械学習を活用してもっと高度な認識を行うというのもの。いずれにしろ、画像や映像からなんらかの必要な情報を撮り出すことを指すものだと話しました。

書籍では今回実装する画像認識アルゴリズムとして、ライブラリにNumPy、scikit-image、scikit-learnを使うため、これらの簡単な使い方を説明したとのこと。例えば、scikit-imageで画像を読み込むとNumPyの多次元配列として画像を扱えますが、その配列操作の方法などを取り上げました。

後半は実装の解説です。まずは、機械学習を使わない画像認識のアルゴリズムである、テンプレートマッチングのPythonでの実装を紹介しました。テンプレートマッチングは、画像の中から、あるパターンを見つけるという問題です。そのパターンは、状況によって見た目があまり変わらないものになるとし、例えば、印刷物中のロゴを挙げました。つまり、パターンが大きく変形しないので、シンプルなやり方が使えると説明しました。

そして、本格的な画像認識のアルゴリズムとして、画像の中から猫の顔を検出するための実装を紹介しました。猫の顔はロゴと違い、個体差も当然あるし、表情によっても全然見た目が変わってくるため、単純に画像の中から、似た場所を探すのは難しくなります。そこで、機械学習を使うと指摘しました。

最後に、画像認識の現状を紹介しました。ニュースでは、人間を超えるアルゴリズムを開発したといった威勢のいいニュースが聴こえてきますが、現状人間が簡単にできることなら、計算機にもできるというわけではないのが現状だと言います。典型的なケースでは、人間が見たら本当に簡単にわかるような問題がようやく80%できるのが現状だそうです。したがって、実際に画像認識を使うときには、認識ミスがあることを前提に利用方法を考えるのが重要だと指摘。例えば、間違えると人が死ぬケース(自動車の自動運転など)では人間による確認を挟む工夫などが必要になります。そういうケースとは異なる、売上が増える問題に使うのが今は良いと話しました。

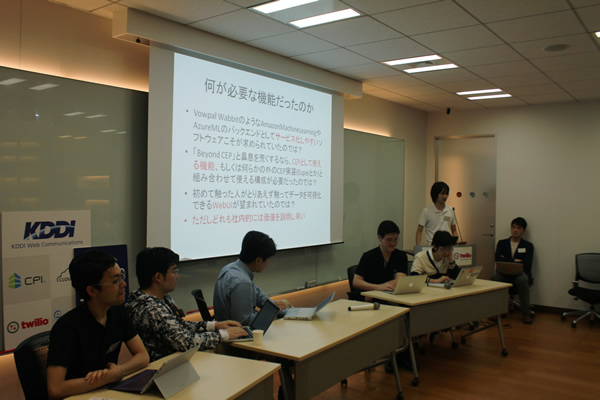

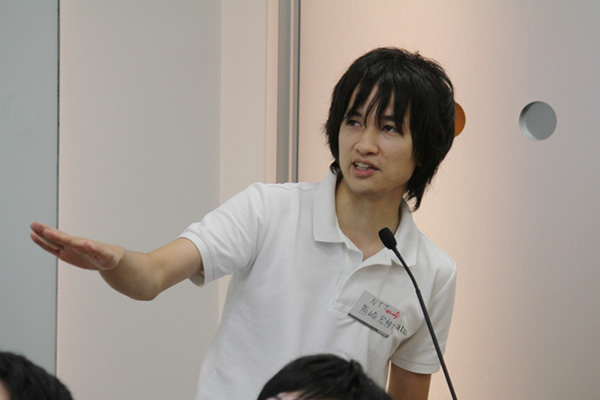

熊崎宏樹さん「Jubatusには何が足りなかったのか」

第2部特集5「Jubatusによる異常検知」を担当した、NTTソフトウェアイノベーションセンタの熊崎宏樹さんのJubatusについて発表しました。

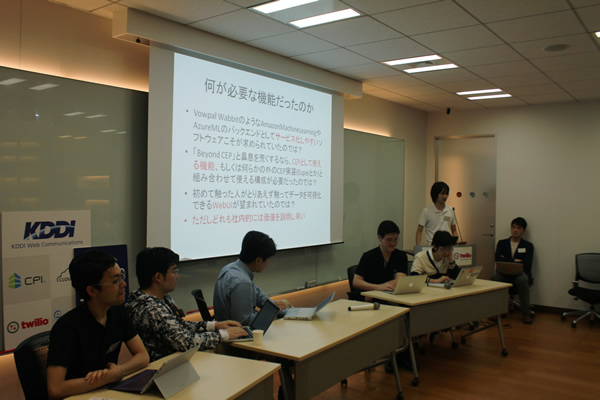

分散、オンライン、機械学習の3つの領域を同時に行うためのフレームワークJubatus。現在のJubatusについて大成功とはお世辞にも言えない原因は、最初にイノベーションを追いすぎたことにあると指摘しました。予算に見合った価値が出せるかに注目しすぎて、必要とされる機能よりも必要とされていない機能を先回ししすぎたそうです。

いま思うと、もっとサービス化しやすかったり、そもそも基本的なことができることが必要だったと言います。熊崎さんは「複雑なことしかできないというシステムはユーザから見て使いにくい。まず簡単なことからできて、そこからあれこれできるようにすること。また、試したときに注目されるものが必要だった」と述べていました。ただし、これらは価値を説明しづらいものとし、次に何か作るときにこの経験を生かしたいと語りました。

熊崎さん自身はJubatusチームでこれまで開発してきました。そして、CEP(Complex Event Processing)やバッチ処理のために、Sparkをベースにした基盤JubaQLを開発しました。その後今年4月に異動しましたが、「優秀な後輩たちが引き続き公開しているので、ぜひ使ってみてください」と述べていました。

また、Jubatusについて気になることがあれば、公式アカウント宛に投稿することで、簡単なことならフォローされるだろうとのこと。日本語のドキュメントもそれなりに整備されていることもあり、「日本語で唯一の機械学習基盤ではないか」と話していました。

パネルディスカッション

ライトニングトークの後に、著者陣によるパネルディスカッションが行われました。今回は詳しい内容に触れませんが、参加者からも質疑が出るなど、盛況のうちに本イベントの幕は閉じました。

懇親会

イベント終了後、同会場にて懇親会が催されました。著者陣も参加し、イベント参加者と交流を深めていました。また、じゃんけん大会による書籍プレゼントも行われました。