今回は、ローカルLLMの実行ツール

Alpacaとは

Ollamaに関しては第825回で紹介しました。そこではフロントエンドとして、Open WebUIを使いました。

もちろんOpen WebUIを使うのもいいのですが、Ollamaにはフロントエンドがたくさんあります。Ubuntuで動作するGUIフロントエンドはないかなと思って探してみたところ、Alpacaを発見しました

Alpacaは、Flatpakパッケージになっているので導入とアップデートが簡単で、PythonのGTK4バインディングを使用しているためUbuntuとの親和性もいいです。ただし、動作環境で注意点もあります

生成AIのフロントエンドにはプロプライエタリなライセンスのものもありますが、AlpacaはGPL-3.

動作環境

Alpacaの動作環境は、今回は次のとおりとします。

Ubuntuのバージョンは24.

理由ですが、筆者が確認したところではAlpacaはWaylandセッションでないとうまく動作しません。X.

第833回で紹介したように、24.

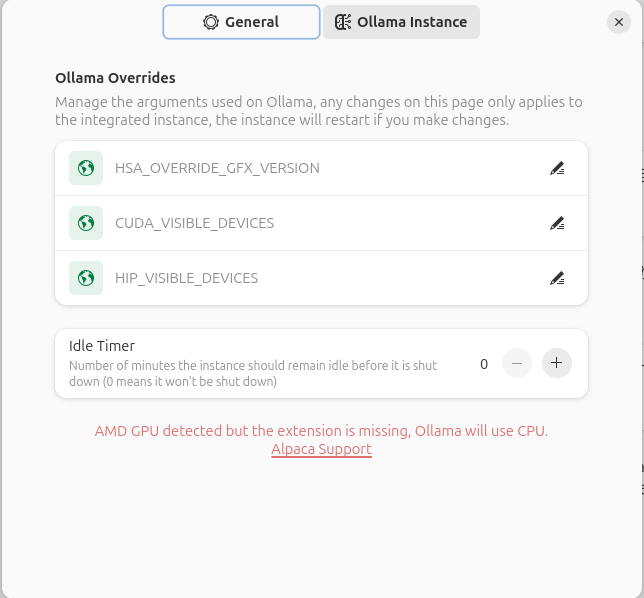

AMDのGPUを使用している場合はROCmを使用することになります。とはいえ、ROCmはもともとサポートしているGPUがごく一部で、このAlpaca

実はRadeon 6600 XTでもROCmを使用する方法はあります。それはわかっていたのですが、筆者宅にある最速のGPUがNVIDIAというのも釈然としないものを感じていたため、清水の舞台から飛び降りる思いでAMD Radeon RX 7800 XT Challenger 16GB OCを購入しました。しかしながら、執筆時点でのAlpacaの最新版である2.

なお、Intelのディスクリート

インストール

それでは、Alpacaのインストール方法を紹介します。

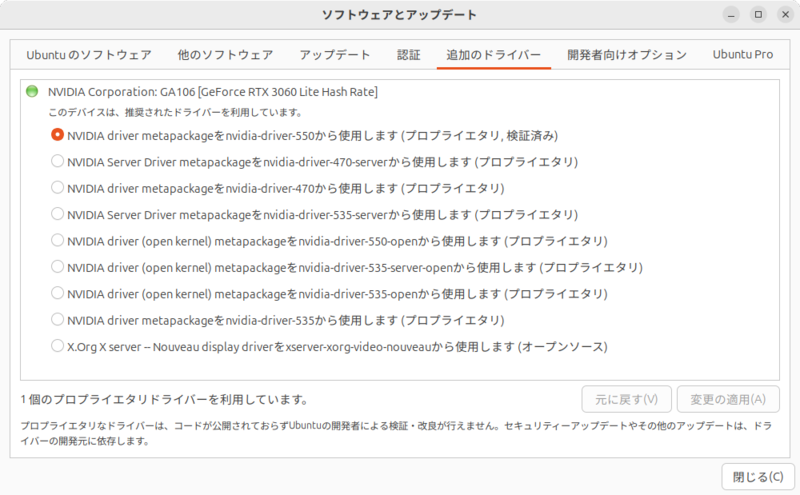

NVIDIAのGPUを使用している場合は、事前にプロプライエタリなドライバーをインストールしておきます。

あとは通常のFlatpakパッケージのインストールと同じです。ランタイムのインストールは、詳しくは第720回で紹介していますが、端的には端末から次のコマンドを実行します。

$ sudo apt install flatpak gnome-software-plugin-flatpak $ flatpak remote-add --if-not-exists flathub https://flathub.org/repo/flathub.flatpakrepo

インストールが完了したら、再起動してください。

再起動後、ログインして端末を起動し、次のコマンドを実行してAlpacaをインストールします。

$ flatpak install flathub com.jeffser.Alpaca

AMDのGPUを使用している場合は、次のコマンドも実行してROCmランタイムをインストールしてください。

$ flatpak install flathub com.jeffser.Alpaca.Plugins.AMD

動作確認

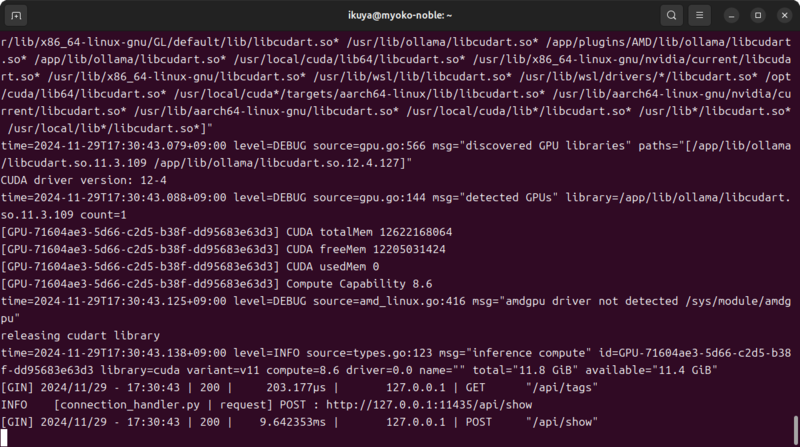

起動はもちろんアイコンから行ってもいいのですが、端末から起動するとデバッグメッセージが見られるため、こちらの方法を紹介します

$ flatpak run com.jeffser.Alpaca

このコマンドを実行すると起動します

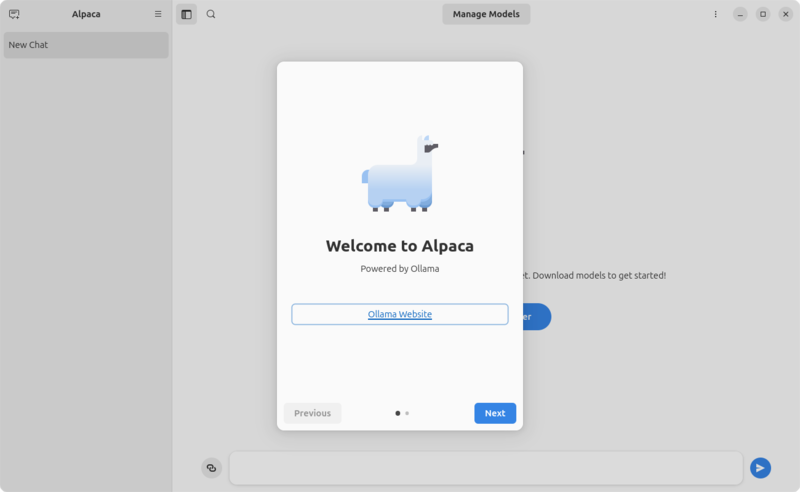

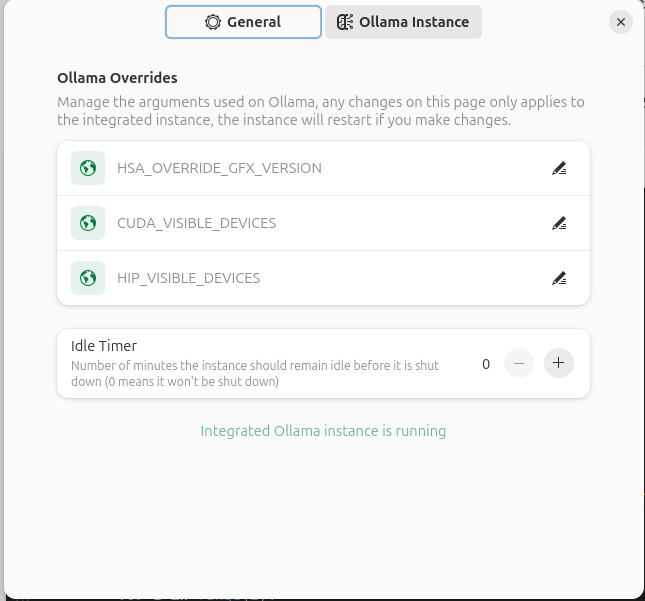

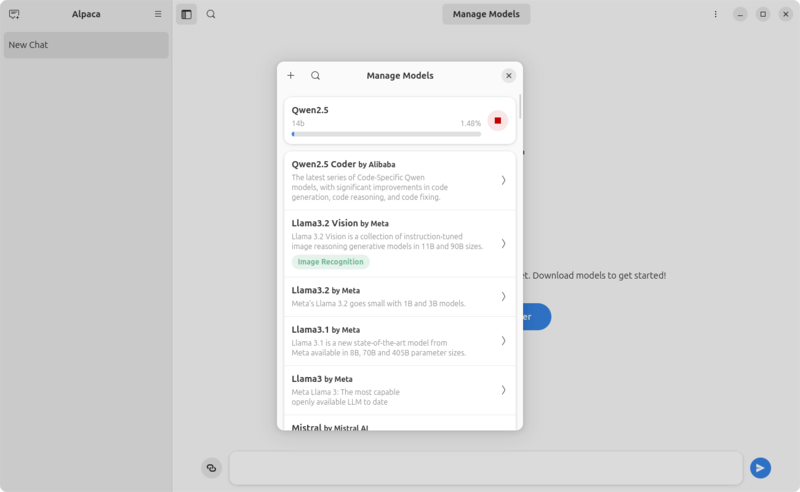

起動後、まずはハンバーガーメニューにある

前述のとおり、少なくともAlpaca 2.

使用方法

Alpacaの使用方法は、モデルをダウンロードしていろいろなことを入力し、回答を得るだけです。

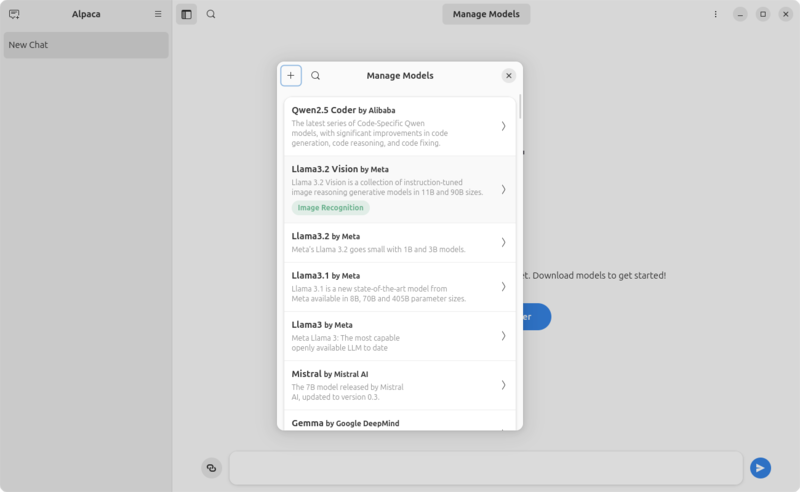

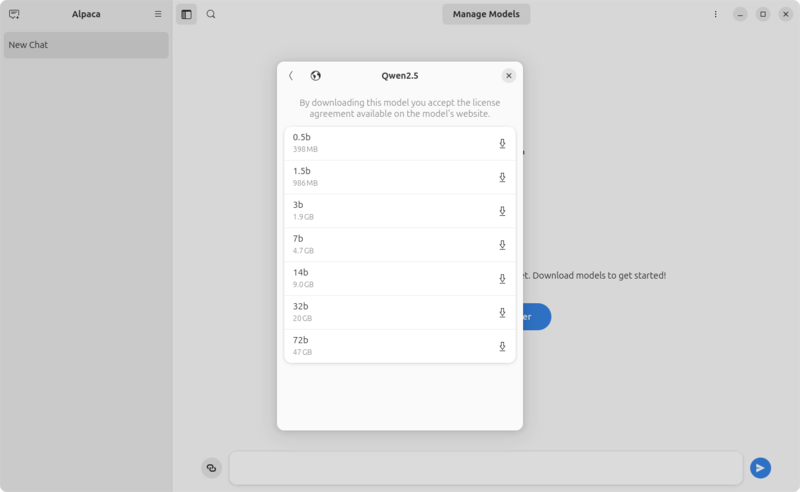

画面上部、あるいはハンバーガーメニューにある

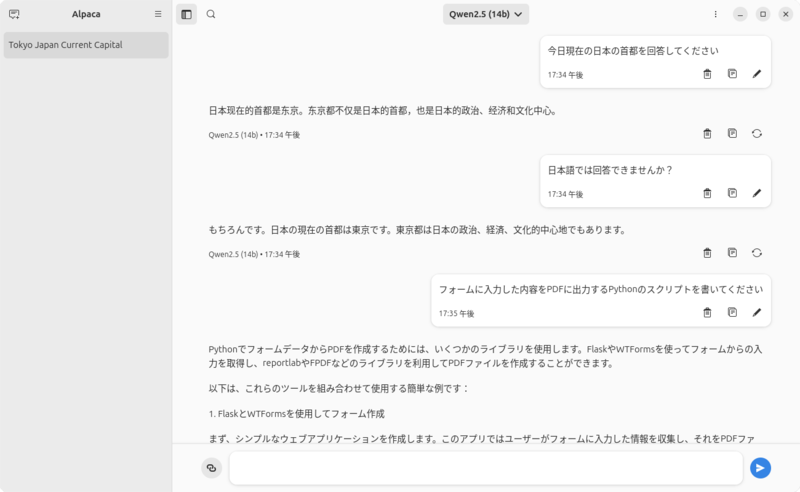

今回は筆者の個人的な好みで

というわけで

あとはじゃんじゃん質問していくだけです