NTTコミュニケーションズ(以下、NTT Com)は10月4日、環境配慮型の超省エネ型冷却環境を実現するデータセンター(コロケーション)サービス「Green Nexcenter」を発表しました。同社は従来から災害に強いセキュアなデータセンターサービス「Nexcenter」を提供してきましたが、今回発表されたGreen Nexcenterは名称に“Green”を冠していることからもわかるように、「再生可能エネルギーを活用したゼロカーボン(従来から対応)」「水冷(液冷方式)による高発熱サーバ対応」という2つの側面から環境に配慮したサービスとなっています。2024年度内に同社の横浜第1データセンターの一部リノベーションにあわせて最初の導入が予定されているほか、2025年度内に京都府にオープン予定の京阪奈データセンターはGreen Nexcenterが標準装備となることが決定しています。

液冷方式に対応したデータセンターサービス「Green Nexcenter」の提供予定。最初の展開は2024年第4四半期ごろに横浜第1データセンターの一部エリアのリノベーションに伴って導入し、首都圏のニーズにまずは応えていく。また、2025年度内にオープン予定の京都府の京阪奈データセンター(仮称)では液冷方式対応が標準装備となる

Green Nexcenterで注目されるのはなんといっても国内初となる直接液冷(Direct Liquid Cooling)方式のサーバに対応している点です。海外ではすでにHPCや生成AIの需要増とサステナビリティの観点からデータセンターに水冷(液冷/液浸)方式の設備を導入する企業が増えており、NTTグループも2023年1月にインド・ムンバイのデータセンターで水冷技術を導入することを発表しましたが、「国内の顧客に提供するコロケーションサービスとして、液冷方式のサーバに対応したのはGreen Nexcenterが初」(NTTコミュニケーションズ 執行役員 プラットフォームサービス本部 クラウド&ネットワークサービス部長 金井俊夫氏)となります。本稿ではこのGreen Nexcenterで使われている液冷方式技術を紹介するとともに、現在、データセンターに液冷技術が求められている背景についても触れていきたいと思います。

なぜ「液冷」なのか?

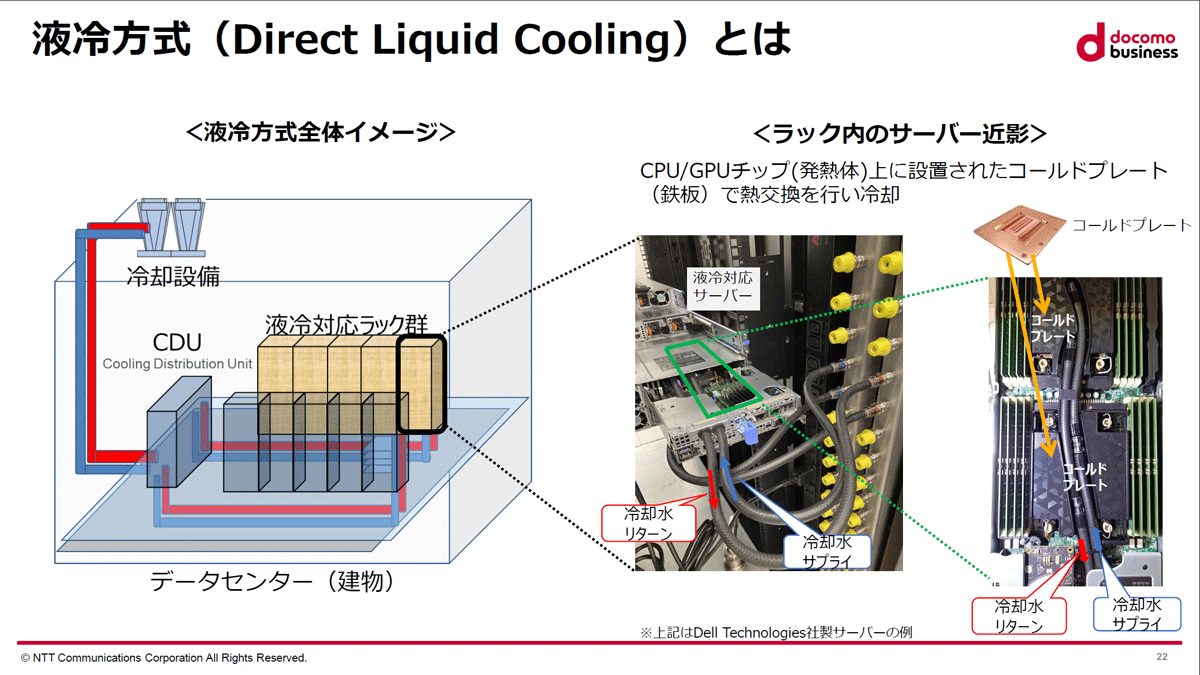

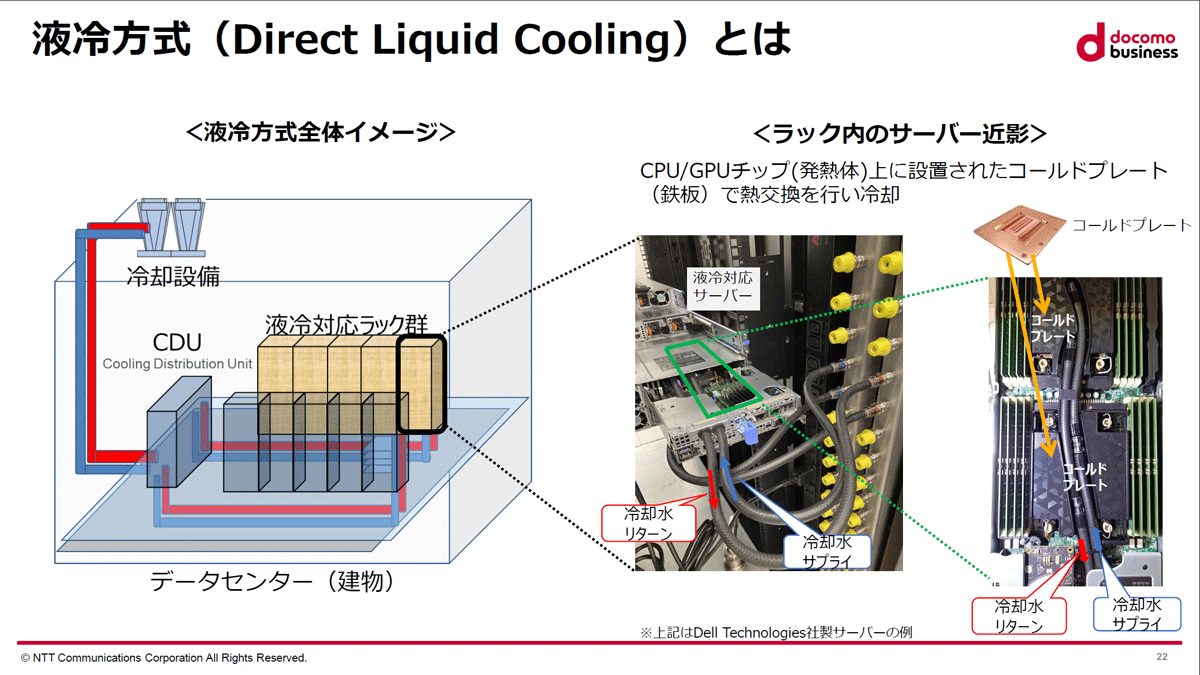

液冷技術の全体像は以下のスライドに示されている通りです。データセンターの屋上に設置された冷却設備で冷やされた液体が配管を通って建物の階下に送られます。サーバフロアに到達した冷却水はCDU(Cooling Distributon Unit:冷却水循環装置)を通って液冷対応のサーバラックに向かい、発熱体であるCPU/GPUの上に設置された金属板の「コールドプレート」でダイレクトに熱交換を行うことでサーバ機器を冷却します。発熱体と熱交換を行ったことで温まった水は今度は別の配管からCDUを経由して屋上の冷却装置に再送され、ふたたび冷却されることになります。

Green Nexcenterにおける液冷方式のイメージ。屋上の冷却装置で冷やした液体を屋内で循環させ、水資源の再利用を図っている。冷却水はコールドプレート上で発熱体とダイレクトに熱交換を行う。サーバに冷却水を送り込む部分(真ん中の黄色い部分)には液漏れを防ぐための同社の特許技術が使用されている

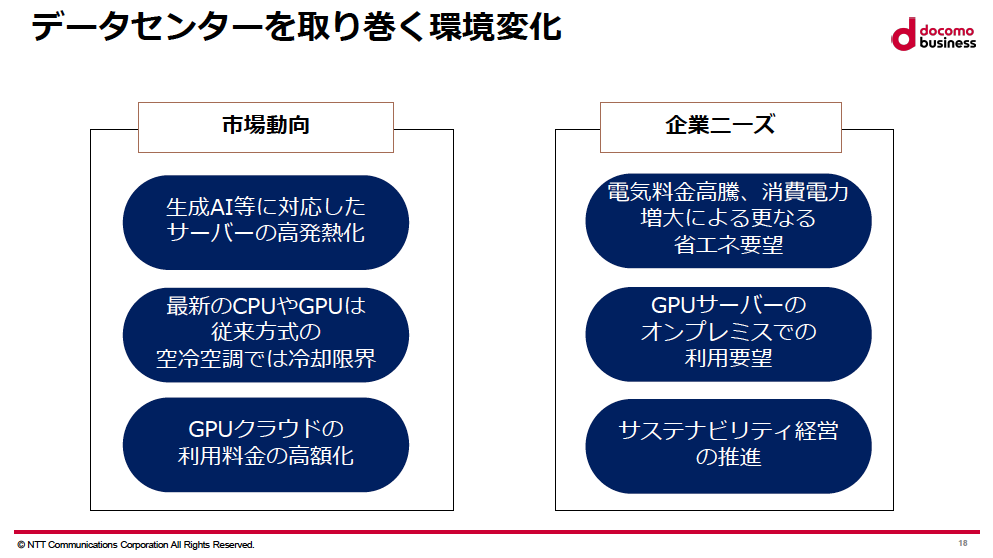

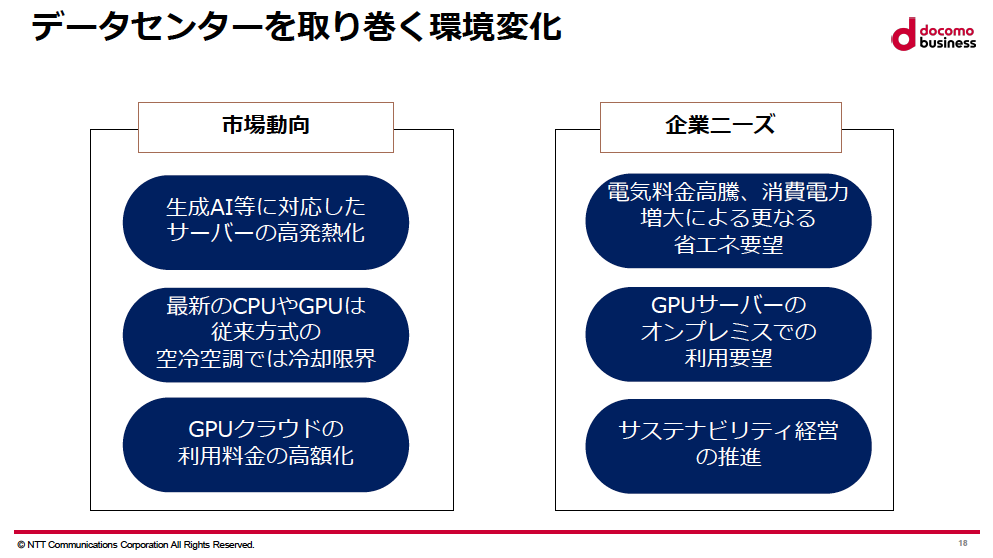

CPUやGPUの高性能化とともにデータセンターの"超高発熱化"と消費電力量の増大は、生成AIの急激な普及とともに以前にまして深刻な問題となっており、一般的な空冷方式では限界に近づいているといわれています。「高発熱のGPUサーバを空冷で冷却するために、2台のサーバに対して2、3ラックを使って無理やり冷やすこともあり、(空冷は)まったく非効率で持続性がないことは明らか。GPUの新製品が出ても、それを格納できるデータセンターが圧倒的に少ない。空冷ではもう、データセンターはもたない」(金井氏)

現在のデータセンターを取り巻く市場動向と企業ニーズの変化。生成AIの普及はIT業界のあり方を一変させたが、データセンター市場にも劇的な変化をもたらした。なかでも生成AIに欠かせない高性能GPUのニーズは非常に高く、データセンターの超発熱化の大きな要因となっている

こうした現状に対し、NTT Comが今回出した顧客向けの回答が直接液冷方式のGreen Nexcenterです。データセンター向けの水冷技術としては液冷のほかに、サーバ機器を直接タンク内の冷却液に浸す液浸や、ラック背面のドア内で冷却水を循環させてファンからの排熱を冷却し、冷えた空気をサーバに送り込むリアドア型などがあり、NTT Comも長年に渡ってこれらの技術の実証実験を重ねています。しかし、これらの技術は既存のラックにそのまま適用しにくく、加えて以下のような課題がありました。

- 液浸 … 冷却性能は非常に高く、消費電力の大幅な削減が可能だが、メンテナンス時に複数の作業員がタンクからサーバを引き上げる必要があり、運用の負荷が大きい

- リアドア型 … 液浸や液冷に比べて冷却性能が低く、送風の音が大きい(運用担当者の作業効率を下げる)

一方、液冷方式は冷却性能は液浸に比べて若干劣るものの「ほとんど引けを取らないレベル」(金井氏)であり、音も静かで、ラックごと冷やせるという特徴を備えています。もちろん、同社では液浸やリアドア型の検証も引き続き進めており、これらの課題も近い将来には解決に向かうと見られますが、現時点では既存のインフラをそのまま利用できる直接液冷方式がもっとも現実的な選択肢だったといえます。また、DellやHPE、Gigabyteなどメジャーなサーバベンダがすでに液冷方式対応のサーバ機器の販売を開始しており、一般企業にとって導入しやすいという点も大きなアドバンテージのひとつでしょう。

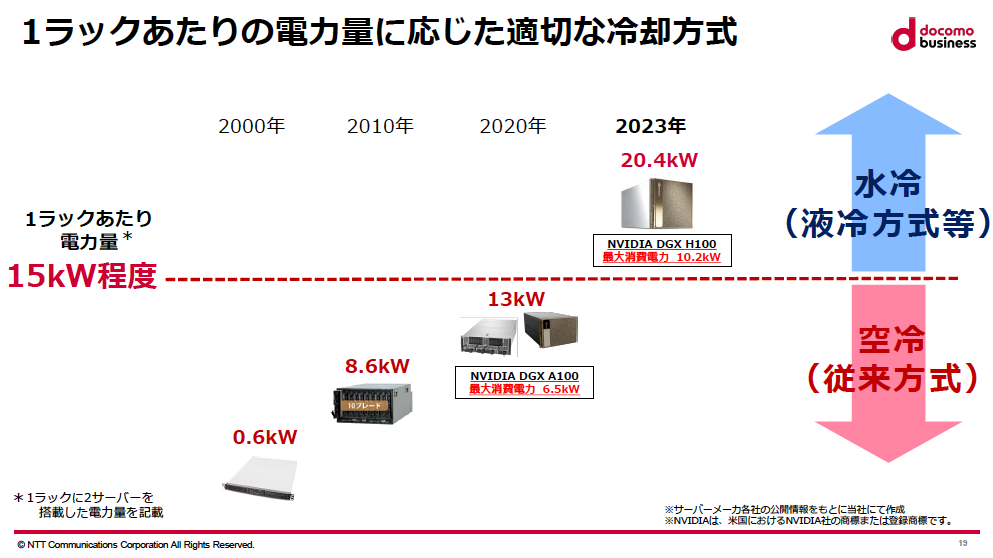

液冷方式の採用はほかにもいくつかのメリットをデータセンターにもたらします。Green Nexcenterは1ラックあたり最大80kWの電力消費をサポートするので、最新のCPU/GPUを搭載した高発熱サーバにも十分に対応することが可能です。空冷データセンターの場合、ラックあたりの電力量は15kW前後であることが多いのですが、最大80kWの液冷方式であれば、より少ないスペースで強力なシステムを構築できることになります。さらに液冷方式ではサーバを冷却する際に空気よりも熱伝導率の高い液体を使用するため、効率的な冷却を実現しやすくなります。Green Nexcenterの場合、提供ルーム単位の電力使用効率はpPUE1.15[1]で、従来型データセンターに比べて冷却用の消費電力を30%削減できるとみられています(NTT Comの空冷方式の最新データセンターのpPUE実績値は1.35)。

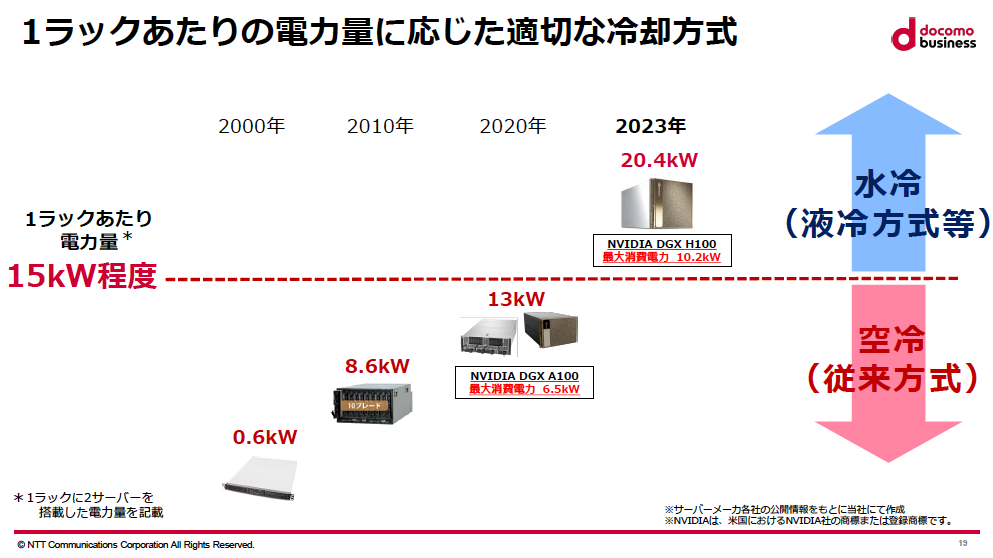

一般的な空冷方式のデータセンターの場合、2サーバ/1ラックあたりの電力量は15kW程度といわれる。一方、最先端GPUサーバ「NVIDI DGX H100」の1ラックあたりの電力量は20.4kWとなるため、空冷ではほぼ限界であり、水冷技術を備えたデータセンターの需要が高まっている

もうひとつ、Green Nexcenterの”Green”をあらわす特徴として欠かせないのが環境への配慮です。Green Nexcenterでは顧客の要望に応じて100%実質再生可能ネルギーを利用できるので、顧客企業のカーボンニュートラル達成に貢献することも可能となります。また、冷却水を循環させて繰り返し利用する方式は水資源の節約に関しても空冷よりすぐれているといえます。

“データセンターはもう空冷ではもたない”

前述したように、HPCや生成AIに対する需要の急速な高まりから、高性能なCPU/GPUを搭載したサーバ機器は品薄状態が続いています。また、最近は世界的な大企業の多くがオンプレミスの環境で自前のLLM(大規模言語モデル)を構築する動きが活発化していることから、「NVIDIA H100 Tensor Core GPU」のような生成AI向けの高性能GPUの人気は非常に高く、出荷まで1年待ちというケースもめずらしくありません。そしてこれらのHPC/生成AI向けの高性能サーバは当然ながら消費電力量も多く、H100を搭載した機器であれば10kwを超えてしまうため、「1ラックに2台搭載した場合、ラックあたり15kWの空冷ではもたない」(金井氏)ことになり、空冷方式のデータセンターでは明らかに限界に近づいています。

こうした市場のニーズに応じて今回登場した直接液冷方式のGreen Nexcenterは、顧客企業にとって非常に現実的なソリューションだといえます。消費電力量やスペースの削減、環境への配慮など、モダンなデータセンターに欠かせない要素を抑えつつ、データセンターを適切なコストで確実に冷やす現実解として、2024年度の横浜第1データセンターでの展開開始が期待されます。

NTTコミュニケーションズ 執行役員 プラットフォームサービス本部 クラウド&ネットワークサービス部長 金井俊夫氏(NTTコミュニケーションズ株式会社提供)