Microsoftは2024年4月23日、高機能でコスト効率の高い小型言語モデル

「Phi-3-mini」

Phi-3モデルは、主要なベンチマークにおいて、同じパラメータサイズおよびより大きなサイズの言語モデルよりも大幅に優れたパフォーマンスをもつという。同社のテストによると、Phi-3-miniはその2倍のサイズのモデルよりも優れたパフォーマンスを発揮し、Phi-3-smallとPhi-3-mediumはGPT-3.

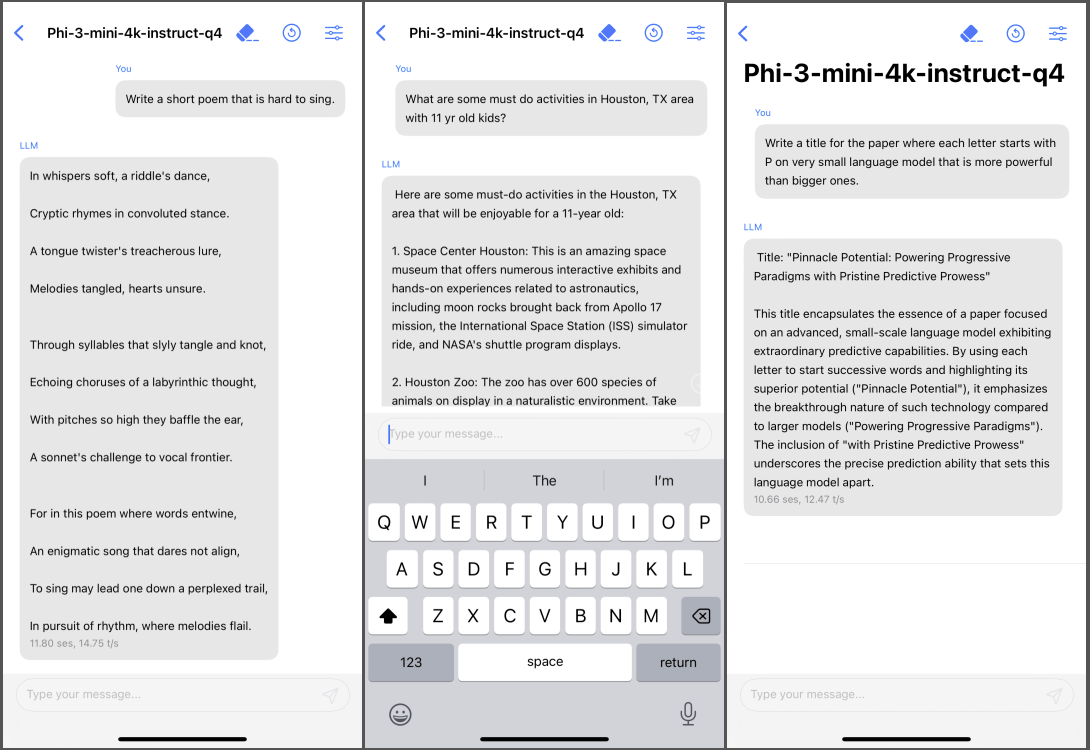

スマートフォンでローカルに実行できるPhi-3-mini

4月22日に発表された論文によると、Phi-3-miniは携帯電話上でローカルに実行可能で、サイズが小さいため4ビットに量子化でき、占有するメモリは1.

なおPhi-3モデルはより大きなモデルと同様のレベルの言語理解と推論能力をもつが、モデルサイズが小さくなると事実を保持する容量が少なくなるため、たとえばTriviaQAなどではパフォーマンスが低くなってしまう。しかしこのような弱点は検索エンジンを活用することで解決できるという。もう1つの弱点は、言語を主に英語に制限している点である。小規模言語モデルの多言語機能の実現を図るのは次のステップで検討するとのこと。