1993年の創業以来、つねにオープンソースウェイの先頭に立ち続け、最先端テクノロジとオープンソースの融合を図ってきたRed Hat。同社は現在、世界中の企業にとって重要なイノベーションドライバであるAIとハイブリッドクラウドという技術を、民主的かつ透明性をもって提供していくことにフォーカスしています。

日進月歩で進化するテクノロジの世界のなかでもとくに驚異的なスピードで変わっていくAI/ハイブリッドクラウドという分野で、いかにしてオープンソースウェイの真価を発揮していくのか? ―本稿では10月中旬に都内で開催されたレッドハット主催のテクノロジカンファレンス

技術だけではなく、Red Hatがオープンソース活動で培ったコミュニティ運営のノウハウを活かす

- ――今回の来日はカンファレンスへの登壇のほか、多くの日本の顧客やパートナーと直接話をすることも重要な目的だとうかがっています。久しぶりに日本を訪れてどんな印象をもたれましたか。

-

CW:Red Hatはこれまでも日本の顧客やパートナーと非常に良い関係を築いてきましたが、今回はあらためて日本企業のイノベーションに対する熱意を強く感じました。先日のカンファレンス

(Red Hat Summit: Connect Tokyo) でも非常にエナジーにあふれれていて、新しい技術を積極的に取り入れようとする姿勢に感銘を受けました。 -

エッジコンピューティングからデータセンターまでをカバーする我々にとって、主要な産業に多くの顧客が存在する日本はつねに非常に重要な市場です。通信、金融、リテール、製造などどの業界においてもこれまで大きな成果を出してきました。最近はとくに通信の分野において日本企業との提携が進んでいます。Red HatはNTTが主導する次世代ネットワーク基盤構想

「IOWN (Innovative Optical and Wireless Network)」を推進する 「IOWNグローバルフォーラム」 のメンバーでもあるのですが[1]、今回の来日の前には台湾でIOWNグローバルフォーラムのカンファレンスが開催され、多くの日本企業とともに私も参加してきました。20年、30年先を見据えた技術ですが、アーキテクチャとして非常に興味深く、また、いま実現できるユースケースにもフォーカスしており、Red Hatとしてもより良い世界を作るために参加企業と協力していきたいと考えています。

- ――先日

(10/ 16)、ライトさんは報道関係者向けに行われた説明会で、Red HatがIOWNに参加する意義として 「次世代ネットワーク基盤のソフトウェアスタックをオープンソースで提供できること」 を挙げていました。とくに今後、劇的に増大すると思われるAIワークロードやエッジコンピューティングのユースケースにおいて、オープンソースソフトウェアで超高速/大容量転送を実現するオールフォトニクスネットワーク (APN) が構築できれば、IOWNの普及に大きなはずみがつくことも考えられます。 - CW:オープンソースのプロダクトをAPNの基盤として採用できるというメリットはもちろんありますが、それだけではありません。IOWNのように世界中の企業が集まる巨大プロジェクトを成功させるには、すべての参加企業がコラボレーションのための努力を継続していくことが不可欠です。技術的な支援だけでなく、我々がオープンソース活動で培ったグローバルなコミュニティ運営のノウハウを活かすことができれば、Red Hatが参加する意義は非常に大きなものとなります。

“オープンソースAI”という言葉の定義のハードルを上げていきたい

- ――今回のカンファレンスでは

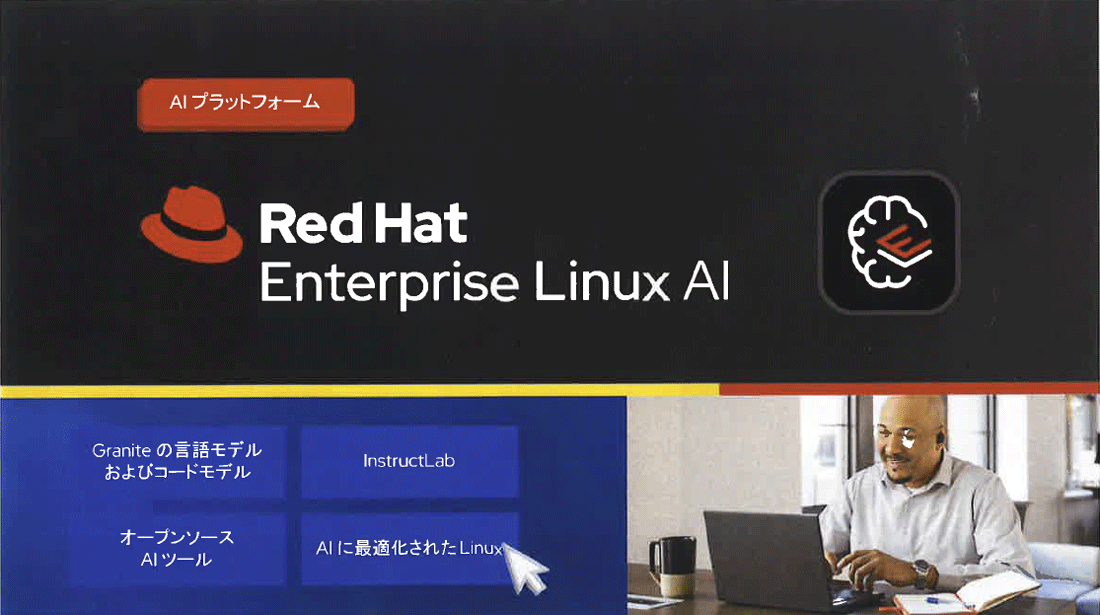

「AI」 と 「オープンハイブリッドクラウド」 が大きなテーマとして掲げられていましたが、これらは現在のIT業界におけるホットトピックでもあり、同時にRed Hatがここ数年、もっとも注力してきた分野でもあります。それぞれの事業の現状についてお聞きしたいのですが、まずはAIに関して、10月16日付けで発表された 「Red Hat Enterprise Linux (RHEL) AI 1. 2」 について説明をお願いできるでしょうか。 -

CW:RHEL AIのコンセプトが最初に登場したのは2024年3月で、このときは論文として提出されました。その2カ月後の5月に行われた

「Red Hat Summit 2024」 で開発者プレビューが発表され、9月に一般提供開始、そして今回のバージョン1. 2のアップデートという非常に速いスピードで開発が進んでいるのがおわかりかと思います。これはAIという技術の進化が非常に速いため、RHEL AIの開発もそのスピードにあわせているからです。 -

RHEL AIは名前の通り、長年ミッションクリティカルなワークロードで使われてきたRHELをAIワークロードに最適化させたプラットフォームで、ユーザはRHEL AIを自社のサーバ上にデプロイし、その上でLLMモデル開発をプライベートに行うことが可能となります。5月に開発者プレビューを公開したとき、Red HatはIBMと共同で大規模言語モデル

「Granite」 のオープンソース化 (Apache 2. 0ライセンス) と、LLMの開発 (カスタマイズ/チューニング) をオープンソースアプローチで実現するプロジェクト 「InstructLab」 についてもアナウンスを行いましたが、RHEL AIは起動イメージに加え、Graniteモデル、InstructLabツール、各種トレーニングデータ、そしてRed Hatによるサポートを含んでいます。 -

バージョン 1.

2ではさらにいくつかの重要なアップデートが行われており、そのひとつがLenovoとのパートナーシップによるNVIDIA GPU搭載サーバ 「Lenovo ThinkSystem SR675 V3」 のサポートです。サーバ出荷時にRHEL AIのビルトインを選択できるようになったので、ユーザはAIプラットフォームの導入をより迅速に行うことが可能になりました。また、テクノロジプレビューの段階ですがAMDの新しいGPUアクセラレータ 「AMD Instinct」 のサポートも開始しています。AIワークロード、とくにLLMの開発には強力なコンピューティングリソースが求められますが、ハードウェアベースでAIソリューションが拡大することは顧客にとっても非常にエキサイティングで喜ばしいことです。

- ――RHEL AIはGraniteおよびInstructLabという、Red HatとIBMならではのオープンソースアプローチをベースにしたAIプラットフォームとして非常にユニークな存在だと思います。あらためておうかがいしたいのですが、Metaの

「Llama」 やMistral AIの 「Mistral」 といった、いわゆる “オープンソースLLM” を掲げているモデルと、オープンソースベンダであるRed Hatが提供するGranite/ InstructLabの違いはどこにあるのでしょうか。 -

CW:オープンソースとLLMの関係性はすこし複雑で、説明が難しいところはありますが、我々Red HatがIBMとともに目指している

「オープンなAI」 とはAIプラットフォームのすべてのレイヤをオープンソースで構成し、提供することです。Graniteはライセンスや配布形式がオープンであることはもちろん、学習データセットもすべてオープンにしています。 -

一般に

“オープンソースLLM” といった場合、それがどこまでの範囲を示しているかはあまり明らかになっていないようです。たとえばLlamaの場合、モデル自体は公開されており、誰でも無料でコードにアクセスできますが、ライセンスや利用条件に関してさまざまな制限が課せられており、学習データの透明性も担保されていません。MistralはライセンスにApache 2. 0を適用していますが、やはり学習データセットは明らかになっていない。また、これらのLLM本体の開発は単独の企業によるものであり、Granite/ InstructLabがトラディショナルなオープンソースプロジェクトと同様に行っているコミュニティドリブンの開発手法とは大きく異なります。 -

一方でほとんどのLLMは、PyTorchやvLLMといったオープンソースライブラリを使って開発され、さらにそれらのライブラリはKubernetesやLinuxといったオープンソースの基盤の上で動きます。つまりLLMを構成するソフトウェアスタックのうち、下部レイヤはすでにオープンソース化が完了しているといえるでしょう。そして我々はさらにその上のレイヤも完全にオープンソースで提供したいと考えています。もう少し抽象的に表現すると

“オープンソースAI” という言葉の定義のハードルを上げていきたい。RHEL AIやGranite、InstructLabはそのためのプロダクトでありプロジェクトです。もちろん、完全なオープンソースLLMの実現は簡単なことではありませんが、我々の取り組みに共感してくれるパートナーが増えてくれることを期待しています。 - ――生成AIに対しては少なくない数のクリエーターが

「コンテンツを勝手に学習データに使われた」 と抗議の声を上げていますが、オープンソースLLMをめざす企業が増えることで学習データの透明化が担保されるようになれば、そうした確執も減っていくのではと期待しています。 -

CW:AIを普及させるためにはプラットフォーム側が

「信頼性の高いモデルを構築する」 という姿勢を見せ続けていくことが重要です。学習データの透明化を図ることは信頼性の高いモデルを構築するうえで非常に有効です。オリジナルコンテンツを制作するクリエーターにとっても安心材料となるはずです。これは私の願望ですが、誰もが自由にモデルをトレーニングでき、モデルの見える化を行えるようなパブリックな空間があるといいなと考えることがあります。そうした場所があることで"信頼性の高いモデル"とはどういうものか、どう作り上げていくべきか、といった考察も深まっていくように思います。

- ――AIの世界では現在、エージェントAIというトレンドに注目が集まっています。すでにSalesforceやMicrosoftなどのビッグベンダがエージェントAIに関連したプロダクトを発表していますが、Red Hatはこのトレンドをどう見ていますか。

-

CW:エージェントAIについては非常に興味深く、重要なトレンドとして注目しています。InstructLabではすでにモデルチューニングなどにおいてエージェントを活用するワークフローを実装しており、他社よりもはやく取り組みを開始してきました。現在はInstractLabを開発するIBM Researchと共同でエージェントAIベースのフレームワーク開発に取り組んでおり、安定した段階でエンタープライズ向けのプロダクト

(あるいは機能の一部) として提供できるよう準備中です。モデルを作成/管理するように、エージェントを扱うことも容易になるでしょう。 - ――モデルと同様にエージェントの作成ができるようになると、次はそのライフサイクル管理

(LCM) が課題になってくると思われます。そのための解決策としてRed Hatは何を用意しているのでしょうか。モデルのLCMと同様のことが可能なのでしょうか。 -

CW:エージェントのLCMについて言及するのはまだ時期尚早だと思いますが、モデルのLCMで確立した手法はひとつの目安となるかもしれません。

-

私は

「アプリケーションの数だけモデルがある」 ことを良しとしています。企業にはたくさんのアプリケーションがあり、すべてのアプリをカバーできるモデルは存在しません。モデルの数が多くなると管理が難しくなるのではという意見もありますが、Red Hatはそのための製品として 「Red Hat OpenShift AI」 を提供しています。OpenShift AIではMLOpsにおけるモデルの開発/デプロイ/管理という流れを確立しており、モデルを本番環境に展開したあとの再トレーニングについても管理できます。これはハードウェアの選択肢が多様で、LLM以外のモデルも管理でき、KubernetesベースでスケールしやすいOpenShiftを基盤にしているからこそ可能なのです。 - ――エージェントAIが普及して、モデルと同じようにエージェントの管理が求められるようになったとき、OpenShift AIにその機能があると良さそうですね。

-

CW:そうですね、そういう可能性も考えられると思います。

AIもハイブリッドクラウドも、オープンソースをベースにすればさまざまな選択肢を提供できる

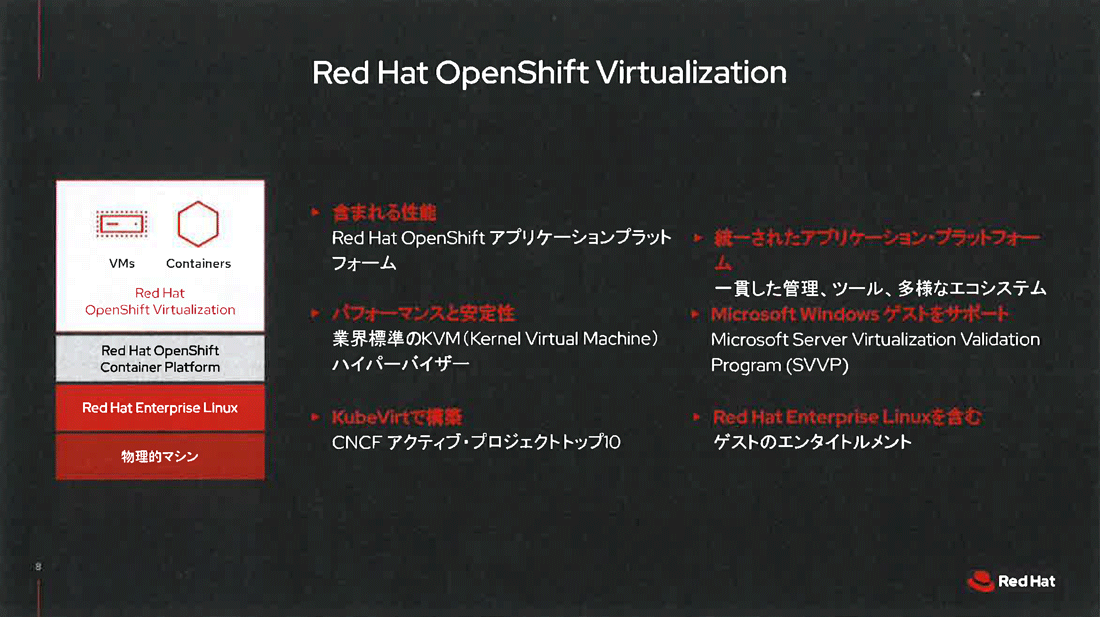

- ――AIプラットフォームとしてのOpenShift AIの成功は、先ほど言われていたようにインフラ基盤としてOpenShiftをベースにしていたことが大きいと思います。OpenShiftはここ数年、ハイブリッドクラウドのプラットフォームとして飛躍的な成長を遂げていますが、2023年11月のBroadcomによるVMware買収完了もあり、OpenShiftをVMware環境からの移行先として検討するユーザも増えていると思われますが、そうしたユーザに対し、Red Hatはどのようなソリューションを提供したいと考えていますか。

-

CW:VMwareのサポート体制の変更以来、仮想化環境のオルタナティブを検討し始めたユーザはたしかに増えています。BroadcomによるVMwareライセンスやOEM供給の変更、不明瞭なロードマップなど、ユーザが不安を覚えるのも無理はないでしょう。そうしたユーザがRed Hatに相談にきたとき、我々として提示できる最初の選択肢は

「Red Hat OpenShift Virtualization」 になります。OpenShift Virtualizationは8年前 (2016年) からRed Hatが主導してきたオープンソースプロジェクト 「KubeVirt」 をベースにしており、ハイパーバイザのKVMとともにすでに多くの企業に導入されている、成熟したオープンソースプロダクトです。 -

VMwareのユーザの多くはレガシーアプリケーションのモダナイゼーションを望んでいます。オープンソースプロダクトとして信頼性があり、かつクラウドネイティブなKubernetes環境で多種多様なワークロードを動かすことができるOpenShift Virtualizationへの移行はインフラをモダナイズする最大のチャンスだとお伝えしています。

- ――しかしVMwareとOpenShift Virtualizationはベースのハイパーバイザが異なることから、移行が難しいケースも多いのではないでしょうか。

-

CW:インフラ基盤の移行が難しいというのはそのとおりですが、単に仮想マシンの移行だけならそれほど難しくはありません。いまエンタープライズで問題になっているのは長い歴史のあるデータセンターをいかにモダナイズするかということで、コンポーネント単体の移行ではありません。仮想マシンだけでなくストレージやネットワークに関しても同様です。だからこそインフラの移行は熟慮した計画のもとで、顧客の環境の全体像をつかんだうえで行わなくてはなりません。

-

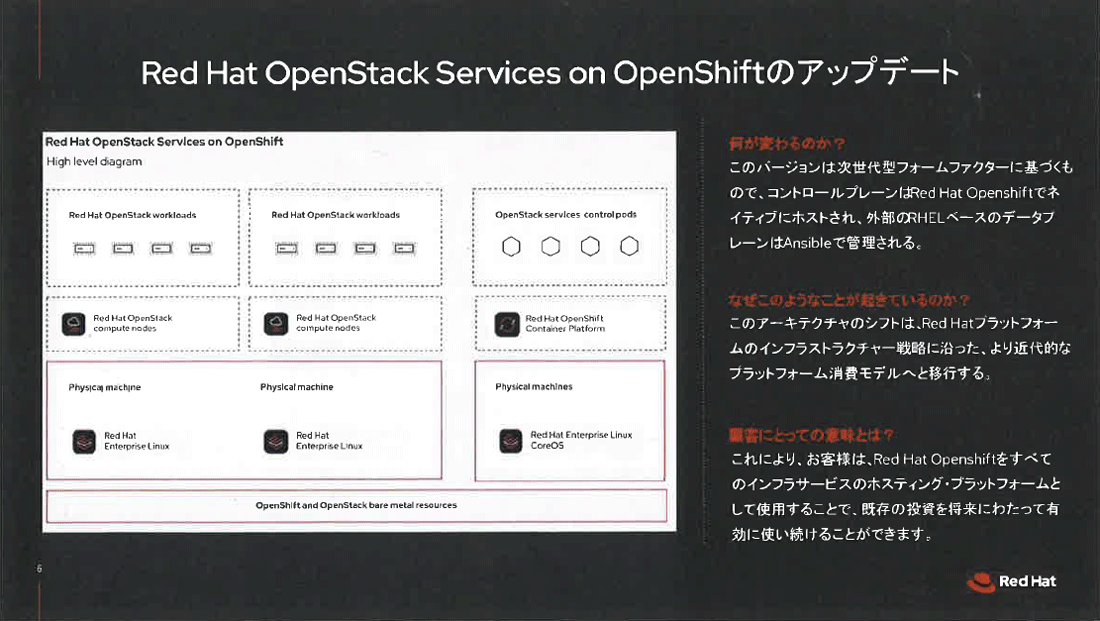

そうした意味でいうと、8月に一般提供開始となった

「OpenStack Services on OpenShift」 は単一のOpenShiftプラットフォーム上でレガシー環境とクラウドネイティブ環境の両方をホスティングできることから、既存の投資を活かしつつモダナイゼーションを進めたい顧客にとって良い選択肢となるといえます。 -

ハイブリッドクラウドプラットフォーマーとしての我々の強みは、レガシーとモダンインフラを信頼できるオープンソースプロダクトの上で融合できることです。既存のインフラと未来のインフラ、2つの方向性を同時に見据えながらオープンソースで融合していく ―ハイブリッドクラウドでもAIでも、オープンソースをベースにすることで顧客にさまざまな選択肢を提供するというアプローチはこれからも変わりません。

コーディングを続けているだけでは為しえなかったこと

- ――ライトさんは長い期間に渡ってRed HatのCTOを務めていますが、20年ほど前はひとりの開発者としてLinuxカーネル開発などにも参加していたと聞いています。変化の激しいIT業界にあって、ご自身の変化に関してはどう思いますか。

- CW:20年前、30年前の自分に

「将来、Red HatのCTOになる」 といってもたぶん信じないでしょうね (笑) 当時の私はコードを書くことが本当に好きで、 「コーディングだけやっていたい、人の管理とか、ビジネスにかかわるとかはしたくない」 と思っていましたが、今はそれがはっきりと間違いだったことがわかります。これまでRed Hatでさまざまなチャレンジに向き合ってきましたが、その過程で自分自身も変わってきたと思っています。 - ――生粋の開発者がRed Hatという大きな組織のリーダーとなられたわけですが、テクノロジカンパニーのリーダーのビジョンとして大切にしていることはありますか。

- CW:そうですね、大きく3つあると思います。ひとつはどんなときでも学ぶことをやめないこと。新しい技術も含め、自分が興味あることをつねに学び続けていく姿勢を保つようにしています。2つめは顧客への興味を持ち続けること。これは実は20年前から変わっていなくて、パーフェクトなコードを書くだけでなく、顧客の課題を解決するために自分ができることをつねに考えるていました。3つめはオープンソースコミュニティへの参加です。オープンソースコミュニティとは上下関係ではなく、メンバーがお互いにどう影響を与えていくのか、そこが重要になります。インフルエンスをコアにして自分自身を含めたコミュニティ全体を成長させていく、それは上意下達だけのリーダーシップでは決して得られないことだったと思います。少なくとも20年前の自分には理解できていませんでしたね。

(笑)