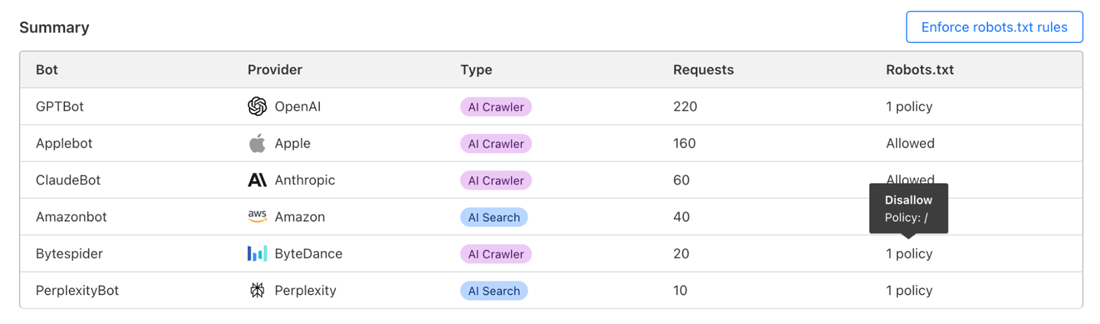

Cloudflareは2024年12月10日、ユーザのサイトを訪れるAI企業やサービスによるボット、クローラーのアクセス状況を監視し、アクセスの制御を行うサービス

Today, the AI Audit dashboard gets an upgrade: you can now quickly see which AI services are honoring your robots.

— Cloudflare (@Cloudflare) December 10, 2024txt policies. https:// t. co/ fHo44D4XA1

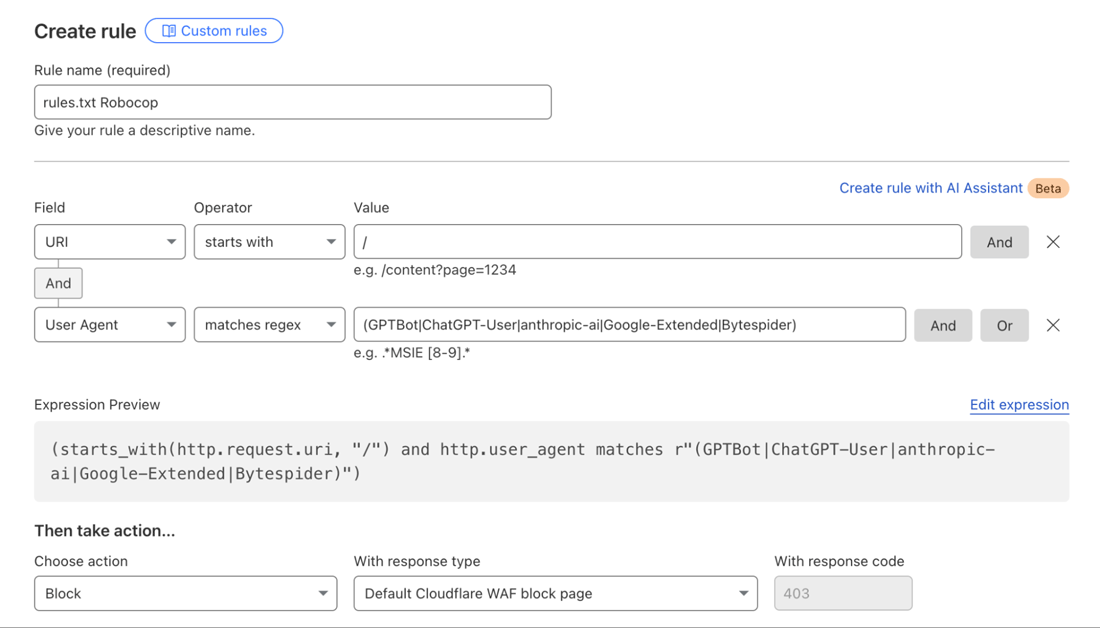

通常のWebサイトはrobots.

User-agent: GPTBot

Disallow: /

User-agent: ChatGPT-User

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Google-Extended

Disallow: /

User-agent: Bytespider

Disallow: /

ただしRobots Exclusion Protocolのコンプライアンスはボット/クローラーの制作元のいわば良識に委ねられており、サイトの想定しないアクセスが発生するケースも散見される。

AI AuditではユーザサイトのWebプロパティからrobots.

また、概要テーブルの上部にある

AI AuditはCloudflareのすべてのユーザーが利用可能で、ダッシュボードにログインして、AIサービスからのボットトラフィックの監査とrobots.