「データ分析をする」「機械学習を行う」という現在身近に聞かれる言葉の裏側を支えているのがデータ分析基盤(data analytics platform、data platform for analytics)です。データ分析基盤が扱うデータの種類はさまざまで、たとえば、

- モビリティデータ(車やバイク)

- 購入時の決済データ

- 環境データ(温度や湿度など)

といったバイナリデータとして表現できるものであれば、なんでも対象となり得ます。

データ分析基盤を中心としたデータ活用の三つの工程

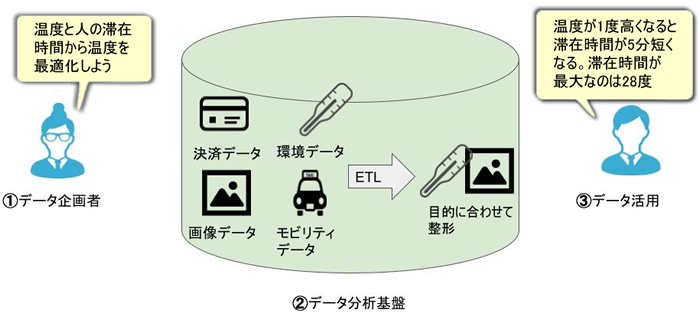

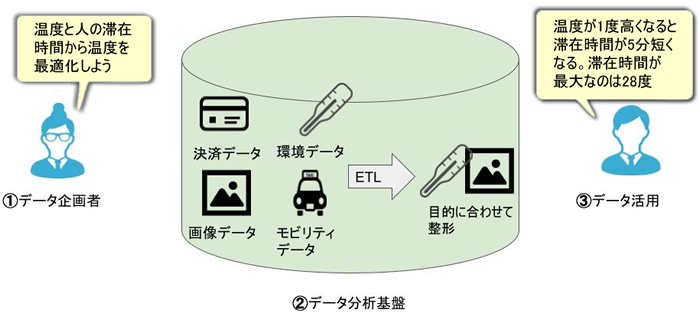

データ分析基盤を中心としたデータ活用には、大きく分けて3つのアクティビティがあります。

- ①データ活用のための企画を作成

- ②データを集め処理して蓄積

- ③データ分析を行い、データ活用を実現

データ分析基盤を中心としたデータ活用の流れ

データ分析基盤のメインの役割は①と③をスムーズに行えるように間を取り持つことです。

まず①の企画の段階では、最終的にデータをどのように視覚的に表現するのか、もしくはアプリケーションとして落とし込むのかを考えます。データ分析基盤ができることが多く、機能制限が少なければ、より良い効果を生み出すチャンスが高まります。

③で行うデータ分析とは、データ分析基盤内のデータの中から関係やパターンを見つけ出す作業で、たとえば、予実を確認するべく、データを確認すると、

- >「予定:A」「実績:B」

- >となっており、予定と乖離していた

というデータからわかる事実を発見するような作業です。

データ活用を実現するために

データ活用とは、データ分析を通して物事を客観的に人間や機械が判断して最適化していくことを指します。たとえば、「環境データ」と「人の映った画像データ」を組み合わせて、温度と人の滞在時間を分析し、最適な温度を設定するといった形です。

③を達成するためにデータを利用するのですが、データがはじめから想定どおりの状態になっていることはまずなく、ETL(Extract transform and load)を通して、データを使いやすい形に変更していきます。たとえば、「モビリティデータ」のように逐次流れてくるセンサーデータを「ストリーミングデータ」(streaming data)として1レコードずつ(もしくは数分単位ずつ)処理を行ったり、「購入時の決済データ」のようにリレーショナルデータベース(relational database)から一日分のデータを取り込み、一度に処理を行うバッチ(batch)処理を行っていく作業がETLです。

ELT処理の種類は様々で、他のデータと掛け合わせてみたり、モデリングしてよりデータを利用しやすい状況を作り上げていきます。

そして、データ分析ツールの王道であるBI(Business intelligence)ツール(SQLなどを通してデータの可視化を実現するツール)を通して、データ分析の結果から改善のための施策を立案・実施することで、データ活用の一連の流れが完了します。