7月8日、東京・ベルサール汐留において「Hadoop Conference Japan 2014(主催: 日本Hadoopユーザ会) 」が開催されました。2009年の初開催以来、今回で5回目となる同カンファレンスですが、今回の参加登録者数約1,300名のうち、65%(約840名)が初参加とのこと。「 Hadoopの裾野の拡がりを確実に感じる」( NTTデータ 濱野賢一朗氏)との言葉通り、HadoopもHadoopユーザもこの5年で大きく変化を遂げていることを示したカンファレンスとなりました。

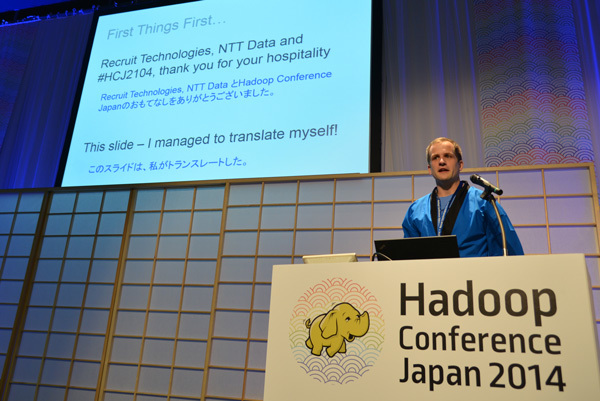

基調講演会場の模様。今回のテーマは「和風」 、来場者には扇子が配られ、登壇者は障子をバックにはっぴ姿で講演を行いました

本稿では基調講演の内容をもとに、最初に公開されてから10年という歳月を迎えようとしているHadoopが、いまどのような状況に置かれ、どう変化しようとしているのかをお伝えしたいと思います。

「YARN」がもたらすHadoopの進化

基調講演は3本立ての構成で行われました。Hadoop生みの親で現在はClouderaでチーフアーキテクトを務めるダグ・カッティング(Doug Cutting)氏、いま最も旬なHadoopエコシステム「Apache Spark」の主要開発者でDatabricksに所属するパトリック・ウェンデル(Patrick Wendell)氏、そしてもはやHadoopスタートアップという存在を超えた感のあるTreasure DataのCTOである太田一樹氏という豪華メンバーが立て続けにプレゼンを行うということで、基調講演会場は満員の様相を呈していました。

満席の基調講演会場

なお、本カンファレンスは毎回リクルートテクノローズが全面的にスポンサードしており、会場手配から参加者全員に配られるステッカーやお弁当(7種類から選択可能)まで、すべて同社により提供されています。最初に挨拶を行ったリクルートテクノロジーズ 執行役員 CTO 米谷修氏は「リクルートテクノロジーズが今回もこのカンファレンスをサポートできることを光栄に思う」と語っていますが、参加費無料で1000名超のイベントをこうした環境で開催すること自体、同社の協力がなければ難しかったと思われます。

開会挨拶を行うリクルートテクノロジーズ 米谷修氏

基調講演に先立ち、日本Hadoopユーザ会会長の濱野氏がHadoopの概況について説明を行いました。カンファレンスの初参加者が増えているという事実にも表れているように、Hadoopが初心者を含む新規ユーザを継続的に取り込めている理由として、濱野氏は「全件データをなめるような読み込みのスループットを最大化することに特化した、シンプルな分散処理システムだったことが大きい」と語っています。サーバの台数が増えれば増えるほどスループットが出るという、シンプルでわかりやすく、オープンな作りに多くの開発者が「ぐっときた」と濱野氏。Hadoopが世界ではじめて普及することに成功した並列分散処理環境となった背景にはシンプル&オープンというHadoopの根幹を成す思想が大きく影響しているようです。

シンプル&オープンはいまも変わらないHadoopの屋台骨ですが、誕生から10年も経てば世の中の流れとともにソフトウェアもまた変化を免れません。現在、HadoopはHiveをはじめとする数多くのエコシステムを抱えており、また、Apache Hadoop以外にも企業向けディストリビューションがいくつも存在します。そうした中にあって、現在Hadoopが直面している最も大きな変化はYARN(Yet Another Resource Negotiator)の隆盛であると指摘します。

もともとHadoopは、JavaをベースとするプログラミングモデルMapReduceとともに発展してきました。MapReduceのアルゴリズムに従ってアプリケーションを記述すれば、処理の実行中に障害が発生してもリカバリが可能というしくみは、Hadoopがひろく一般に普及する大きな要因となりました。しかしここ最近、MapReduce以外のアルゴリズムを動かしていこうとする流れが顕著になっており、その象徴的存在が新フレームワークのYARNであると濱野氏は言います。今回のカンファレンスではYARNのセッションが数多く組まれていますが、そうしたトレンドを重視したとのことです。

「Hadoopは絶賛進化中」と語る日本Hadoopユーザ会会長 濱野賢一朗氏

もっとも「MapReduceは決して終わった存在ではなく、その手堅さからこれからも残っていくはず。だがデータ処理の流れは確実に変わっており、今後は複数の並列分散処理システムを併用していくスタイルが主流となるだろう。そしてYARNはその流れを支える中心的存在」と濱野氏。しばらくはYARNの動向がHadoopの進化に大きく影響を及ぼしていくことになりそうです。

Hadoopに移行できない処理は存在しない─ダグ・カッティングの語るHadoopの未来

基調講演のトップバッターに立ったのはHadoopの生みの親として、そしてApache Software Foundationのボードメンバーとしても名高いダグ・カッティング氏。現在はClouderaのチーフアーキテクトも務めています。

ダグ・カッティング氏。今回通訳がなかったため、ゆっくりとわかりやすい言葉で来場者に語りかけていました

「The Future of Data」と題されたキーノートでは、はじめに「私は未来を予測することはできない。だが現在のファクト(データ)からいくつかの真実を予測することはできる」と前置きし、いくつかのファクトを挙げながら、そこから推測される近い未来の可能性について提示していきました。

ハードウェア価格はより安くなっている → より多くのデータをストアできるようになる

データの価値はさらに高まっている → データを有効活用した企業が競争相手に勝利する

オープンソースが勝ち残っている → プラットフォームテクノロジはオープンソースであることがマストになる

Hadoopは成長を続けている → さらに成長を続け、よりソリッドなシステムとなり、データ処理のOS的存在となる

Hadoopがあたりまえの存在になり多くのエコシステムが誕生している → 今後もより多くのツールやシステム(ストリーミングシステムやグラフプロセッシングシステムなど)がHadoopに追加されていく

Hadoopにはコンペティターが存在しない、Hadoopがビッグデータを席巻している → トラディショナルなデータベースやデータウェアハウスからHadoopへのデータ移行が加速し、サイロ化したシステムが減少する

(いまはまだ不十分だが)トランザクション処理でさえHadoop上での実行が可能に → Hadoopでできない処理はほとんどなくなる

筆者は今回、カッティング氏に単独インタビューする機会に恵まれたのですが、その席上でも同氏がオープンソースへの強いこだわりを見せていた姿が非常に印象的でした。ご存知の方も多いと思いますが、カッティング氏はHadoopだけでなくLucene(現在はApache Lucene )やNutchといったオープンソースの検索システムを過去に作り出しています。そうした経験からも、オープンソースこそが開発リスクを低減する唯一のプラットフォームであるという強い信念を抱いているようです。プラットフォームテクノロジ、とりわけデータ分析にかかわる部分は「オープンソースであることが"要求"されるようになる」と強調していたカッティング氏ですが、プロプライエタリを含め数あるコンペティターの存在を消し去ってきたHadoopプロジェクトを生み出し、いまもトップにいる人の言葉には強い確信と高い可能性があふれています。

オープンソースこそが勝ち残りへの道

もうひとつ興味深かったのは、Hadoopがトランザクション処理の実行環境にもなろうとしている点です。HadoopといえばデータのストアやBIのような分析の基盤というイメージですが、カッティング氏は「Hadoopに移行できない処理はほとんど存在しないと思っている。Googleが2年前に発表したGoogle Spanner(全地球規模の並列分散処理データベース)のように、いまは満足にできなくても近い将来必ずHadoopでできるようになる」と明言しています。「 Hadoopと同じプロセッシングができるソフトウェアは少ないが、ほかのソフトウェアでできるプロセッシングでHadoopができないことはほとんどない」( カッティング氏) ─今後のHadoopの機能強化/追加に引き続き注目が必要ですね。

そしてここまでの予測を総合し、最後にはHadoopが「エンタープライズデータハブ」になるとカッティング氏はまとめています。ハードウェアが安く強力になり、より多くのデータがストアできるようになった現在、データ分析の基盤となるプラットフォームは誰もがいつでもどこでも使えるコストと利便性、そしてプラットフォーム自体が成長する余地を備えていなければならず、必然的にオープンソース以外の選択肢はないというカッティング氏。そしてあらゆるプロセッシングの中心にはHadoopがあり続けると断言します。「 我々はまだデータプロセッシングの革命の途上にある。だが最も安全な道を選ぶとすればそれはHadoop」 ─数年後、ダグ・カッティングの未来予測ははたしてどこまで実現しているのでしょうか。

Apache Sparkが開くHadoopの新たな1ページ

カッティング氏に続いて登壇したのは、いまHadoopエコシステムの中でも最もアツいと言われている「Apache Spark」の主要開発者 パトリック・ウェンデル氏です。ウェンデル氏はSparkの開発に深くコミットしているシリコンバレーのビッグデータベンチャー Databricksに所属しており、日々の活動のほとんどをSpark開発に費やしています。

自ら翻訳したプレゼン資料を披露するパトリック・ウェンデル氏

成長著しいオープンソースプロジェクトだけあって、Sparkコミュニティの活動は非常に活発で、1週間で500件ものパッチ投稿/修正が寄せられるそうです。メーリングリストやGitHubなどでのディスカッションも多く、つねに何らかの修正や追加がソフトウェアに加えられている状況にあります。

このように急激な成長を続けているSparkですが、プロジェクトを継続させるには安定性も欠かせません。Sparkは今後、どのようなゴールを目指して開発を進めていこうとしているのでしょうか。

ウェンデル氏はまずSparkプロジェクトの目的として

データサイエンティストやエンジニアの能力のパワーアップ

表現力のあるクリーンなAPI

さまざまな環境をまたいで動作する実行環境

パワフルな標準ライブラリ

の4つを挙げ、これらを継続的に開発者やユーザに提供していくことを掲げています。とくにAPIに関しては、5月末にリリースした初の標準APIである「Spark 1.0」が登場して以来、アプリケーションプラットフォームとしての安定性が飛躍的に高まったと強調しています。「 リリースサイクルはできるだけデベロッパフレンドリになるように心がけており、マイナーリリースは3ヵ月ごと、メンテナンスリリースは必要に応じて提供していく。だがパッチリリースに関しては慎重に行っていく方針」( ウェンデル氏)

Sparkの構成は大きく2つに分かれており、プロセッシングの要となるエンジン「Spark Runtime」とその上で動く複数のライブラリが存在します。ライブラリにはグラフプロセッシングの「GlaphX」やリアルタイムストリーミング処理の「Spark Streaming」などがあり、ウェンデル氏は「Sparkの未来はライブラリにある」と言い切るほど重要視していますが、その中にあって現在最もホットなライブラリは「Spark SQL」とのこと。 SQLおよびスキーマ型のメカニズムをサポートするコンポーネントです。現在、Spark SQLにおいて優先的に取り組んでいる課題は「クエリ最適化」「 言語の拡張」「 インテグレーション」の3つだとウェンデル氏。とくにインテグレーションにおいては、HiveデータやNoSQLデータだけでなくOracleやSAPといったプロプライエタリなRDBデータとのスムースな統合も目指しているそうで、今後の機能強化が期待されます。

ウェンデル氏によるとSpark SQLは“ スパーク スィークル” と発音します

なお、ウェンデル氏が所属するDatabricksでは、クラウド上でSparkクラスタを利用できる「Databricks Cloud 」を提供しています。壇上ではウェンデル氏によるDatabricks Cloudのデモが披露され、クラウド上でScalaを使ってアドホックな分析結果をビジュアルかつダイナミックに表示するNotebookを作成するさまに、会場からは歓声も聞こえてきました。

簡単なデモでTwitterの1日のデータストリームを解析してみせるウェンデル氏。英語のつぶやき(赤いグラフ)と日本語のつぶやき(緑のグラフ)の活動時間帯がちょうど反転しています

「Sparkは次の1年も十分な成長を遂げていく」と最後に明言したウェンデル氏。革新性と安定性という両立がむずかしい課題にあえてチャレンジしていく姿はとても力強く見えます。こうした意欲的なプロジェクトや開発者がHadoopの周辺につねに生まれているのであれば、カッティング氏の予測にもあるとおり、Hadoopでできないデータ処理はなくなるのかもしれません。

ユーザであっても“データ処理のトレンド”に無知では生き残れない

基調講演のトリを務めたのは前回のカンファレンスにも登壇したTreasure DataのCTOである太田一樹氏です。前回のカンファレンスから1年半が経過した現在、Treasure Dataはビジネスステージを一段アップさせ、国内企業の導入事例も多く発表しており、従業員数も50名を超え、もはやHadoopベンチャーというのがはばかられるほどに大きな成長を遂げました。

Treasure Data CTO 太田一樹氏

企業もソフトウェアも成功を目指すなら変化することは免れません。Treasure Dataが確実にステップアップしていったように、Hadoopもまた開発スタートから10年を迎え、世界でもトップクラスの規模を誇るオープンソースプロジェクトに成長しました。しかしその反面、エコシステムを含むプロジェクトが大きくなりすぎて「Hadoopとはなにか、という問いに簡単に答えることができなくなっている」と太田氏は指摘します。巨大化/複雑化してしまったHadoopプロジェクトをあらためて問い直し、Hadoopにおける価値と進化をあらためて見つめなおす"羅針盤"のようなキーノートになれば、という太田氏のプレゼンの内容は、羅針盤という言葉通り非常にわかりやすく示唆に富んだものでした。

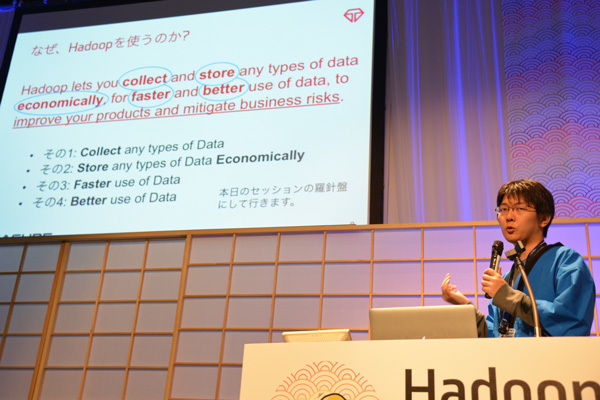

まず太田氏が触れたのは「Hadoopをなぜ使うのか、本当にHadoopが最適な解なのか」という点です。現在、500以上のプロダクトが存在するというデータベースの世界にあって、なぜ人々はHadoopを使うのでしょうか。太田氏はこの問を何人かに投げかけてみたところ、もっとも多く返ってきた答えは「安いストレージとして使えるから」というものでした。たしかにオープンソースのHadoopであればコストを抑えながら大量のデータを格納しやすくなります。しかし太田氏は「いまはCephやGlusterFSなどストレージに特化したオープンソースプロダクト(いずれもRed Hatが買収済み)が存在しており、Hadoopの価値をストレージに置くのはどうか」と指摘します。

では太田氏が思うHadoopの価値とは何なのか。太田氏はこれを

Hadoop lets you collect and store any types of data economically , for faster and better use of data, to improve your products and mitigate business risks .

(Hadoopはユーザにどんなタイプのデータでも収集し、経済的にストアすることを可能にする。そのことはより速く、よりうまくデータを利用することにつながり、プロダクトを向上させ、ビジネスリスクを軽減するのに役立つ)

と英語で説明し、重要なキーワードとして「Collect any types of Data」「 Store any types of Data Economically」「 Faster use of Data」「 Beter use of Data」の4つを挙げています。単にデータをストアするだけでなく、データの収集/経済的なストア/高速な利用/上手な利用を可能にするからこそ、Hadoopを使い意味があるというわけです。

「なぜ、Hadoopを使うのか? -2014年夏」これが正解だ!

そしてHadoopプロジェクトおよびエコシステムもこの4つのポイントに沿って進化していると太田氏は言います。たとえばデータを収集するツールにはTreasure Dataが中心となって開発しているFluentdや、Apache Kafka、Apache Flumeなど数多く存在します。また、データのストアにおいてもファイルフォーマットの進化がめざましく、経済的効率を高めるための支援ソリューション(管理支援ソフトウェア、PaaSやSaaSによるサービス提供)も最近では増えてきています。データを速く簡単に扱うという面においては「クラスタリソース管理やストリーム処理の分野、あるいはDAG型やインメモリといった分野がアツい」と太田氏。さらにYARNやApache TezやApache Sparkなど現在Hadoopプロジェクト全体をけん引する勢いがあるのもこの分野だといいます。そしてデータをうまく扱うためのしくみとしてはSQL-on-HadoopやImpala、Mahoutといったコンポーネントがあり、太田氏によれば「今回のカンファレンスでもっとも注目されている分野でセッションも数多く用意されている」とのこと。

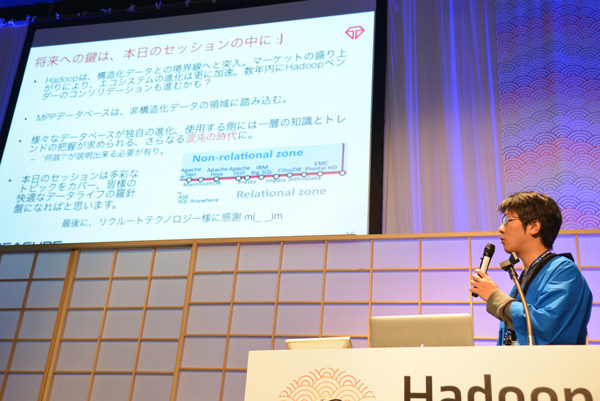

一方でHadoop以外のデータベース、とりわけトラディショナルなRDBMSも着実に進化を遂げていることも忘れてはいけない事実です。「 TeradataやNeteeza、Greenplumなどはシェアードナッシング型のMPP(Massively Parallel Processing)アーキテクチャを採用しており、これらはBI製品との親和性も高く、何よりSQLとしての完成度が非常に高い。複雑な処理も難なくこなせる。そしておもしろいのはこれらのプロプライエタリベンダが最近ではHadoop対応を強調していること」と太田氏が指摘する通り、こうしたRDBベンダはスクラッチから開発を行えば10年近くかかるようなクエリプランナーやオプティマイザを自前でもっているため、SQL-on-Hadoopなどに比べてもはるかに高速な処理が可能になります。スキーマを設計しなければならないという大きなディスアドバンテージはあるものの、最近ではJSONなどの準構造化データをストアできる機能を搭載したRDBも登場しており、そうした意味でHadoopとRDBMSの垣根は徐々に曖昧になりつつあると太田氏は説明します。

そしてデータをめぐるトレンドを知るには、Hadoopカンファレンスに参加すべし!

Hadoopおよびデータベースをめぐるこうした状況において、ではユーザサイドはどのような心づもりでデータおよびHadoop/データベースに向き合っていくべきなのでしょうか。太田氏は現在、データベースにおける最大の課題は「スキーマ管理によるビジネスの分断」だと指摘します。データを活用したいビジネスユーザはBI担当者に「こういうレポートが欲しい」とあれこれ注文をつけますが、BI担当者はビジネスのニーズを理解しているわけではないので、あくまでスキーマ設計に基づいた分析結果しか渡せません。場合によっては何日も何週間もかかることも起こり得ます。しかしHadoopのように生のデータをいかような形態でもストアできる環境、スキーマを意識することなくデータを扱える環境であれば、ビジネスユーザのリクエストを正確に反映したレポートを迅速に作成しやすくなります。「 データを把握してビジネスをわかっている人が自分でレポートを作れるようになる、そういう時代が本当にやってきている。ここの流れに取り残されてしまうと、Hadoopをうまく使えないというより、データを使いこなせないという事態に陥ってしまう」と太田氏。データへの向き合い方を間違えるとビジネスの負け組になるという時代はもうすでに到来しているのかもしれません。

データの負け組=ビジネスの負け組にならないためには、「 ユーザサイドが知識とトレンドをしっかり把握する必要がある」と太田氏は強調しますが、これは非常に重要なポイントだといえます。現状のトレンドは「Hadoopにすべてのデータを集約し、つねに書き込みが行われている状態を保つ。そしてそこから集計したデータをMPP型データベースに保存し分析を行う」というもので、たとえばTwitterにおけるHadoop + Vertica、EvernoteにおけるHadoop + ParAccell、PinterestにおけるHadoop + Redshiftなどが実装例になります。そして今後は、Hadoopは構造化データの領域に、逆にMPP型データベースは非構造化データの領域にそれぞれ踏み込む傾向が強くなっており、先にも触れたとおり、両者の境界線はますます曖昧になってきています。また、主要HadoopディストリビューションのベンダであるClouderaやHortonworksも市場の拡大を受け、ビジネスが大きく変化するときにきています。こうした混沌の時代だからこそ、データベースを使う側、ビジネスを行う側のユーザの態度が重要になります。現状の技術トレンドを積極的に取り込む姿勢をつづければ、自社が使うシステムに対し、「 我々はなぜそれ(Hadoop)を使うのか」という問に答えつづけていくことができるのではないでしょうか。

Hadoopの世界を代表する3人のエキスパートによるキーノートは、2時間弱という短い時間ながらも、Hadoopプロジェクトの根幹となるフィロソフィーと現在のトレンドをうまくバランスさせた非常に充実した内容でした。自分はなぜHadoopにかかわるのか、なぜHadoopでなければいけないのか、いまHadoopで何をしたいのか ─Hadoopユーザのひとりひとりが自問自答することで、日本のHadoop利用シーンはまた大きく成長していくように思えます。

[フォトレポート]世界よ!これが日本のHadoopカンファレンスだ!

登壇者は皆障子の向こうからシルエットになり登場する演出。太田さん曰く「かなり恥ずかしいです」

…のはずが、ダグ・カッティングさんはあまりの長身のためアタマが…

一見、不気味?に見えるHadoopのマスコットの象さんも、日本のクリエイターにかかればこの通り

前回好評だった豪華お弁当(無料サービス)は今回ももちろんご提供。豪華です!