目次

第1章 深層学習超入門

- 1.1 11行で書ける深層学習AIプログラム

- 1.2 環境のセットアップ

- 1.2.1 深層学習のためのマシン構成

- 1.3 ソフトウェア環境のセットアップ

- 1.3.1 Gitとpipをインストールする

- 1.3.2 OpenCVをインストールする

- 1.3.3 CUDAをインストールする

- 1.3.4 Chainerをインストールする

- 1.3.5 Deelをインストールする

- 1.4 手軽に画像認識を試す

- 1.5 カメラに写ったものをリアルタイムに認識する

- 1.6 ビデオから物体認識する

- 1.7 どうして画像認識できるのか?

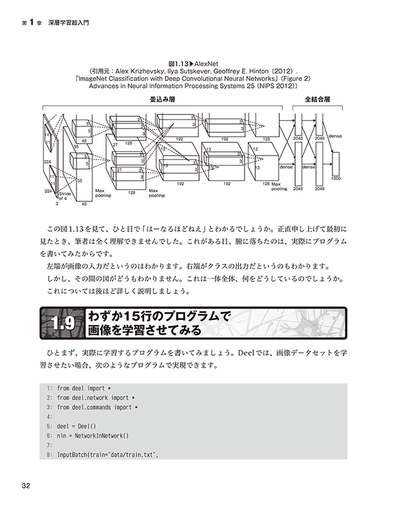

- 1.8 畳込みニューラルネットワークで画像をクラスに分類する

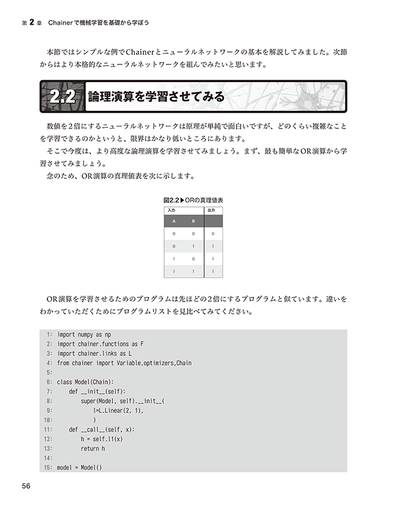

- 1.9 わずか15行のプログラムで画像を学習させてみる

- 1.10 本格的に学習させてみよう

- 1.10.1 深層学習のためのGUI環境CSLAIERのインストール

- 1.10.2 学習データセットの作り方

- 1.10.3 学習をさせてみよう

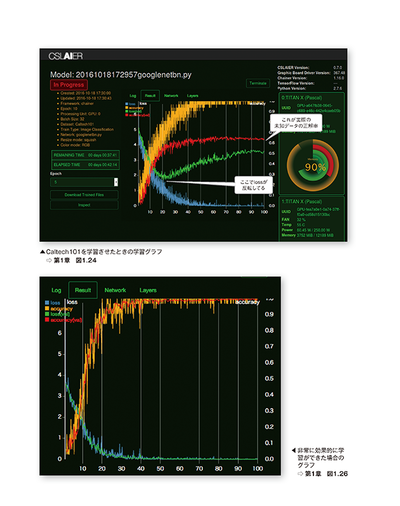

- 1.10.4 学習グラフを見るコツ

- 1.10.5 うまく学習させるためのコツ

第2章 Chainerで機械学習を基礎から学ぼう

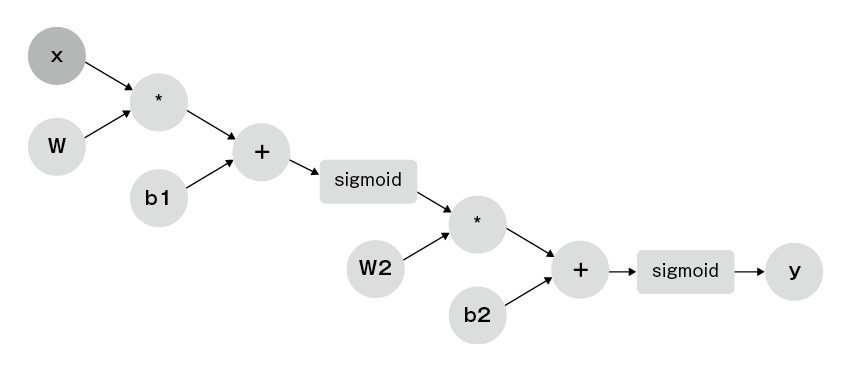

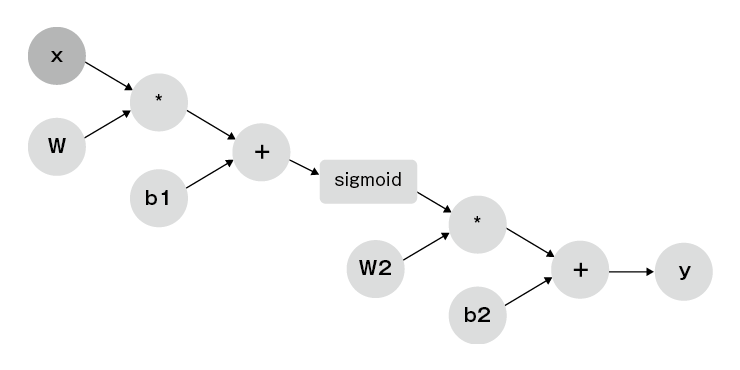

- 2.1 最も簡単なニューラルネットワーク

- 2.2 論理演算を学習させてみる

- 2.3 畳込みニューラルネットワーク(CNN,Convolutional Neural Network)

- 2.4 畳込みニューラルネットワークのいろいろ

- 2.5 学習させた畳込みニューラルネットワークをPythonから利用する

第3章 リカレントニューラルネットワークのプログラミング

- 3.1 入力するたびに答えが変わるニューラルネットワーク

- 3.2 CSLAIERによるLSTM

- 3.3 LSTMによるプログラミング

- 3.4 学習させたデータからの推定

第4章 TensorFlowを学ぼう

- 4.1 分散計算に適した本格的なフレームワーク「TensorFlow」

- 4.2 TensorFlowのインストール

- 4.3 テンソルとは?

- 4.4 Hello, TensorFlow

- 4.5 ChainerとTensorFlowを比較しながら学ぶ

- 4.6 TensorFlowでの画像分類(Inception-v3)

- 4.7 会話ロボットはここまで喋れる!?

- 4.8 TensorFlowのseq2seqで英仏自動翻訳ニューラルネットワークを作ろう

第5章 深層強化学習 Deep Q Learning

- 5.1 強化学習とは?

- 5.2 DQNとは?

- 5.3 LIS,Life In Silico(CNNとDQNの組み合わせで作る人工生命)

- 5.4 LIS のインストールと実行

第6章 深層学習のこれから

- 6.1 名画のタッチを真似する人工知能

- 6.2 写真から説明文を生成 その逆も可能!? 意訳し,創作する人工知能

- 6.3 超解像からビッグデータ解析まで,深層学習の本命 オートエンコーダ

- 6.4 積層オートエンコーダによるビッグデータ解析

- 6.5 畳込みニューラルネットワークのファインチューニング

- 6.6 複雑なAIをよりシンプルなAIに学習させる「蒸留」

- 6.7 人工知能と生体知能の類似性と違い

- 6.8 おわりに